一種域轉移的自監督機器異常聲音檢測方法

1.本發明涉及計算機技術領域,尤其涉及一種域轉移的自監督機器異常聲音檢測方法。

背景技術:

2.異常聲音檢測任務是通過機器發出的聲音來判斷機器是否故障,利用正常聲音信號來訓練模型,從而使模型學習到更好的概率分布,擬合異常聲音信號,檢測出異常聲音信號,進行機器的故障檢測。但是在實踐訓練場景中由于機器運行條件的物理參數變換,引起正常聲音信號的波動,導致正常聲音信號檢測為異常聲音。

3.最近大量的基于深度學習的自監督異常聲音檢測方法被應用于檢測任務。它們主要分為基于自編碼器方法、基于流的自監督密度估方法和自監督分類方法。基于自編碼器的方法是先通過編碼器將輸入特征映射到低維度向量,再由解碼器將低維度向量空間中的特征向量還原為輸入特征,雖然該類方法在檢測的時候有效,但是在訓練過程涉及異常或不平穩的聲音信號,這類方法將會得到很大的限制;基于流的自監督密度估方法通過使用歸一化流來區分該機器身份的正常聲音信號和異常聲音信號,從而提高了模型檢測單類機器異常聲音的效果。但是該類方法需要對每一類機器下不同機器身份進行同一分布采樣,導致該類方法的檢測穩定性有限,自監督的檢測方法是將所有的機器類型和機器身份一起傳入模型進行訓練,并采用對數似然或分類置信度計算異常分數,雖然該類方法在性能上比基于自編碼器的方法和基于自監督密度估的方法更好,但是該類方法對于聲音信號的域偏移特征學習能力不高,導致檢測效果不穩定。

技術實現要素:

4.本發明的目的在于提供一種域轉移的自監督機器異常聲音檢測方法,旨在解決現有檢測方法學習不同域轉移的聲音特征,檢測效果不穩定的問題。

5.為實現上述目的,本發明提供了一種域轉移的自監督機器異常聲音檢測方法,包括以下步驟:

6.分別設計時頻域特征提取網絡、動態圖卷積網絡和域自適應網絡;

7.通過所述時頻域特征提取網絡捕獲所述特征向量的空間特征信息和時域交互的特征信息,得到特征向量;

8.通過所述動態圖卷積網絡捕捉所述特征向量的域轉移之間的依賴關系;

9.基于所述依賴關系通過所述域自適應網絡補償所述特征向量,得到檢測結果。

10.其中,所述通過所述時頻域特征提取網絡捕獲所述特征向量的空間特征信息和時域交互的特征信息,得到特征向量的具體方式:

11.利用短時傅里葉變換和對數梅爾提取所述特征向量的時域特征;

12.利用所述時序特征網絡捕獲短時傅里葉變換和對數梅爾譜丟失的時域特征,并將丟失特征和時頻域特征進行了相加,傳入令牌轉換器網絡;

13.將所述時頻域特征傳入所述令牌轉換器網絡進行空間變換和空間關系的建模,得到特征向量。

14.其中,所述通過所述動態圖卷積網絡捕捉所述特征向量的域轉移之間的依賴關系的具體方式:

15.利用不變域轉移模塊從所述特征向量針對機器id間的粗標簽依賴關系進行感知建模,得到感知模型;

16.基于所述感知模型利用可變域轉移模塊捕獲機器id內的域轉移特征之間細微關系。

17.其中,所述通過所述域自適應網絡補償所述特征向量的具體方式:

18.計算不同域轉移下的所述特征向量之間的二階協方差距離,得到距離差;

19.利用反向梯度傳播算法減少所述距離差。

20.其中,所述計算二階協方差距離時,定義源域特征和域轉移后的目標特征。

21.本發明的一種域轉移的自監督機器異常聲音檢測方法,分別設計時頻域特征提取網絡、動態圖卷積網絡和域自適應網絡;通過所述時頻域特征提取網絡捕獲聲音信號的空間特征信息和時域交互的特征信息,得到特征向量,提高了域轉移下機器異常聲音檢測的性能穩定性,通過所述動態圖卷積網絡捕捉所述特征向量的域轉移之間的依賴關系,提高了模型對域轉移特征感知能力,加深了模型對域轉移特征的敏感度,通過所述域自適應網絡補償所述特征向量,能補償由于域移動造成的模型性能下降,提高了自監督環境下模型對異常聲音的域轉移自適應能力,解決現有檢測方法學習不同域轉移的聲音特征,檢測效果不穩定的問題。

附圖說明

22.為了更清楚地說明本發明實施例或現有技術中的技術方案,下面將對實施例或現有技術描述中所需要使用的附圖作簡單地介紹,顯而易見地,下面描述中的附圖僅僅是本發明的一些實施例,對于本領域普通技術人員來講,在不付出創造性勞動的前提下,還可以根據這些附圖獲得其他的附圖。

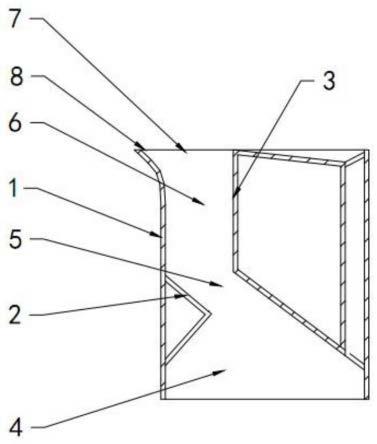

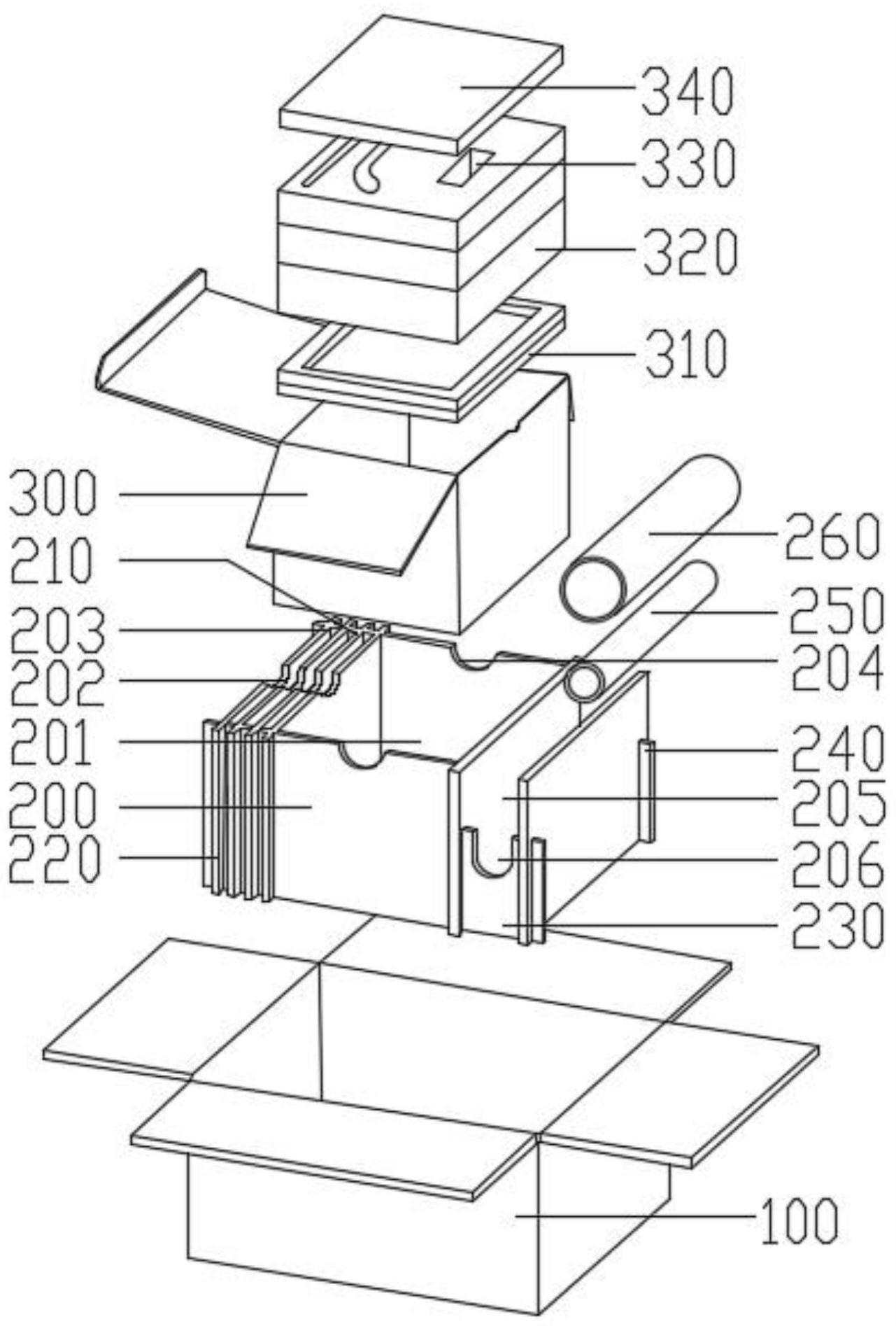

23.圖1是本發明提供的一種域轉移的自監督機器異常聲音檢測模型示意圖。

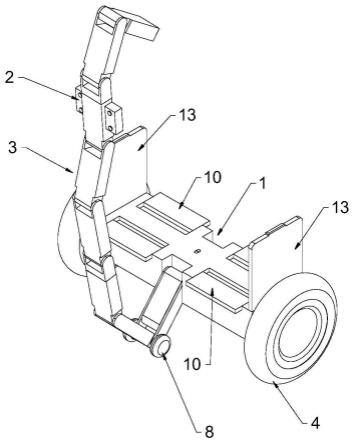

24.圖2是本發明提供的特征提取網絡結構圖。

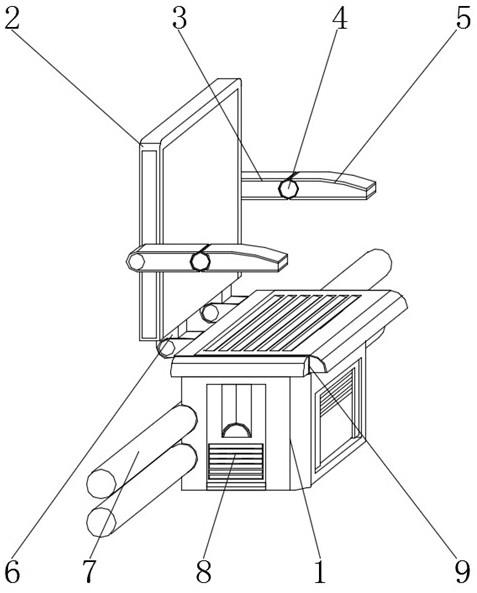

25.圖3是本發明提供的特征提取網絡示意圖。

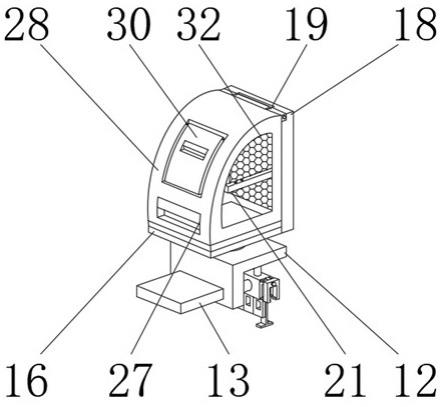

26.圖4是發明提供的transformer示意圖。

27.圖5是發明提供的動態圖卷積網絡的總體架構。

28.圖6是發明提供的transformer和時序特征網絡的語譜圖。

29.圖7是發明提供的各模型的時頻域特征可視化示意圖。

30.圖8是發明提供的使用了t-sne對模型提取的特征圖進行了可視化示意圖。

31.圖9是本發明提供的一種域轉移的自監督機器異常聲音檢測的流程圖。

具體實施方式

32.下面詳細描述本發明的實施例,所述實施例的示例在附圖中示出,其中自始至終相同或類似的標號表示相同或類似的元件或具有相同或類似功能的元件。下面通過參考附

圖描述的實施例是示例性的,旨在用于解釋本發明,而不能理解為對本發明的限制。

33.請參閱圖1至圖9,本發明提供一種域轉移的自監督機器異常聲音檢測方法,包括以下步驟:

34.s1分別設計時頻域特征提取網絡、動態圖卷積網絡和域自適應網絡;

35.s2通過所述時頻域特征提取網絡捕獲聲音信號的空間特征信息和時域交互的特征信息,得到特征向量;

36.具體方式:

37.s21利用短時傅里葉變換和對數梅爾提取所述特征向量的時域特征;

38.具體的,采用了短時所述傅里葉變換和所述對數梅爾頻譜對所述聲音信號 xv∈r1×

t

進行變換,并得到了合適大小的時頻域特征,表達式如下所示:

[0039][0040][0041]

其中h(t)為窗函數。g(t,f)為關于時間t和頻率f的時頻域特征。表示梅爾過濾器組,i表示頻譜特征的維度,b表示通過短時傅里葉變換得到的頻譜圖頻率箱數。xm表示對數梅爾頻譜增強后的時頻域特征。

[0042]

s22將所述時域特征傳入時域特征提取網絡進行空間變換和空間關系的建模,得到特征向量。

[0043]

具體的,然后利用所述時序特征網絡捕獲短時傅里葉變換和對數梅爾頻譜異常丟失的時域特征,并將丟失特征進行了相加,傳入令牌轉換器網絡,最后利用所述令牌轉換器網絡對時頻域特征進行局部和全局的自適應特征的空間變換和時空關系內在聯系建模。

[0044]

其中,時序特征網絡:短時傅里葉變換和對數梅爾頻譜提取時頻域特征容易丟失聲音中異常的時序信息。tgramnet網絡從聲音信號xv中彌補缺失的時序信息。雖然tgramnet采用了大核的一維卷積進行時序特征提取,但是一維卷積在長序列中難以發現可靠的時序特征依賴關系。近期etdnet使用transformer 來捕捉時序特征之間的依賴關系,但是transformer使用稀疏注意力機制,在計算量上不僅具有二次復雜度,而且不能充分對聲音信號的時序特征進行局部和全局關系建模。因此,我們提出時序信號處于不同周期時相同位置的子序列往往具有相同的趨勢,可以根據子序列的相似性來捕捉時序特征的理論依據。于是我們設計了時序特征網絡網絡,如圖2所示,該網絡能以更少的計算量,更好利用子序列的相似度捉到異常時序特征。在時序特征網絡網絡中,首先利用了一維卷積將聲音信號沿著時間維度進行編碼。然后使用自相關編碼模塊來匯聚相似的子序列信息并代替transformer中點向連接自注意力機制。該機制不僅將編碼后的聲音信號進行了內在時間特征相似性特征捕捉,而且使計算量下降為o(l log l),其表達式如下所示。

[0045][0046][0047]

[0048]

其中arg topk(

·

)表示獲取k個自相關子序列的參數。表示根據時間窗口滑動k個周期長度的子序列τ1,

…

,τk。是時間序列q和k之間的自相關權重。表示對齊周期、相位相似的子序列。

[0049]

最后,對于長度維l的編碼后的聲音序列xa∈r

l

×c,利用了series decompblock提取輸入的高階時間信息和模型中間隱藏的高階時間信息,其表達式如公式如下所示。

[0050]

xs=avgpool(padding(xa))

[0051]

x

l

=x

a-xs[0052]

其中xs∈r

l

×c表示時間序列的短期波動,padding表示使用滑動窗口的方式對聲音序列特征兩端的補0,avgpoo表示全局平均池化操作,x

l

∈r

l

×c表示時間序列的周期性波動。另外,我們同樣在時序特征網絡網絡按照transformer的設計加入了帶全連接的前饋網絡層,使網絡更好地將提取時序特征聚類到一起。

[0053]

其中,令牌轉換器:特征提取網絡在提取時頻域特征時旨利用更少的參數量就能夠對輸入的時頻域特征充分進行全局和局部信息建模,因此我們設計了所述令牌轉換器網絡,如4所示。在時頻域特征局部空間信息建模中,我們采用了focus模塊將時頻域特征xm∈rh×w×c投影到高維空間x

l

∈rh×w×d(

d>c

)。為了使所述令牌轉換器能夠具有空間歸納全局表示能力,我們將x

l

展開為xu∈r

p

×n×d,從而使模型不丟失時頻特征的patch間順序。其中p=wh,n=hw/p為patch的個數, h和w分別為patch的高度和寬度。另外,我們為了不丟失patch內token之間的空間順序,我們使用token learner結構,該結構使用了空間注意力機制計算 patch中的tokens間的空間權重,并選取t個重要的tokens進行建模。最后通過應用transformer編碼patch間的關系對和patch內的tokens關系對,進行時頻域特征的全局信息關系建模,其表達式方式如下所示。

[0054]

xg(p)=transformer(tokenlearner(xu(p))),1≤p≤p

[0055]

另外,我們為了促進模型捕獲更多域轉移表征,我們在tranformer中的多層感知器(mlp)模塊引入通道注意力機制,如圖5所示。該方式能對transformer 聚合后特征的通道進行更全面的考慮,充分利用通道的分組信息挖掘更多的域轉移表征。對于transformer的輸出特征,我們利用tokenfuser模塊將xg=r

p

×n×

t

映射為xg=r

p

×n×d并將xg折疊為xf∈rh×w×d作為令牌轉換器的輸出。

[0056]

s3通過所述動態圖卷積網絡捕捉所述特征向量的域轉移之間的依賴關系;

[0057]

具體方式:

[0058]

s31利用不變域轉移模塊從所述特征向量針對機器id間的粗標簽依賴關系進行感知建模,得到感知模型;

[0059]

具體的,所述不變域轉移模塊gcn(idt-gcn),構建一個靜態的gcn模塊,該模塊從提取的特征圖中針對機器id間的粗關系進行內容感知建模。

[0060]

其中,在idt-gcn中我們利用了傳統的gcn定義我們模型中靜態gcn, 并計算機器id標簽的粗依賴關系。給定一組特征f∈rc×d作為輸入節點,利用相關矩陣m

sc

×c和狀態更新矩陣計算機器id間的粗關系。idt-gcn計算方式如公式如下所示。

[0061]

s=δ(msfws)

[0062]

其中ms和ws是通過梯度下降算法隨機初始化。ms是對所有聲音的時頻域特征都是共享權重值,所以我們的目標是使ms能夠捕獲到不同機器id間的全局粗分類依賴關系。δ表

示leakyrelu激活函數。

[0063]

s32基于所述感知模型利用可變域轉移模塊捕獲機器id內的域轉移特征之間細微關系。

[0064]

具體的,所述可變域轉移模塊gcn(vdt-gcn)構建了一個動態的gcn模塊,該模塊從idt-gcn模塊輸出的內容感知特征捕捉機器id內面向域轉移特征的細微依賴關系。

[0065]

其中,在vdt-gcn模塊中,我們根據輸入特征s自適應估計相應的md矩陣。因為每類機器id的不同的域轉移特征具有不同的md矩陣,所以md矩陣可以使不同域轉移的條件下模型也能有較好地提取特征能力。vdt-gcn的計算方式如公式如下所示。

[0066]

p'=δ(mdswd),where md=sigmoid(was')

[0067]

其中為更新的權重值,是構造動態關聯矩陣md的卷積層的權重值。s'由s和sg∈r

d1

串聯得到,sg由全局平均池化層(gap)和卷積層計算得到。

[0068]

最后我們通過生成的標簽p',利用交叉熵損失函數更新特征f,使特征f能夠精確捕捉域轉移之間的依賴關系,計算方式如公式如下所示。值得注意的是 dy-gcn只用來在訓練時更新特征,模型在預測時候不使用。

[0069][0070]

s4通過所述域自適應網絡補償所述特征向量。

[0071]

具體的,在異常機器聲音檢測中,訓練集和測試集因存在不同的域偏移情況,導致兩者混合密度分布不同,從而使模型容易把正常聲音信號檢測為異常聲音信號,我們希望最終學習到的特征能夠在測試集上也能很好的應用。傳統的解決方法利用相對熵、布雷格曼散度和對比學習來估計其分布密度。上述方法在一定程度能學習到低水平特征的域不變性,但是它們還是容易受到域變換的影響,且計算復雜,效率不高。因此我們設計了自適應網絡(dan),使模型能夠最小化源特征和目標特征之間的二階統計差異。在該網絡中,我們首先從訓練集中隨機抽取出面向不同域轉移的相同機器id聲音信號,然后對不同域轉移的聲音信號進行數據增強操作,使相同的機器id擁有更多的不同域轉移的特征,最后計算面向不同域的特征向量的二階協方差,并將距離差利用反向梯度傳播算法減少不同域偏移特征間的距離。

[0072]

數據增強:我們利用了多種轉換來生成更多的域轉移的聲音信號。例如采用音高偏移器來增加或減少聲音信號的音高;采用時間轉移器隨機向前或向后移動聲音信號;采用時間拉升器改變聲音信號的速度;采用高斯白噪聲注入聲音信號;采用了增強過濾器在頻帶上應用不同的權重來模擬聲學濾波器。

[0073]

具體方式:

[0074]

s41計算不同域轉移下的所述特征向量之間的二階協方差距離,得到距離差;

[0075]

具體的,所述計算二階協方差距離時,定義源域特征fs={f

si

}和域轉移后的目標特征f

t

={f

ti

},計算方式如公式如下所示:

[0076][0077]

[0078][0079]

其中c表示特征的協方差矩陣,n表示輸入的目標域和源域特征的數量,d表示特征向量的維度。

[0080]

autoencoder損失函數(ae loss)已經被廣泛使用,并在asr的任務上取得了出的表現。在本文中,為了能夠使模型能夠自適應的域偏移后的聲音特征,我們在模型上也加入了ae loss,計算方式如公式如下所示。

[0081][0082]

其中xm為短時傅里葉變換和對數梅爾頻譜提取時頻域特征。為 autoencoder重建后的特征。l

mse

表示均方差損失函數。

[0083]

在本文中為了使域間的聲音特征更緊湊,我們使用了arcface中的additiveangularmargin損失函數(aam loss)來更新特征,并獲得高度可辨別的特征,其中aam loss的計算公式入如下所示。

[0084][0085]

其中aamloss將特征f分布在半徑s的超平面上學習機器id內的域間相似性和機器id間差異性,并執行更高的特征嵌入優化。

θ

為權重w和特征之間的夾角。最后,在我們將交叉熵損失函數利用polyloss進行了代替。polyloss通過加入了泰勒展開式來擬合聲音信號的概率分布,獲得了比交叉熵損失函數更好的效果。polyloss的計算方式如下公式如下所示。

[0086]

l

poly

=l

ce

+∈1(1-pc)

[0087]

其中l

ce

表示交叉熵損失函數。∈1表示懲罰系數項,本次任務中我們設置∈1為 1。pc表示真實標簽。最終,我們模型的損失函數計算方式如公式如下所示。

[0088]

l

total

=l

ae

+l

gcn

+l

arc

+l

se rco

+l

poly

[0089]

s42利用反向梯度傳播算法減少所述距離差。

[0090][0091]

數據集:我們使用了dcase 2020 task2和dcase 2022 task2中的數據集來評估我們方法的有效性。在dcase 2020 task2數據集上有6種機器類型。其中toyconveyor有4種不同的機器id。toycar、fan、pump、slider、valve有3 種不同的機器id。dcase 2022task2數據集上有7種不同的類型機器,7種不同的類型機器包括toycar、toytrain、bearing、fan、gearbox、slider、valve。 dcase 2022每種類型下都有3種不同的機器id。

[0092]

dcase 2022 task2與dcase2020 task2數據集主要表現為以下不同:

[0093]

dcase 2022 task2數據集的訓練集和測試集上擁有不同條件的域偏移,而dcase 2020 task2數據集的訓練集和測試集擁有相同條件的域偏移。

[0094]

dcase 2022 task2數據集的測試集中將不受域偏移影響的源數據和受域偏移影響的目標數據混合在了一起,并不指定目標數據和源域。而dcase2020task2在測試集中區分了目標域和源域。因此在dcase 2022 task2數據集上檢測更加困難。

[0095]

評價指標:評價模型的檢測效果的指標,我們選擇了area under curve (auc)和部分auc下面積(pauc)來評估模型的性能。其中auc被定義為 receiver operation characteristics(roc)曲線下與坐標軸圍成的面積。pauc計算為auc在低假-陽性率(fpr)范圍[0,p],p等于0.1。

[0096]

dcase 2020 task2:為了驗證我們模型的有效性,我們在表1列出了多種先進模型在dcase 2020 task2上檢測所有機器的auc和pauc的結果。從表 1的實驗結果可以看出,我們所提出的方法比目前先進的stgram-mfn模型auc 提高了2.32%,pau提高了8.1%,顯著提高了對機器異常聲音的檢測性能,證明了tranself-dygcn模型對不同域轉移的時頻域特征具有很強的表示能力。

[0097]

dcase 2022 task2:為了充分證明面向不同域偏移條件的聲學特征, tranself-dygcn模型也能進行很好地進行異常聲音的檢測。我們在dcase 2022task2上進行了實驗,并與一些先進的方法進行了對比,實驗結果如表2所示。從表2可以看出我們的方法在七種機器類型的平均值的auc和pauc分別達到了70.41%和62.46%。雖然tranself-dygcn模型在toycar、toytrain和fan機器類別上與一些先進的模型檢測的結果有偏差,例如在toycar類別下,我們的模型相比于基于ae的模型在auc上低了7.89%,pauc低了4.14%,但是我們模型的總體檢測效果優于基于ae的模型。從這些結果可以看出,我們的模型能夠充分捕捉聲音信號的不同域轉移時頻域特征,能夠在異常聲音檢測任務得到很好的應用。

[0098]

表1在dcase2020 task2數據集上不同類型機器的auc(%)和pauc(%) 的比較。最佳的結果加粗顯示。

[0099]

表1

[0100][0101][0102][0103]

表2在dcase2022 task2數據集上不同類型機器的auc(%)和pauc(%) 的比較。最佳的結果加粗顯示。

[0104]

表2

[0105][0106][0107]

為了顯示我們方法的有效性,我們對提出的模型在dcase2022 task2數據集進行了消融實驗驗證tranself-dygcn的每個關鍵組件。(包括損失函數,時序特征網絡、令牌轉換器,動態圖卷積網絡(dygcn),域自適應網絡(ddn)

[0108]

損失函數:我們首先驗證了損失函數對模型預測結果的影響。我們對比了 autoencoder損失函數(ae loss)、additive angular margin損失函數(aamloss)、交叉熵損失函數、focal損失函數和ploy損失函數,對比結果如表3 所示。從表3可以看出,模型中加入aam、ae和poly損失函數auc達到了 70.41%,pauc達到了62.46%,得到的結果在各項指標上均優于其他損失函數的性能。說明加入aam、ae和ploy損失函數能夠在一定的程度上增加模型的自適應域偏移能力。

[0109]

時序特征提取網絡:為了探究時序特征網絡模塊的重要性,我們在表4中比較了不同的時序特征提取網絡的效果。從這些結果可以看出,在模型添加了時序特征網絡,我們模型相比于transformer的auc增加了1.45%,pauc增加了1.5%,證明了時序特征網絡能夠很好的捕捉異常丟失的時序特征信息。最后我們對加入時序特征網絡和transformer提取聲音信號的語譜圖進行了可視化,如圖5所示,我們發現時序特征網絡相比于transformer提取的時頻域特征不僅更有周期性,而且語義信息更豐富。

[0110]

時頻域特征提取網絡:為了探究令牌轉換器網絡模塊對時頻域特征的建模能力,我們在表5中比較了不同時頻域特征提取網絡。從表5的第3行可以看出令牌轉換器相比于mobilenetv2的auc增加了3.4%,pauc增加了1.24%。從表5的第4行可以看出令牌轉換器中加入token learner(tl),令牌轉換器的auc增加了1.03%,pauc增加了0.55%,說明token learner能充分編碼時頻域特征中patch序列對的空間順序和patch內token序列對的空間順序。從表 5的第5行可以看出令牌轉換器中加入通道注意力,令牌轉換器的auc增加了 0.61%,pauc增加了0.6%,說明令牌轉換器中加入通道注意力機制(se)能使令牌轉換器挖掘出更多的域轉移表征。最后,我們對加入通道注意力機制和tokenlearner的令牌轉換器、mobilenetv2、transformer建模后的時頻域特征信息依賴關系進行了可視化,如圖7所

示。從圖7可以看出令牌轉換器相比于mobilenetv2 和transformer可以更加正確捕獲每個周期時頻特征的上升和下降過程,并且很少有漏識別和誤識別,說明令牌轉換器能夠更加好的捕獲全局結構信息和局部細節特征。

[0111]

dygcn和dan:為了研究dygcn和dan的重要性,我們在表6中對 dygcn和dan進行了實驗。從表6第3行可以看出,我們在模型中加入了 dygcn,模型的auc和pauc相比于表6第一行中模型不加入dygcn的模型提高了1.64%和1.98%,說明模型能利用機器id間的內容感知特征捕捉域轉移特征間的細微依賴關系。從表6的第4行可看出,我們在tranself-dygcn模型加入dan,模型的auc和pauc相對于表6的第2行中模型不加入dan提高了2.36%和0.99%,說明了dan能使不同域偏移特征間的距離減少。最后,我們對比了加入dygcn和dan的tranself-dygcn模型和沒有加入dygcn和 dan的tranself-dygcn模型提取聲音信號的特征的差異,并利用t-分布隨機鄰域嵌入(t-sne)聚類可視化,如圖7所示。從圖7(a)中可以看出,沒有加入dygcn 和dan的tranself-dygcn模型提取的特征存在重疊的現象,而圖8(b)中加入dygcn和dan的tranself-dygcn模型提取的特征則更容易區分。這一發現說明模型中加入dygcn和dan能夠使模型充分提取出域轉移特征。

[0112]

表3模型加入不同損失函數的auc(%)和pauc(%)的比較,最佳的結果加粗顯示。

[0113]

表3

[0114][0115]

表4模型加入不同時序特征提取網絡的auc(%)和pauc(%)比較,最佳的結果加粗顯示。(其中

“?”

表示不采用任何時序特征提取網絡)。

[0116]

表4

[0117][0118]

表5模型加入不同時頻域特征提取網絡的auc(%)和pauc(%)比較,最佳的結果加粗顯示。

[0119]

表5

[0120][0121]

表6模型加入dygcn和dan的auc(%)和pauc(%)比較,最佳的結果加粗顯示。(其中

“?”

表示模型中不加入dygcn和dan)

[0122]

表6

[0123][0124][0125]

圖6表示我們對transformer和時序特征網絡的語譜圖進行了可視化。其中 (a)表示使用transformer提取聲音信號的語譜圖。(b)表示使用時序特征網絡提取聲音信號的語譜圖。

[0126]

圖7各模型的時頻域特征可視化。線條1為黃線和線條2為紅線表示當前幀的注意力權重。黃線表示當前幀正確的注意力權重,紅線表示當前幀錯誤的注意力權重。

[0127]

圖8表示使用了t-sne對tranself-dygcn提取的特征圖進行了可視化。其中(a)表示沒有加入dygcn和dan的tranself-dygcn提取的特征。(b) 表示加入dygcn和dan的tranself-dygcn提取的特征。不同顏代表不同的機器id。表示正常機器的特征。

×

表示異常機器的特征。

[0128]

以上所揭露的僅為本發明一種專利名稱較佳實施例而已,當然不能以此來限定本發明之權利范圍,本領域普通技術人員可以理解實現上述實施例的全部或部分流程,并依本發明權利要求所作的等同變化,仍屬于發明所涵蓋的范圍。