用于多目標決策的分層強化學(xué)習(xí)框架訓(xùn)練方法

1.本發(fā)明涉及復(fù)雜問題的決策技術(shù)領(lǐng)域,尤其涉及一種用于多目標決策的分層強化學(xué)習(xí)框架訓(xùn)練方法。

背景技術(shù):

2.現(xiàn)實的決策問題多屬于多目標優(yōu)化的復(fù)雜決策問題,不僅僅要考慮到當(dāng)前狀態(tài)下的最優(yōu)策略,而且要考慮在不同狀態(tài)下所追求目標之間的動態(tài)權(quán)重分配問題。傳統(tǒng)的方法雖然能解決一般的決策問題,但其優(yōu)化目標通常只考慮一種要素或多目標要素之間采用固定權(quán)重,導(dǎo)致由于獎勵函數(shù)的限制在決策過程中不能以最快的速度接近目標。

3.以無人機對戰(zhàn)為例,對戰(zhàn)的目的是從目標飛機的后方接近目標飛機,即在決策的過程中要綜合考慮角度和距離等因素。現(xiàn)有算法在設(shè)計獎勵函數(shù)模型時對各因素考慮采用固定權(quán)重,沒有考慮在不同態(tài)勢下基于短期目的的不同,應(yīng)該對獎勵函數(shù)模型的各因素權(quán)重進行調(diào)整。另外,本技術(shù)的方法還可應(yīng)用于路徑規(guī)劃、游戲等領(lǐng)域。

4.因此,有必要開發(fā)一種用于多目標決策的分層強化學(xué)習(xí)框架訓(xùn)練方法,利用不同的目標之間動態(tài)權(quán)重分配設(shè)計不同的獎勵函數(shù)模型并訓(xùn)練不同的決策模型,通過自主的進行決策模型切換,實現(xiàn)不同決策模型之間協(xié)同決策,最終獲取最優(yōu)的連續(xù)策略。

技術(shù)實現(xiàn)要素:

5.本發(fā)明旨在解決現(xiàn)有技術(shù)或相關(guān)技術(shù)中存在的技術(shù)問題之一。

6.有鑒于此,本發(fā)明提出了一種用于多目標決策的分層強化學(xué)習(xí)框架訓(xùn)練方法,所述分層強化學(xué)習(xí)框架訓(xùn)練方法包括如下步驟:

7.基于所研究的實際問題,建立智能體與環(huán)境交互的仿真環(huán)境模型,使所述智能體生成策略后能夠?qū)幼髟谒龇抡姝h(huán)境模型中執(zhí)行;

8.將所述實際問題劃分為多個子目標,針對多個所述子目標,通過分配不同的目標權(quán)重建立多個獎勵函數(shù)模型;

9.基于多個所述獎勵函數(shù)模型,建立對應(yīng)的多個ddpg模型;

10.將多個所述ddpg模型的對應(yīng)策略視為離散動作,建立對應(yīng)的ddqn模型;

11.將所述ddpg模型作為底層決策模型,所述ddqn模型作為選擇所述底層決策模型的頂層決策模型,構(gòu)建基于兩層決策過程的分層強化學(xué)習(xí)框架;

12.基于所述分層強化學(xué)習(xí)框架和所述仿真環(huán)境模型進行交互并存儲經(jīng)驗;

13.存儲所述經(jīng)驗后,依照設(shè)定的模型訓(xùn)練頻率訓(xùn)練所述ddpg模型和所述ddqn模型,判斷訓(xùn)練后的所述ddpg模型和所述ddqn模型是否滿足應(yīng)用需求,若滿足需求則退出訓(xùn)練過程,否則重新存儲經(jīng)驗和重新訓(xùn)練所述ddpg模型和所述ddqn模型;

14.在應(yīng)用階段,將所述智能體所處狀態(tài)輸入訓(xùn)練好的所述ddpg模型和所述ddqn模型,由所述頂層決策模型輸出各底層決策模型被選擇后所獲得的獎勵,激活最大獎勵對應(yīng)的所述底層決策模型,生成連續(xù)激動動作序列。

15.進一步地,所述獎勵函數(shù)模型作為所述智能體在所述仿真環(huán)境模型中執(zhí)行所述動作a

t

后,所述仿真環(huán)境模型對所述智能體的反饋r

t

;

16.所述ddpg模型的輸入為所述智能體當(dāng)前所處的狀態(tài)s

t

,輸出為在當(dāng)前狀態(tài)下所產(chǎn)生的動作a

t

;

17.所述ddqn模型的輸入為所述智能體當(dāng)前所處的狀態(tài)s

t

,輸出為各所述ddpg模型被選擇的所獲得的獎勵p

t

。

18.進一步地,通過分配不同的目標權(quán)重建立多個所述獎勵函數(shù)模型:

[0019][0020]

其中,不同的所述權(quán)重wi滿足其中,n為獎勵函數(shù)模型影響因素的個數(shù);ri為第i個獎勵函數(shù)模型對應(yīng)的獎勵。

[0021]

進一步地,所述ddpg模型包括actor網(wǎng)絡(luò)θ、actor目標網(wǎng)絡(luò)θ'、critic網(wǎng)絡(luò)ω和critic目標網(wǎng)絡(luò)ω',所述actor網(wǎng)絡(luò)用于生成策略,所述actor目標網(wǎng)絡(luò)用于指導(dǎo)所述critic網(wǎng)絡(luò)的更新,所述critic網(wǎng)絡(luò)用于評價所述策略,所述critic目標網(wǎng)絡(luò)用于計算q值,其中,q值為動作價值函數(shù),即在當(dāng)前狀態(tài)下執(zhí)行該動作對應(yīng)的獎勵值。

[0022]

進一步地,所述actor網(wǎng)絡(luò)θ的目標是輸出最優(yōu)策略使所述critic網(wǎng)絡(luò)ω的輸出最大,因此所述actor網(wǎng)絡(luò)θ的目標輸出為:

[0023][0024]

其中,δa為動作a的增量,q(s

t

,ω)為當(dāng)前狀態(tài)下critic網(wǎng)絡(luò)的評價;表示critic網(wǎng)絡(luò)對a的偏導(dǎo),ra為actor網(wǎng)絡(luò)的學(xué)習(xí)率;a為當(dāng)前狀態(tài)下所產(chǎn)生的策略。

[0025]

所述critic網(wǎng)絡(luò)ω的目標是擬合當(dāng)前狀態(tài)下執(zhí)行該策略所帶來的累計獎勵,即動作價值函數(shù),所述critic網(wǎng)絡(luò)ω的目標輸出為:

[0026]

q(s

t

,a

t

)=r

t

+γr

t+1

+γ2r

t+2

+

…

=r

t

+γ(r

t+1

+γr

t+2

+

…

)=r

t

+γq(s

t+1

,a

t+1

)

……

(3)

[0027]

其中,r

t

為當(dāng)前狀態(tài)s

t

執(zhí)行動作a

t

所獲得的獎勵;γ表示獎勵的衰減因子;q(s

t+1

,a

t+1

)表示下一狀態(tài)獲得的獎勵;

[0028]

計算所述actor網(wǎng)絡(luò)θ的目標輸出和所述critic網(wǎng)絡(luò)ω的目標輸后,使用mse作為損失函數(shù)分別訓(xùn)練所述actor網(wǎng)絡(luò)和所述critic網(wǎng)絡(luò)。

[0029]

進一步地,所述actor目標網(wǎng)絡(luò)θ'由所述actor網(wǎng)絡(luò)θ軟更新得到:

[0030]

θ'=θ'τ+θ(1-τ)

……

(4)

[0031]

所述critic目標網(wǎng)絡(luò)ω'由所述critic網(wǎng)絡(luò)ω軟更新得到:

[0032]

ω'=ω'τ+ω(1-τ)

……

(5)

[0033]

其中,τ為軟更新率。

[0034]

進一步地,所述ddqn模型包括q網(wǎng)絡(luò)η和目標q網(wǎng)絡(luò)η',所述q網(wǎng)絡(luò)η擬合選擇所述ddpg模型獲得的累計獎勵目標,所述q網(wǎng)絡(luò)η計算下一時刻的q值,所述q網(wǎng)絡(luò)η的目標輸出

為:

[0035][0036]

其中,j=1

…

m,m為ddpg模型個數(shù);(s

t+1

)j為選擇第j個ddpg模型對應(yīng)的下一狀態(tài);rj為選擇第j個ddpg模型所得到的獎勵,maxq((s

t+1

)j,η')為目標q網(wǎng)絡(luò)η'對狀態(tài)(s

t+1

)j所對應(yīng)q值中的最大值;

[0037]

計算出所述q網(wǎng)絡(luò)η的目標輸出后,使用mse作為損失函數(shù)訓(xùn)練q網(wǎng)絡(luò)模型。

[0038]

進一步地,所述目標q網(wǎng)絡(luò)η'由所述q網(wǎng)絡(luò)η軟更新得到:

[0039]

η'=η'τ+η(1-τ)

……

(7)

[0040]

其中,τ為軟更新率。

[0041]

進一步地,所述軟更新頻率低于對應(yīng)的所述ddpg模型和所述ddqn模型的訓(xùn)練頻率,所述分層強化學(xué)習(xí)框架的訓(xùn)練過程中,所述頂層決策模型的訓(xùn)練頻率低于所述底層決策模型的訓(xùn)練頻率。

[0042]

本發(fā)明提供的技術(shù)方案可以包括以下有益效果:

[0043]

通過設(shè)置獎勵函數(shù)模型中不同目標之間的權(quán)重,基于強化學(xué)習(xí)機制,訓(xùn)練多個基于ddpg模型的底層決策模型,旨在訓(xùn)練出能夠更快接近最終目標的分布式?jīng)Q策模型;再利用ddqn模型自主的進行模型選擇,構(gòu)建在當(dāng)前態(tài)勢下最有利于全局的頂層決策模型,從而通過各分層強化學(xué)習(xí)框架之間的協(xié)作,生成最優(yōu)連續(xù)策略組合。

[0044]

應(yīng)當(dāng)理解的是,以上的一般描述和后文的細節(jié)描述僅是示例性和解釋性的,并不能限制本發(fā)明。

附圖說明

[0045]

此處的附圖被并入說明書中并構(gòu)成本說明書的一部分,示出了符合本發(fā)明的實施例,并與說明書一起用于解釋本發(fā)明的原理。

[0046]

為了更清楚地說明本發(fā)明實施例或現(xiàn)有技術(shù)中的技術(shù)方案,下面將對實施例或現(xiàn)有技術(shù)描述中所需要使用的附圖作簡單地介紹,顯而易見地,對于本領(lǐng)域普通技術(shù)人員而言,在不付出創(chuàng)造性勞動的前提下,還可以根據(jù)這些附圖獲得其他的附圖。

[0047]

圖1示出了根據(jù)本發(fā)明的用于多目標決策的分層強化學(xué)習(xí)框架訓(xùn)練方法的步驟流程圖;

[0048]

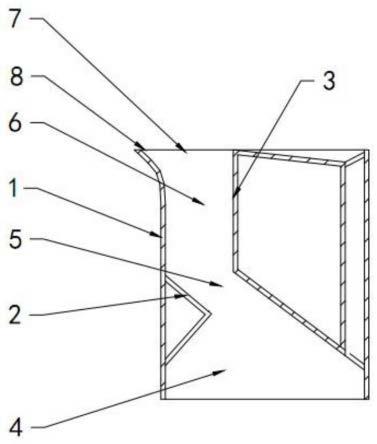

圖2示出了根據(jù)本發(fā)明實施例的無人機在空間中的狀態(tài)信息;

[0049]

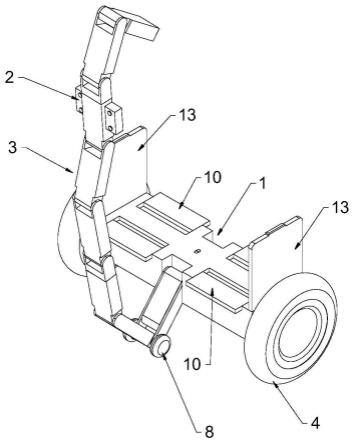

圖3示出了根據(jù)本發(fā)明實施例的仿真環(huán)境中無人機和目標飛機在xoy平面的初始態(tài)勢關(guān)系俯視圖;

[0050]

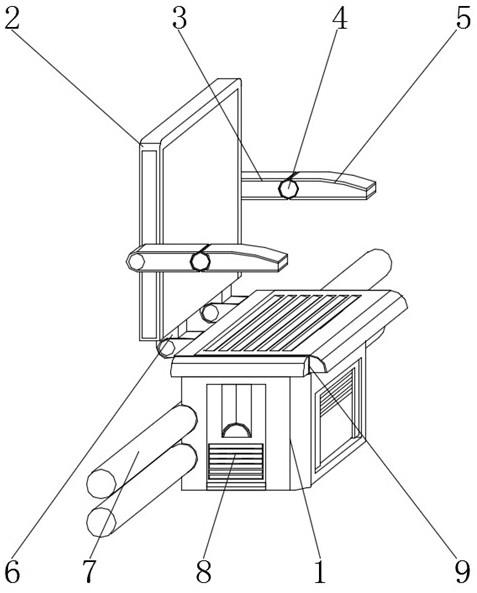

圖4示出了根據(jù)本發(fā)明實施例的環(huán)境中無人機和目標飛機的相對位置關(guān)系;

[0051]

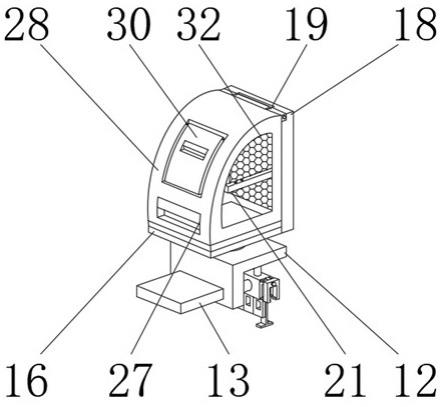

圖5示出了根據(jù)本發(fā)明實施例的無人機和目標飛機的角度與距離關(guān)系的俯視圖;

[0052]

圖6示出了根據(jù)本發(fā)明實施例的ddpg模型結(jié)構(gòu)和訓(xùn)練過程;

[0053]

圖7示出了根據(jù)本發(fā)明實施例的ddqn模型結(jié)構(gòu)和訓(xùn)練過程;

[0054]

圖8示出了根據(jù)本發(fā)明實施例的分層強化學(xué)習(xí)框架和ddpg模型和ddqn模型訓(xùn)練過程;

[0055]

圖9示出了根據(jù)本發(fā)明實施例的分層強化學(xué)習(xí)框架的決策過程;

[0056]

圖10示出了根據(jù)本發(fā)明實施例的分層強化學(xué)習(xí)框架訓(xùn)練過程中的勝率變化曲線;

[0057]

圖11示出了根據(jù)本發(fā)明實施例的分層強化學(xué)習(xí)框架訓(xùn)練過程中的平均獎勵值的變化曲線;

[0058]

圖12a示出了根據(jù)本發(fā)明實施例的優(yōu)勢態(tài)勢下的無人機追擊目標飛機的軌跡;

[0059]

圖12b示出了根據(jù)本發(fā)明實施例的優(yōu)勢態(tài)勢下無人機追擊目標飛機過程中底層模型切換的過程;

[0060]

圖12c示出了根據(jù)本發(fā)明實施例的優(yōu)勢態(tài)勢下無人機追擊目標飛機過程中獎勵值的變化過程;

[0061]

圖13a示出了根據(jù)本發(fā)明實施例的均勢態(tài)勢下的無人機追擊目標飛機的軌跡;

[0062]

圖13b示出了根據(jù)本發(fā)明實施例的均勢態(tài)勢下無人機追擊目標飛機過程中底層模型切換的過程;

[0063]

圖13c示出了根據(jù)本發(fā)明實施例的均勢態(tài)勢下無人機追擊目標飛機過程中獎勵值的變化過程;

[0064]

圖14a示出了根據(jù)本發(fā)明實施例的劣勢態(tài)勢下的無人機追擊目標飛機的軌跡;

[0065]

圖14b示出了根據(jù)本發(fā)明實施例的劣勢態(tài)勢下無人機追擊目標飛機過程中底層模型切換的過程;

[0066]

圖14c示出了根據(jù)本發(fā)明實施例的劣勢態(tài)勢下無人機追擊目標飛機過程中獎勵值的變化過程。

具體實施方式

[0067]

這里將詳細地對示例性實施例進行說明,其示例表示在附圖中。下面的描述涉及附圖時,除非另有表示,不同附圖中的相同數(shù)字表示相同或相似的要素。以下示例性實施例中所描述的實施方式并不代表與本發(fā)明相一致的所有實施方式。相反,它們僅是與如所附權(quán)利要求書中所詳述的、本發(fā)明的一些方面相一致的裝置和方法的例子。

[0068]

圖1示出了根據(jù)本發(fā)明的用于多目標決策的分層強化學(xué)習(xí)框架訓(xùn)練方法的步驟流程圖。

[0069]

如圖1所示,本技術(shù)提供了一種用于多目標決策的分層強化學(xué)習(xí)框架訓(xùn)練方法,該分層強化學(xué)習(xí)框架訓(xùn)練方法包括如下步驟:

[0070]

步驟1,基于所研究的實際問題,建立智能體與環(huán)境交互的仿真環(huán)境模型,使智能體生成策略后能夠?qū)幼髟诜抡姝h(huán)境模型中執(zhí)行;

[0071]

步驟2,將實際問題劃分為多個子目標,針對多個子目標,通過分配不同的目標權(quán)重建立多個獎勵函數(shù)模型;

[0072]

步驟3,基于多個獎勵函數(shù)模型,建立對應(yīng)的多個ddpg模型;

[0073]

步驟4,將多個ddpg模型的對應(yīng)策略視為離散動作,建立對應(yīng)的ddqn模型;

[0074]

步驟5,將ddpg模型作為底層決策模型,ddqn模型作為選擇底層決策模型的頂層決策模型,構(gòu)建基于兩層決策過程的分層強化學(xué)習(xí)框架;

[0075]

步驟6,基于分層強化學(xué)習(xí)框架和仿真環(huán)境模型進行交互并存儲經(jīng)驗;

[0076]

步驟7,存儲經(jīng)驗后,依照設(shè)定的模型訓(xùn)練頻率訓(xùn)練ddpg模型和ddqn模型,判斷訓(xùn)練后的ddpg模型和ddqn模型是否滿足應(yīng)用需求,若滿足需求則退出訓(xùn)練過程,否則重新存

儲經(jīng)驗和重新訓(xùn)練ddpg模型和ddqn模型;

[0077]

步驟8,在應(yīng)用階段,將智能體所處狀態(tài)輸入訓(xùn)練好的ddpg模型和ddqn模型,由頂層決策模型輸出各底層決策模型被選擇后所獲得的獎勵,激活最大獎勵對應(yīng)的底層決策模型,生成連續(xù)機動動作序列。

[0078]

通過設(shè)置獎勵函數(shù)模型中不同目標之間的權(quán)重,基于強化學(xué)習(xí)機制,訓(xùn)練多個基于ddpg模型的底層決策模型,旨在訓(xùn)練出能夠更快接近最終目標的分布式?jīng)Q策模型;再利用ddqn模型自主的進行模型選擇,構(gòu)建在當(dāng)前態(tài)勢下最有利于全局的頂層決策模型,從而通過各分層強化學(xué)習(xí)框架之間的協(xié)作,生成最優(yōu)連續(xù)策略組合。

[0079]

其中,ddpg為deep deterministic policy gradient的縮寫,ddqn為double deep q-network的縮寫,

[0080]

進一步地,獎勵函數(shù)模型作為智能體在仿真環(huán)境模型中執(zhí)行動作a

t

后,仿真環(huán)境模型對智能體的反饋r

t

;

[0081]

ddpg模型的輸入為智能體當(dāng)前所處的狀態(tài)s

t

,輸出為在當(dāng)前狀態(tài)下所產(chǎn)生的動作a

t

;

[0082]

ddqn模型的輸入為智能體當(dāng)前所處的狀態(tài)s

t

,輸出為各ddpg模型被選擇所獲得的獎勵p

t

。

[0083]

需要說明的是,動作分為離散動作和連續(xù)動作,ddqn模型相比于ddpg模型擁有更強的決策能力,然而ddqn模型只能針對離散動作進行決策,所述分層強化學(xué)習(xí)框架將ddqn模型的決策能力和ddpg模型處理連續(xù)動作的能力結(jié)合起來,從而通過各分層強化學(xué)習(xí)框架之間的協(xié)作,生成最優(yōu)連續(xù)策略組合。

[0084]

進一步地,通過分配不同的目標權(quán)重建立多個獎勵函數(shù)模型:

[0085][0086]

其中,不同的權(quán)重wi滿足:其中,n為獎勵函數(shù)模型影響因素的個數(shù);ri為第i個獎勵函數(shù)模型對應(yīng)的獎勵。

[0087]

通過不同的權(quán)重分配可以設(shè)計不同的獎勵函數(shù),不同獎勵函數(shù)對不同的影響因素的重視程度不同。

[0088]

進一步地,ddpg模型包括actor網(wǎng)絡(luò)θ、actor目標網(wǎng)絡(luò)θ'、critic網(wǎng)絡(luò)ω和critic目標網(wǎng)絡(luò)ω',actor網(wǎng)絡(luò)用于生成策略,actor目標網(wǎng)絡(luò)用于指導(dǎo)critic網(wǎng)絡(luò)的更新,critic網(wǎng)絡(luò)用于評價策略,critic目標網(wǎng)絡(luò)用于計算q值,其中,q值為動作價值函數(shù),即在當(dāng)前狀態(tài)下執(zhí)行該動作對應(yīng)的獎勵值。

[0089]

進一步地,actor網(wǎng)絡(luò)θ的目標是輸出最優(yōu)策略使critic網(wǎng)絡(luò)ω的輸出最大,因此actor網(wǎng)絡(luò)θ的目標輸出為:

[0090][0091]

其中,δa為動作a的增量,q(s

t

,a,ω)為當(dāng)前狀態(tài)下critic網(wǎng)絡(luò)的評價;表示critic網(wǎng)絡(luò)對a的偏導(dǎo),ra為actor網(wǎng)絡(luò)的學(xué)習(xí)率;a為當(dāng)前狀態(tài)下所產(chǎn)生的

策略;

[0092]

critic網(wǎng)絡(luò)ω的目標是擬合當(dāng)前狀態(tài)下執(zhí)行該策略所帶來的累計獎勵,即動作價值函數(shù),critic網(wǎng)絡(luò)ω的目標輸出為:

[0093]

q(s

t

,a

t

)=r

t

+γr

t+1

+γ2r

t+2

+

…

=r

t

+γ(r

t+1

+γr

t+2

+

…

)=r

t

+γq(s

t+1

,a

t+1

)

……

(3)

[0094]

其中,r

t

為當(dāng)前狀態(tài)s

t

執(zhí)行動作a

t

所獲得的獎勵;γ表示獎勵的衰減因子;q(s

t+1

,a

t+1

)表示下一狀態(tài)獲得的獎勵;

[0095]

計算actor網(wǎng)絡(luò)θ的目標輸出和critic網(wǎng)絡(luò)ω的目標輸后,使用mse(mean square error)作為損失函數(shù)分別訓(xùn)練actor網(wǎng)絡(luò)和critic網(wǎng)絡(luò)。

[0096]

ddpg模型包含aator網(wǎng)絡(luò)和critic網(wǎng)絡(luò),在描述ddpg部分就可以說訓(xùn)練actor網(wǎng)絡(luò)和critic網(wǎng)絡(luò),ddqn模型包含q網(wǎng)絡(luò),在描述ddqn模型部分時訓(xùn)練q網(wǎng)絡(luò)。

[0097]

通過將actor網(wǎng)絡(luò)的訓(xùn)練過程分解為兩步(計算目標值和訓(xùn)練模型),降低網(wǎng)絡(luò)訓(xùn)練難度,簡化編程復(fù)雜度。

[0098]

進一步地,actor目標網(wǎng)絡(luò)θ'由actor網(wǎng)絡(luò)θ軟更新得到:

[0099]

θ'=θ'τ+θ(1-τ)

……

(4)

[0100]

critic目標網(wǎng)絡(luò)ω'由critic網(wǎng)絡(luò)ω軟更新得到:

[0101]

ω'=ω'τ+ω(1-τ)

……

(5)

[0102]

其中,τ為軟更新率。

[0103]

進一步地,ddqn模型包括q網(wǎng)絡(luò)η和目標q網(wǎng)絡(luò)η',q網(wǎng)絡(luò)η擬合選擇ddpg模型獲得的累計獎勵目標,q網(wǎng)絡(luò)η計算下一時刻的q值,q網(wǎng)絡(luò)η的目標輸出為:

[0104][0105]

其中,j=1

…

m,m為ddpg模型個數(shù);(s

t+1

)j為選擇第j個ddpg模型對應(yīng)的下一狀態(tài);rj為選擇第j個ddpg模型所得到的獎勵,maxq((s

t+1

)j,η')表示目標q網(wǎng)絡(luò)η'對狀態(tài)(s

t+1

)j所對應(yīng)q值中的最大值。

[0106]

計算出所述q網(wǎng)絡(luò)η的目標輸出后,使用mse作為損失函數(shù)訓(xùn)練q網(wǎng)絡(luò)模型。

[0107]

相比于傳統(tǒng)ddqn模型中計算q值時只更新被選擇的動作對應(yīng)的q值,即j等于被選擇的動作,所述ddqn算法計算q值中j=1

…

m加快了ddqn模型收斂速度。

[0108]

進一步地,計算q網(wǎng)絡(luò)的目標輸出后,使用mse作為損失函數(shù)訓(xùn)練ddqn模型;

[0109]

目標q網(wǎng)絡(luò)η'由q網(wǎng)絡(luò)η軟更新得到:

[0110]

η'=η'τ+η(1-τ)

……

(7)

[0111]

其中,τ為軟更新率。

[0112]

需要說明的是,軟更新能夠使目標網(wǎng)絡(luò)的更新更加平穩(wěn),提高分層強化學(xué)習(xí)框架的穩(wěn)定性。

[0113]

進一步地,軟更新頻率低于對應(yīng)的ddpg模型和ddqn模型的訓(xùn)練頻率,分層強化學(xué)習(xí)框架的訓(xùn)練過程中,頂層決策模型的訓(xùn)練頻率低于底層決策模型的訓(xùn)練頻率。

[0114]

相比于一般算法先將底層模型訓(xùn)練出來再訓(xùn)練頂層模型,該訓(xùn)練過程同時訓(xùn)練頂層模型和底層模型,能更合理使兩層決策模型結(jié)合起來。

[0115]

本技術(shù)的方法能夠應(yīng)用于無人機對戰(zhàn)、路徑規(guī)劃和游戲等領(lǐng)域。

[0116]

實施例

[0117]

本實施例以無人機追擊直線飛行的目標為例,對用于多目標決策的分層強化學(xué)習(xí)框架及訓(xùn)練過程方法進行說明。

[0118]

圖2示出了根據(jù)本發(fā)明實施例的無人機在空間中的狀態(tài)信息。

[0119]

步驟1’,無人機對戰(zhàn)的仿真環(huán)境模型主要由無人機運動軌跡生成,針對無人機運動軌跡特征,建立無人機的運動軌跡方程:

[0120][0121]

其中,(x,y,z)為無人機的空間位置坐標;v表示速度;ψ∈[-π,π]表示偏航角;θ∈[-π,π]表示俯仰角;η

x

表示無人機速度方向過載;ηz表示無人機法向過載,φ∈[-π,π]表示滾轉(zhuǎn)角;δt為時間間隔;g為重力加速度。

[0122]

需要說明的是,這里的無人機運動方程只是為了模擬無人機飛行而構(gòu)建的方程,實際的無人機飛行需要考慮的因素更多。

[0123]

圖3示出了根據(jù)本發(fā)明實施例的仿真環(huán)境中無人機和目標飛機在xoy平面的初始態(tài)勢關(guān)系俯視圖。

[0124]

為了體現(xiàn)空戰(zhàn)戰(zhàn)場的復(fù)雜性,同時避免對抗在戰(zhàn)斗的初始階段就結(jié)束,將無人機(我機)初始空間位置及態(tài)勢信息固定,將目標飛機(敵機)初始空間位置及態(tài)勢信息在一定范圍內(nèi)隨機化生成。其中,我機的初始坐標為[0,0,8000];敵機的初始坐標與我機的橫縱坐標距離d

x

∈[6000,7000],dy∈[6000,7000],高度h∈[6000,10000],敵機的偏航角設(shè)置為如圖3所示,圖3中vr表示我方飛機的速度,vb表示敵機的速度,偏航角為速度方向與x軸的夾角。

[0125]

圖4示出了根據(jù)本發(fā)明實施例的環(huán)境中無人機和目標飛機的相對位置關(guān)系。

[0126]

其中,空心表示無人機,實心表示目標飛機。

[0127]

如圖4所示,ata表示無人機的軸線與雷達準線的角度差,taa表示目標飛機速度矢量(航跡)與目標和攻擊機之間瞄準線的夾角。

[0128]

無人機追擊目標飛機的目的是飛至目標飛機后方并且可以形成有利態(tài)勢,擊毀目標飛機,因此,定義無人機成功的條件是ata小于π/6且雙方距離小于5000米;反之,若taa小于π/6且雙方距離小于5000米認為目標飛機可以擊毀無人機,視為失敗;若雙方同時達到上述條件,比較ata和taa的大小,若ata>taa視為無人機成功,反之無人機失敗;若雙方距離大于15000米,認為超出模型的輸入范圍,視為目標飛機逃逸。

[0129]

步驟2’,根據(jù)無人機和目標飛機的相對位置關(guān)系以及不同的目標創(chuàng)建多個獎勵函

數(shù)模型。

[0130]

步驟201,角度獎勵函數(shù)模型。

[0131]

由幾何關(guān)系可推得ata和taa的計算公式分別為:

[0132][0133][0134]

其中,vr表示無人機的速度;vb表示目標飛機的速度;r表示無人機與目標飛機的距離。

[0135]

如圖4所示,ata與角度優(yōu)勢成正比,taa與角度優(yōu)勢成反比,利用上述關(guān)系構(gòu)造角度獎勵函數(shù)模型ra為:

[0136][0137][0138][0139]

步驟202,距離獎勵函數(shù)模型。

[0140]

圖5示出了根據(jù)本發(fā)明實施例的無人機和目標飛機的角度與距離關(guān)系的俯視圖。

[0141]

如圖5所示,d表示無人機和目標飛機之間的距離,dr表示無人機與目標飛機速度垂面的距離;db表示目標飛機與無人機速度垂面的距離,計算公式如下:

[0142][0143][0144]

利用上述兩個距離關(guān)系構(gòu)造距離獎勵函數(shù)模型rd如下:

[0145]

[0146][0147][0148]

步驟203,高度獎勵函數(shù)模型。

[0149]

構(gòu)建高度獎勵模型rh如下:

[0150][0151]

其中,h=z

r-zb,zr為無人機的高度;zb為目標飛機的高度。

[0152]

步驟204,速度獎勵函數(shù)模型。

[0153]

構(gòu)建速度獎勵模型rv如下:

[0154][0155]

其中,v=v

r-vb,vr表示無人機的速度;vb表示目標飛機的速度。

[0156]

以上獎勵函數(shù)可以分為兩類:角度獎勵函數(shù)模型和距離獎勵函數(shù)模型屬于對目標飛機的追擊,速度獎勵函數(shù)模型和高度獎勵函數(shù)模型是為了保證無人機的正常飛行。

[0157]

若沒有達到結(jié)束條件,綜合考慮以上因素,總獎勵函數(shù)模型設(shè)置為:

[0158]

r=ω1ra+ω2rd+min(rv,rh)

……

(14’)

[0159]

為了應(yīng)對不同的狀態(tài),對以上權(quán)值(ω1、ω2)進行如下分配,構(gòu)建5組獎勵函數(shù)模型,如表1所示。

[0160]

表1各獎勵函數(shù)模型的權(quán)重分配

[0161]

ω101.510.52ω220.511.50

[0162]

若達到結(jié)束條件,如果無人機勝利,則r=5,反之,如果目標飛機勝利,則r=-5。

[0163]

圖6示出了根據(jù)本發(fā)明實施例的ddpg模型結(jié)構(gòu)和訓(xùn)練過程。

[0164]

步驟3’,由于有5組權(quán)值分配策略,因此需要建立5個ddpg模型。

[0165]

其中,ddpg模型包括actor網(wǎng)絡(luò)θ、actor目標網(wǎng)絡(luò)θ'、critic網(wǎng)絡(luò)ω和critic目標

網(wǎng)絡(luò)ω'。

[0166]

ddpg模型的訓(xùn)練過程為:actor網(wǎng)絡(luò)輸入當(dāng)前無人機所處狀態(tài),輸出動作控制量。actor網(wǎng)絡(luò)包括2層網(wǎng)絡(luò)結(jié)構(gòu),隱含層的結(jié)點個數(shù)為32,激活函數(shù)為tanh;輸出層結(jié)點個數(shù)為3,激活函數(shù)為linear。actor網(wǎng)絡(luò)的目標是輸出最優(yōu)策略使critic網(wǎng)絡(luò)的輸出最大,因此actor網(wǎng)絡(luò)的目標輸出為:

[0167][0168]

其中,q(s

t

,a,ω)表示當(dāng)前狀態(tài)下critic網(wǎng)絡(luò)的評價,ra表示actor網(wǎng)絡(luò)的學(xué)習(xí)率,a表示當(dāng)前狀態(tài)下所產(chǎn)生的策略。

[0169]

critic網(wǎng)絡(luò)輸入當(dāng)前無人機所處狀態(tài)和動作控制量,輸出動作價值。critic網(wǎng)絡(luò)包括3層網(wǎng)絡(luò)結(jié)構(gòu),第一層隱含層的結(jié)點個數(shù)為256,激活函數(shù)為tanh;第二層隱含層的結(jié)點個數(shù)為512,激活函數(shù)為tanh;輸出層結(jié)點個數(shù)為1,激活函數(shù)為linear。利用critic目標網(wǎng)絡(luò)計算critic網(wǎng)絡(luò)的目標輸出為:

[0170][0171]

其中,r

t

表示當(dāng)前狀態(tài)s

t

執(zhí)行動作a

t

所獲得的獎勵,γ表示獎勵的衰減因子,q(s

t+1

,a

t+1

,ω')表示critic目標網(wǎng)絡(luò)對下一狀態(tài)的評估。

[0172]

需要說明的是,公式16’是公式3的實際應(yīng)用。

[0173]

計算出actor網(wǎng)絡(luò)的目標輸出和critic網(wǎng)絡(luò)的目標輸出后使用mse作為損失函數(shù)訓(xùn)練actor網(wǎng)絡(luò)模型和critic網(wǎng)絡(luò)模型。

[0174]

actor目標網(wǎng)絡(luò)θ'由actor網(wǎng)絡(luò)θ軟更新得到:

[0175]

θ'=θ'τ+θ(1-τ)

……

(17’)

[0176]

critic目標網(wǎng)絡(luò)ω'由critic網(wǎng)絡(luò)ω軟更新得到:

[0177]

ω'=ω'τ+ω(1-τ)

……

(18’)

[0178]

其中,τ為軟更新率。

[0179]

圖7示出了根據(jù)本發(fā)明實施例的ddqn模型結(jié)構(gòu)和訓(xùn)練過程。

[0180]

步驟4’,將多個ddpg模型的對應(yīng)策略視為離散動作,建立對應(yīng)的ddqn模型。

[0181]

其中,ddqn模型包括q網(wǎng)絡(luò)η和目標q網(wǎng)絡(luò)η'。q網(wǎng)絡(luò)輸入當(dāng)前無人機所處狀態(tài),輸出選擇各ddpg模型所帶來的獎勵。q網(wǎng)絡(luò)包括2層網(wǎng)絡(luò)結(jié)構(gòu),隱含層的結(jié)點個數(shù)為128,激活函數(shù)為tanh;輸出層結(jié)點個數(shù)為5,激活函數(shù)為linear,q網(wǎng)絡(luò)的目標輸出為:

[0182][0183]

其中,j=1,

…

,5;(s

t+1

)j為選擇第j個ddpg模型對應(yīng)的下一狀態(tài);rj為選擇第j個ddpg模型所得到的獎勵,maxq((s

t+1

)j,η')表示目標q網(wǎng)絡(luò)對狀態(tài)(s

t+1

)j所對應(yīng)q值中的最大值。

[0184]

需要說明的是,公式19’和公式16’均是對公式3的實際應(yīng)用,公式16’是訓(xùn)練ddpg模型中的critic網(wǎng)絡(luò),公式19’是訓(xùn)練ddqn模型中的q網(wǎng)絡(luò)。

[0185]

計算q網(wǎng)絡(luò)的目標輸出后,使用mse作為損失函數(shù)訓(xùn)練q網(wǎng)絡(luò)模型。

[0186]

目標q網(wǎng)絡(luò)η'由q網(wǎng)絡(luò)η軟更新得到:

[0187]

η'=η'τ+η(1-τ)

……

(20’)

[0188]

其中,τ為軟更新率。

[0189]

步驟5’,ddqn模型與5個ddpg模型組合構(gòu)成分層強化學(xué)習(xí)框架。

[0190]

步驟6’,該分層強化學(xué)習(xí)模型與仿真環(huán)境模型交互并記錄相關(guān)數(shù)據(jù)用于訓(xùn)練分層強化學(xué)習(xí)框架。

[0191]

為了訓(xùn)練ddpg模型,ddpg模型的經(jīng)驗池需要保存當(dāng)前狀態(tài)(s

t

),動作(a

t

),獎勵(r

t

),下一狀態(tài)(s

t+1

)以及是否結(jié)束(is_done)。

[0192]

為了訓(xùn)練ddqn模型,ddqn模型的經(jīng)驗池只需要保存當(dāng)前狀態(tài)(s

t

)。

[0193]

圖8示出了根據(jù)本發(fā)明實施例的分層強化學(xué)習(xí)框架和ddpg模型和ddqn模型訓(xùn)練過程。

[0194]

步驟7’,分層強化學(xué)習(xí)框架訓(xùn)練100周期后或滿足需求后跳出循環(huán)。

[0195]

圖9示出了根據(jù)本發(fā)明實施例的分層強化學(xué)習(xí)框架的決策過程。

[0196]

步驟8’,觀察分層強化學(xué)習(xí)框架的訓(xùn)練效果,若滿足應(yīng)用需求就可以部署于實際的決策問題,如圖9示出了最終模型的決策過程,將狀態(tài)s輸入ddqn模型中的q網(wǎng)絡(luò),q網(wǎng)絡(luò)輸出選擇各ddpg模型對應(yīng)的獎勵,將狀態(tài)s輸入最大獎勵的ddpg模型中的actor網(wǎng)絡(luò),輸出最優(yōu)的動作。

[0197]

需要說明的是,步驟8’中為分層強化學(xué)習(xí)框架的應(yīng)用階段,此時狀態(tài)用s表示而非s

t

。

[0198]

圖10示出了根據(jù)本發(fā)明實施例的分層強化學(xué)習(xí)框架訓(xùn)練過程中的勝率變化曲線;圖11示出了根據(jù)本發(fā)明實施例的分層強化學(xué)習(xí)框架訓(xùn)練過程中的平均獎勵值的變化曲線。

[0199]

本實施例中,依據(jù)以上方法進行模型訓(xùn)練,如圖10所示,最終本實施例模型的無人機追擊目標飛機的成功率穩(wěn)定在0.8以上,并且在訓(xùn)練過程中的成功率最高可達0.94。

[0200]

圖12a示出了根據(jù)本發(fā)明實施例的優(yōu)勢態(tài)勢下的無人機追擊目標飛機的軌跡;圖12b示出了根據(jù)本發(fā)明實施例的優(yōu)勢態(tài)勢下無人機追擊目標飛機過程中底層模型切換的過程;圖12c示出了根據(jù)本發(fā)明實施例的優(yōu)勢態(tài)勢下無人機追擊目標飛機過程中獎勵值的變化過程;圖13a示出了根據(jù)本發(fā)明實施例的均勢態(tài)勢下的無人機追擊目標飛機的軌跡;圖13b示出了根據(jù)本發(fā)明實施例的均勢態(tài)勢下無人機追擊目標飛機過程中底層模型切換的過程;圖13c示出了根據(jù)本發(fā)明實施例的均勢態(tài)勢下無人機追擊目標飛機過程中獎勵值的變化過程;圖14a示出了根據(jù)本發(fā)明實施例的劣勢態(tài)勢下的無人機追擊目標飛機的軌跡;圖14b示出了根據(jù)本發(fā)明實施例的劣勢態(tài)勢下無人機追擊目標飛機過程中底層模型切換的過程;圖14c示出了根據(jù)本發(fā)明實施例的劣勢態(tài)勢下無人機追擊目標飛機過程中獎勵值的變化過程。

[0201]

如圖12a、13a、14a所示,無人機可以在優(yōu)勢態(tài)勢、均勢態(tài)勢和劣勢態(tài)勢下均可實現(xiàn)對目標飛機的追擊,并且圖12b、圖13b、圖14b顯示出在追擊過程中進行的5個底層決策模型之間進行切換,如圖12c、圖13c、圖14c所示,無人機在追擊目標飛機的過程中整體優(yōu)勢呈現(xiàn)增加趨勢。

[0202]

本領(lǐng)域技術(shù)人員在考慮說明書及實踐這里公開的發(fā)明后,將容易想到本發(fā)明的其它實施方案。本技術(shù)旨在涵蓋本發(fā)明的任何變型、用途或者適應(yīng)性變化,這些變型、用途或

者適應(yīng)性變化遵循本發(fā)明的一般性原理并包括本發(fā)明未公開的本技術(shù)領(lǐng)域中的公知常識或慣用技術(shù)手段。說明書和實施例僅被視為示例性的,本發(fā)明的真正范圍和精神由下面的權(quán)利要求指出。

[0203]

應(yīng)當(dāng)理解的是,本發(fā)明并不局限于上面已經(jīng)描述并在附圖中示出的精確結(jié)構(gòu),并且可以在不脫離其范圍進行各種修改和改變。本發(fā)明的范圍僅由所附的權(quán)利要求來限制。

技術(shù)特征:

1.一種用于多目標決策的分層強化學(xué)習(xí)框架訓(xùn)練方法,其特征在于,所述分層強化學(xué)習(xí)框架訓(xùn)練方法包括如下步驟:基于所研究的實際問題,建立智能體與環(huán)境交互的仿真環(huán)境模型,使所述智能體生成策略后能夠?qū)幼髟谒龇抡姝h(huán)境模型中執(zhí)行;將所述實際問題劃分為多個子目標,針對多個所述子目標,通過分配不同的目標權(quán)重建立多個獎勵函數(shù)模型;基于多個所述獎勵函數(shù)模型,建立對應(yīng)的多個ddpg模型;將多個所述ddpg模型的對應(yīng)策略視為離散動作,建立對應(yīng)的ddqn模型;將所述ddpg模型作為底層決策模型,所述ddqn模型作為選擇所述底層決策模型的頂層決策模型,構(gòu)建基于兩層決策過程的分層強化學(xué)習(xí)框架;基于所述分層強化學(xué)習(xí)框架和所述仿真環(huán)境模型進行交互并存儲經(jīng)驗;存儲所述經(jīng)驗后,依照設(shè)定的模型訓(xùn)練頻率訓(xùn)練所述ddpg模型和所述ddqn模型,判斷訓(xùn)練后的所述ddpg模型和所述ddqn模型是否滿足應(yīng)用需求,若滿足需求則退出訓(xùn)練過程,否則重新存儲經(jīng)驗和重新訓(xùn)練所述ddpg模型和所述ddqn模型;在應(yīng)用階段,將所述智能體所處狀態(tài)輸入訓(xùn)練好的所述ddpg模型和所述ddqn模型,由所述頂層決策模型輸出各底層決策模型被選擇后所獲得的獎勵,激活最大獎勵對應(yīng)的所述底層決策模型,生成連續(xù)機動動作序列。2.根據(jù)權(quán)利要求1所述的用于多目標決策的分層強化學(xué)習(xí)框架訓(xùn)練方法,其特征在于,所述獎勵函數(shù)模型作為所述智能體在所述仿真環(huán)境模型中執(zhí)行所述動作a

t

后,所述仿真環(huán)境模型對所述智能體的反饋r

t

;所述ddpg模型的輸入為所述智能體當(dāng)前所處的狀態(tài)s

t

,輸出為在當(dāng)前狀態(tài)下所產(chǎn)生的動作a

t

;所述ddqn模型的輸入為所述智能體當(dāng)前所處的狀態(tài)s

t

,輸出為各所述ddpg模型被選擇的所獲得的獎勵p

t

。3.根據(jù)權(quán)利要求2所述的用于多目標決策的分層強化學(xué)習(xí)框架訓(xùn)練方法,其特征在于,通過分配不同的目標權(quán)重建立多個所述獎勵函數(shù)模型:其中,不同的權(quán)重w

i

滿足:其中,n為獎勵函數(shù)模型影響因素的個數(shù);r

i

為第i個獎勵函數(shù)模型對應(yīng)的獎勵。4.根據(jù)權(quán)利要求2所述的用于多目標決策的分層強化學(xué)習(xí)框架訓(xùn)練方法,其特征在于,所述ddpg模型包括actor網(wǎng)絡(luò)θ、actor目標網(wǎng)絡(luò)θ'、critic網(wǎng)絡(luò)ω和critic目標網(wǎng)絡(luò)ω',所述actor網(wǎng)絡(luò)用于生成策略,所述actor目標網(wǎng)絡(luò)用于指導(dǎo)所述critic網(wǎng)絡(luò)的更新,所述critic網(wǎng)絡(luò)用于評價所述策略,所述critic目標網(wǎng)絡(luò)用于計算q值,其中,q值為動作價值函數(shù),即在當(dāng)前狀態(tài)下執(zhí)行該動作對應(yīng)的獎勵值。5.根據(jù)權(quán)利要求4所述的用于多目標決策的分層強化學(xué)習(xí)框架訓(xùn)練方法,其特征在于,所述actor網(wǎng)絡(luò)θ的目標是輸出最優(yōu)策略使所述critic網(wǎng)絡(luò)ω的輸出最大,因此所述actor網(wǎng)絡(luò)θ的目標輸出為:

其中,δa為動作a的增量,q(s

t

,a,ω)為當(dāng)前狀態(tài)下critic網(wǎng)絡(luò)的評價;為critic網(wǎng)絡(luò)對a的偏導(dǎo),r

a

為actor網(wǎng)絡(luò)的學(xué)習(xí)率;a為當(dāng)前狀態(tài)下所產(chǎn)生的策略;所述critic網(wǎng)絡(luò)ω的目標是擬合當(dāng)前狀態(tài)下執(zhí)行該策略所帶來的累計獎勵,即動作價值函數(shù),所述critic網(wǎng)絡(luò)ω的目標輸出為:q(s

t

,a

t

)=r

t

+γr

t+1

+γ2r

t+2

+

…

=r

t

+γ(r

t+1

+γr

t+2

+

…

)=r

t

+γq(s

t+1

,a

t+1

)

……

(3)其中,r

t

為當(dāng)前狀態(tài)s

t

執(zhí)行動作a

t

所獲得的獎勵;γ表示獎勵的衰減因子;q(s

t+1

,a

t+1

)表示下一狀態(tài)獲得的獎勵;計算所述actor網(wǎng)絡(luò)θ的目標輸出和所述critic網(wǎng)絡(luò)ω的目標輸后,使用mse作為損失函數(shù)分別訓(xùn)練所述actor網(wǎng)絡(luò)和所述critic網(wǎng)絡(luò)。6.根據(jù)權(quán)利要求5所述的用于多目標決策的分層強化學(xué)習(xí)框架訓(xùn)練方法,其特征在于,所述actor目標網(wǎng)絡(luò)θ'由所述actor網(wǎng)絡(luò)θ軟更新得到:θ'=θ'τ+θ(1-τ)

……

(4)所述critic目標網(wǎng)絡(luò)ω'由所述critic網(wǎng)絡(luò)ω軟更新得到:ω'=ω'τ+ω(1-τ)

……

(5)其中,τ為軟更新率。7.根據(jù)權(quán)利要求5所述的用于多目標決策的分層強化學(xué)習(xí)框架訓(xùn)練方法,其特征在于,所述ddqn模型包括q網(wǎng)絡(luò)η和目標q網(wǎng)絡(luò)η',所述q網(wǎng)絡(luò)η擬合選擇該所述ddpg模型獲得的累計獎勵目標,所述q網(wǎng)絡(luò)η計算下一時刻的q值,所述q網(wǎng)絡(luò)η的目標輸出為:其中,j=1

…

m,m為ddpg模型個數(shù);(s

t+1

)

j

為選擇第j個ddpg模型對應(yīng)的下一狀態(tài);r

j

為選擇第j個ddpg模型所得到的獎勵,maxq((s

t+1

)

j

,η')為目標q網(wǎng)絡(luò)η'對狀態(tài)(s

t+1

)

j

所對應(yīng)q值中的最大值;計算出所述q網(wǎng)絡(luò)η的目標輸出后,使用mse作為損失函數(shù)訓(xùn)練q網(wǎng)絡(luò)模型。8.根據(jù)權(quán)利要求7所述的用于多目標決策的分層強化學(xué)習(xí)框架訓(xùn)練方法,其特征在于,所述目標q網(wǎng)絡(luò)η'由所述q網(wǎng)絡(luò)η軟更新得到:η'=η'τ+η(1-τ)

……

(7)其中,τ為軟更新率。9.根據(jù)權(quán)利要求8所述的用于多目標決策的分層強化學(xué)習(xí)框架訓(xùn)練方法,其特征在于,所述軟更新頻率低于對應(yīng)的所述ddpg模型和所述ddqn模型的訓(xùn)練頻率,所述分層強化學(xué)習(xí)框架的訓(xùn)練過程中,所述頂層決策模型的訓(xùn)練頻率低于所述底層決策模型的訓(xùn)練頻率。

技術(shù)總結(jié)

本發(fā)明提供了一種多目標決策的分層強化學(xué)習(xí)框架訓(xùn)練方法,包括基于所研究的實際問題,建立智能體與環(huán)境交互的仿真環(huán)境模型;將實際問題劃分為多個子目標,通過分配不同的目標權(quán)重建立多個獎勵函數(shù)模型;基于獎勵函數(shù)模型建立對應(yīng)的多個DDPG模型;將各DDPG模型的對應(yīng)策略視為離散動作建立對應(yīng)的DDQ模型;將DDPG模型作為底層決策模型,DDQ模型作為選擇底層決策模型的頂層決策模型,構(gòu)建分層強化學(xué)習(xí)框架;基于分層強化學(xué)習(xí)框架和仿真環(huán)境模型進行交互并存儲經(jīng)驗;依照設(shè)定的模型訓(xùn)練頻率訓(xùn)練DDPG模型和DDQ模型,判斷模型是否滿足需求,若滿足需求則退出訓(xùn)練過程,否則重新存儲經(jīng)驗、訓(xùn)練模型。構(gòu)建能更快接近最終目標的分布式?jīng)Q策模型,生成最優(yōu)連續(xù)策略組合。生成最優(yōu)連續(xù)策略組合。生成最優(yōu)連續(xù)策略組合。