一種基于神經網絡和視聽融合的聲樂表演評分方法及系統

1.本發明屬于聲樂測評領域,涉及一種基于神經網絡和視聽融合的聲樂表演評分方法及系統。

背景技術:

2.在現在的美育考試中,如聲樂考試,通常由考官對考生的演唱水平進行客觀評價并給出相應分值。在此過程中,可能會因為某些因素使得考試缺乏主觀性、準確性與高效便捷性。

3.市面上現有的音頻特征提取、評分軟件,已經可以很好的對演唱者的演唱節奏、氣息、聲調等方面進行評分,但是評分維度單一,缺乏了對藝術整體性的體現。

4.因此,為了提高現有音頻測評軟件的準確性,亟需一種基于神經網絡和視聽融合的聲樂表演評分方法及系統來解決此問題。

技術實現要素:

5.有鑒于此,本發明的目的在于提供一種基于神經網絡和視聽融合的聲樂表演評分方法,結合視覺與聽覺對于演唱者演唱時的面部表現情感以及演唱者著裝進行一系列的評分和判斷,具體是采用大量多維度的專家評分數據,包括音頻評分、著裝評分與情感評分,利用神經網絡構建了專家庫體系,使評測結果更加真實有效、貼近專家評分。此外,評分流程更加高效便捷。

6.為達到上述目的,本發明提供如下技術方案:

7.方案1:一種基于神經網絡和視聽融合的聲樂表演評分方法,利用不同的神經網絡分別得到三個維度的評分數據,包括音頻評分、情感評分與著裝評分,然后將三個維度的評分輸入到視聽融合專家評分網絡,最后得到總體評分。該方法具體包括以下步驟:

8.s1:獲取表演者的音頻數據,預處理得到高音特征和節奏特征,然后分別與標準音頻數據對比得到最小距離向量和節奏契合度,并將其輸入音頻評分神經網絡中得到音頻評分;

9.s2:對演唱視頻進行關鍵幀提取,預處理得到關鍵幀對應的音頻和人臉區域圖片,從中對應提取音高序列和面部特征,將其對應輸入到音頻情感神經網絡和人臉關鍵點檢測器中,得到音頻情感特征向量和面部表情特征向量,然后計算音頻情感特征向量與面部情感特征向量的歐式距離,即特征向量相似性;最后將特征向量相似性輸入視聽融合情感評分神經網絡中得到情感評分;

10.s3:截取演唱視頻中一幀的圖片,從中提取服裝的關鍵特征,輸入服裝風格評估神經網絡得到演唱者服裝風格圖像特征向量;然后從對應視頻的音頻數據中得到梅爾頻譜圖,輸入音頻風格評估神經網絡得到演唱者音樂風格特征向量;最后將演唱者的服裝風格特征向量和音樂風格特征向量輸入視聽融合著裝評分神經網絡中得到著裝評分;

11.s4:將音頻評分、情感評分和著裝評分輸入到視聽融合專家評分網絡,得到總體評

分。

12.進一步,步驟s1具體包括以下步驟:

13.s101:將由專家打分的表演者視頻樣本根據7:2:1將樣本數據劃分成訓練集、驗證集和測試集;

14.s102:對音頻數據進行預處理,采用音強進行邊界檢測和去噪處理,利用帶通濾波器進行預濾波,利用高通濾波器對語音信號進行預加重,最后對音頻數據進行分幀加窗;

15.s103:采用諧波總和法(shs)進行音高特征提取,對輸入音頻進行分幀加窗的處理,對每一幀的語音信號進行短時傅里葉變換得到頻譜,針對每個頻率,疊加倍頻諧波的能量,最后得到歌唱數據的音高。

16.s104:對提取的音高序列進行平滑處理;

17.s105:采用相似度匹配算法(dtw),度量提取的音高特征和標準音高特征的相似度,得到兩段旋律特征向量的最小距離;

18.s106:對音樂標準庫提供的solo歌聲和伴奏音樂,按照一定的時移進行混音,合成適用于訓練節奏模型的搶拍、慢拍和合拍音頻;

19.s107:求取頻率強度曲線,首先進行音頻預處理(預濾波,預加重等),對音頻分幀加窗,通過傅里葉變換得到信號頻譜,根據諧波總和法的思想,疊加各個頻率的能量總和,得到頻率能量曲線,通過刻度轉換,采用半音值表示音頻音高,得到頻率強度曲線;

20.s108:使用標準帶伴奏歌聲提取頻率強度曲線,訓練,建立基于以隱馬爾科夫模型的節奏模型,頻率強度序列視為可觀測序列;

21.s109:采用維比特算法進行音樂的模型識別,選擇具有最大的累積概率的路徑作為識別結果;

22.s110:綜合所有音頻片段的模型識別結果,量化整首演唱音樂的節奏契合程度;

23.s111:將s105中得到的旋律特征向量的最小距離,以及s110得到的節奏契合程度輸入到音頻評分神經網絡(基于專家評分的有監督學習bp神經網絡),訓練得到音頻評分。

24.進一步,步驟s2具體包括以下步驟:

25.s201:對視頻數據進行關鍵幀提取,得到靜態圖片,并記錄關鍵幀開始與結束時刻,并從靜態圖片中檢測出人臉區域,得到人臉區域圖片;

26.s202:對每幀人臉區域圖片進行高斯濾波,并根據霍夫變換計算傾斜角度,最后根據傾斜角度進行圖像的矯正;

27.s203:對圖像進行灰度化與歸一化;

28.s204:采用人臉關鍵點檢測模型庫,獲取面部特征點;

29.s205:通過開口程度、瞇眼程度、眉毛上揚程度等信息來識別演唱者演唱情緒。可分為:歡快、哀傷、抒情、激情、憤怒、從容、堅毅和安靜8種演唱情緒類型,得到面部情感特征向量;

30.s206:在專家所進行情感分類標注后的音頻中,按照訓練數據:驗證數據:測試數據=7:2:1劃分;

31.s207:構建音頻情感提取神經網絡(三層的bp神經網絡)作為音頻情感分類器,并提取音頻特征向量:音高、頻率、音強作為網絡輸入;

32.s208:完成音頻情感提取神經網絡構建后,輸入訓練數據進行訓練;訓練完畢后,

使用驗證數據進行驗證,可以達到預期要求。

33.s209:將被測音頻通過s205所記錄的時刻進行截取后,放入先前訓練好的音頻情感提取神經網絡,得到該音頻情感特征向量;

34.s210:計算音頻情感特征向量與面部情感特征向量的歐式距離,度量其向量相似性;

35.s211:將特征向量相似性信息放入視聽融合情感評分神經網絡中,按照專家定制的標準,得到情感評分。

36.進一步,步驟s3具體包括以下步驟:

37.s301:在輸入的視頻信息中截取一幀的圖片內容作為演唱者服裝風格識別分析的輸入信息,將輸入的視頻信息中的聲音軌道內容導出為.wav格式,作為音樂曲風分析的輸入信息;

38.s302:在服裝風格識別分析中通過圖像處理和機器學習技術,建立演唱者服裝圖像和實際服裝風格之間的映射關系;

39.s303:在圖像處理過程中,使用服裝風格評估卷積神經網絡,為了有效地降低了網絡的復雜度且、減少了參數的數量,網絡中主要采用以下步驟:卷積、池化、全連接與激活函數,完成神經網絡的構建;

40.s304:用機器學習進行服裝風格分析中,使用訓練較好的服裝風格評估神經網絡,將輸入的圖片進行像素點提取格式化,然后對每張圖片進行卷積和池化等一系列操作,獲取關鍵特征點;

41.s305:通過圖像中演唱者衣著的面料、花、局部繡花、領結領花等不同分類信息來識別演唱者的服裝風格;可以分為經典、淑女、浪漫、民族、前衛、輕快、學院、休閑、中性、田園、朋克、街頭、簡約、運動、優雅、未來等16種衣著風格。

42.s306:在音樂曲風分析中,將音頻信息進行預處理、傅里葉變換得到頻域信息,并對頻域信息進行疊加,得到梅爾頻譜,使用音樂風格評估神經網絡來對這些樣本進行訓練分類,得到演唱音樂與表演者音樂風格之間的映射關系;

43.s307:在音樂風格評估神經網絡中輸入一個已經優化的數據集,利用傅里葉變化將音頻數據轉移到頻域,進行導出歌曲所有頻率基于時間的演變信息;

44.s308:創建頻譜的固定長度的片,將聲樂頻譜降低到256

×

256分辨率的切片,作為代表音樂風格的獨立樣本;

45.s309:建立一個分類器,把訓練集的歌曲切成方形光譜圖像之后,作為一個數據集,其中每個類型包含數萬個樣本;

46.s310:使用了tensorflow深度學習庫進行的包裝器tflearn,用深層卷積神經網絡,對這些樣本進行訓練分類;

47.s311:將.wav格式的音樂輸入s310訓練好的深層卷積神經網絡,根據不同曲風的聲音頻率有一定的區別,得出可以分為民族、美聲、藍調、經典、迪斯科、嘻哈、爵士、金屬、流行、雷鬼、搖滾等11中音樂風格;

48.s312:將所輸出的演唱者服裝風格特征向量與音樂風格特征向量,放入視聽融合著裝評分神經網絡中,按照專家定制的標準,計算特征向量的相似度,得到演奏者演奏服裝與音樂風格的匹配度評分,即著裝評分。

49.進一步,步驟s4中,視聽融合專家評分網絡是采用專家評分的機制,專家根據三個維度打分,分別是音頻評分、情感評分和著裝評分,三個維度均采用百分制,根據三個維度的分數構建數據集,神經網絡通過有監督的學習專家的評分點,進一步的,專家根據音樂表演的總體表現進行打分,該總體分數依然是百分制,根據專家所打分數構建數據集,視聽融合專家評分網絡學習專家對三個維度打分的權重。該評分方法,改善了傳統評分方法僅根據音高,節奏打分,過于機械的特點,以專家給定的專業評分數據作為預測目標,與傳統打分點相結合,使分數更具有可靠性,更加人性化。

50.進一步,音頻評分神經網絡、視聽融合情感評分神經網絡、視聽融合著裝評分神經網絡和視聽融合專家評分網絡可獨立同步進行訓練,訓練完成后組會一起使用;各網絡在訓練過程中,先將由專家打分的表演者視頻樣本根據7:2:1將數據分成訓練集、驗證集和測試集;每個樣本包含視頻和4個百分制的得分,其中得分由專家針對情感、著裝、音樂和總評分別給出;針對各網絡的訓練,(1)根據數據特性選擇重要參數,包括卷積核(尺寸、數目)、注意力機制、激活函數、損失函數、網絡層數、網絡優化器和學習率等;(2)按照時間軸同步,將圖像的特征向量和音頻的特征向量聯合輸入到各評分神經網絡中,以網絡的輸出分數和專家給定專業評分數的差值作為損失函數,采用反向傳播算法讓損失函數最小化;(3)通過觀測訓練集和驗證集的損失函數曲線,當兩者的曲線走勢出現轉折時,終止訓練過程,并以此時的迭代次數確定神經網絡參數,并用測試數據進行測試;(4)對訓練好的神經網絡對測試集進行測試,如果網絡輸出的評分和專家給出的分數差值在1分之內,則該網絡已通過測試,可以用于后續的其他表演者的測評過程;否則,重新對網絡進行設計調整,并重復網絡訓練過程。

51.方案2:一種基于神經網絡和視聽融合的聲樂表演評分系統,包括服務器、攝像頭、麥克風、dsp解碼器和通信網絡;所述服務器用于執行方案一中的聲樂表演評分方法。

52.本發明的有益效果在于:本發明采用的專家評分擬合神經網絡是根據專家對聲樂表演的總體表現評分構建數據集,改善了傳統評分方法僅根據音高,節奏打分,過于機械的特點,以專家給定的專業評分數據作為預測目標,更加人性化。

53.本發明方法結合了聲樂表演時的情感評分、著裝評分與音準評分,同時采用了與專家評分相結合的方式,使得測評標準更加的多元化、測評結果更加準確化,很好地滿足了中小學藝術素質測評中音樂演唱評分客觀準確的要求。

54.本發明的其他優點、目標和特征在某種程度上將在隨后的說明書中進行闡述,并且在某種程度上,基于對下文的考察研究對本領域技術人員而言將是顯而易見的,或者可以從本發明的實踐中得到教導。本發明的目標和其他優點可以通過下面的說明書來實現和獲得。

附圖說明

55.為了使本發明的目的、技術方案和優點更加清楚,下面將結合附圖對本發明作優選的詳細描述,其中:

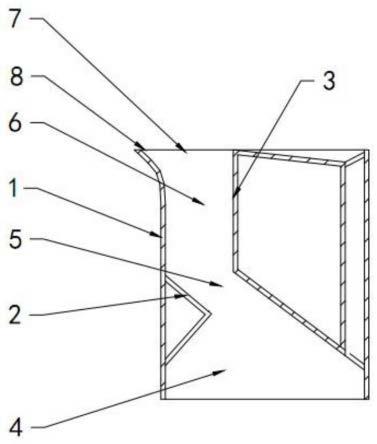

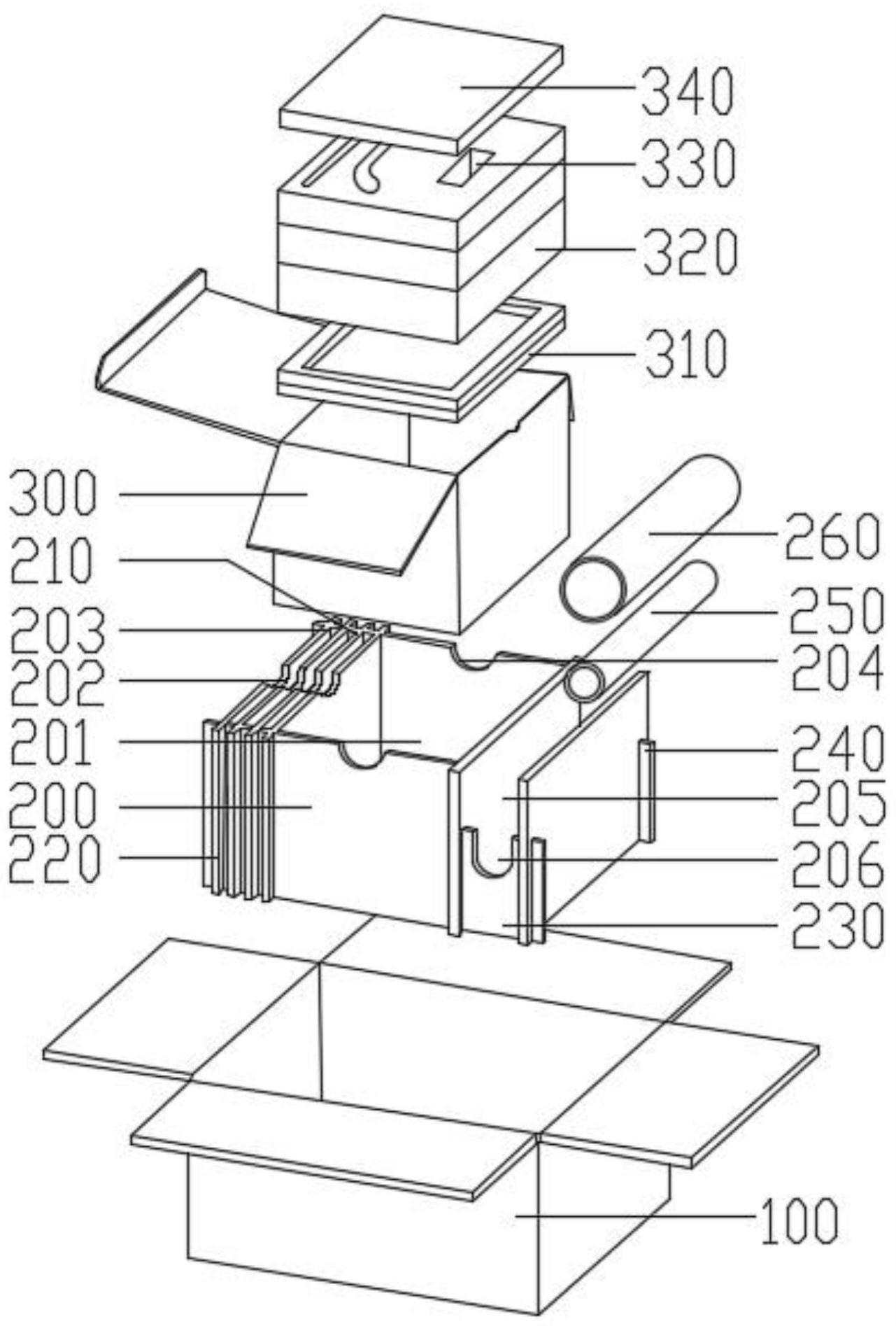

56.圖1為聲樂表演俯視圖;

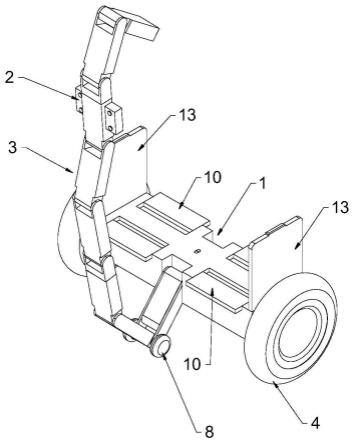

57.圖2為總體架構示意圖;

58.圖3為網絡訓練和測評過程示意圖;

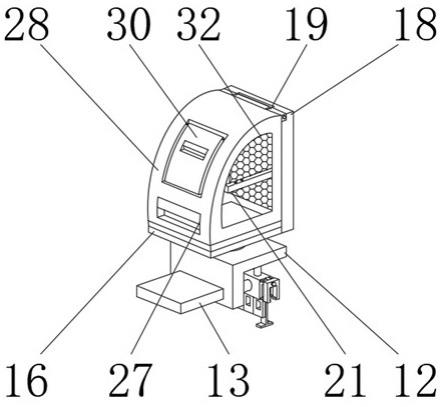

59.圖4為聲樂表演表情識別示意圖;

60.圖5為演唱者服裝匹配度評分示意圖;

61.圖6為音樂風格識別示意圖;

62.圖7為神經網絡的框架圖。

具體實施方式

63.以下通過特定的具體實例說明本發明的實施方式,本領域技術人員可由本說明書所揭露的內容輕易地了解本發明的其他優點與功效。本發明還可以通過另外不同的具體實施方式加以實施或應用,本說明書中的各項細節也可以基于不同觀點與應用,在沒有背離本發明的精神下進行各種修飾或改變。需要說明的是,以下實施例中所提供的圖示僅以示意方式說明本發明的基本構想,在不沖突的情況下,以下實施例及實施例中的特征可以相互組合。

64.請參閱圖1~圖7,本實施例提供一種基于神經網絡和視聽融合的聲樂表演評分系統,包括服務器、攝像頭、麥克風、dsp解碼器、通信網絡。通信網絡為有線網絡或者無線網絡(如wi-fi等),用于數據交互。服務器為云服務器或者實體服務器,用于處理數據(即執行基于神經網絡和視聽融合的聲樂表演評分方法)。

65.圖1是聲樂表演俯視圖,包括房間大小設計、麥克風陣列、攝像機部署和吸聲材料安裝等。

66.圖2是基于神經網絡和視聽融合的聲樂表演評分方法流程圖,該方法具體包括以下步驟:

67.步驟1:將系統預先收集的包含專家評分的視唱練習數據進行劃分,將數據按7:2:1劃分,其中的7份作為訓練數據,2份為驗證數據,1份作為測試數據,使用訓練數據建模;

68.步驟2:對歌唱數據進行預處理,采用音強進行邊界檢測和去噪處理,利用帶通濾波器進行預濾波,利用高通濾波器對語音信號進行預加重,最后對歌唱數據進行分幀加窗。

69.步驟3:采用諧波總和法(shs)進行音高特征提取,對輸入音頻進行分幀加窗的處理,對每一幀的語音信號進行短時傅里葉變換得到頻譜,針對每個頻率,疊加倍頻諧波的能量,最后得到歌唱數據的音高。

70.步驟4:對提取的音高序列進行平滑處理。

71.步驟5:采用相似度匹配算法(dtw),度量提取的音高特征和標準音高特征的相似度,得到兩段旋律特征向量的最小距離。

72.步驟6:對音樂標準庫提供的solo歌聲和伴奏音樂,按照一定的時移進行混音,合成適用于訓練節奏模型的搶拍,慢拍,合拍音頻。

73.步驟7:求取頻率強度曲線,首先進行音頻預處理(預濾波,預加重等),對音頻分幀加窗,通過傅里葉變換得到信號頻譜,根據諧波總和法的思想,疊加各個頻率的能量總和,得到頻率能量曲線,通過刻度轉換,采用半音值表示音頻音高,得到頻率強度曲線。

74.步驟8:使用標準帶伴奏歌聲提取頻率強度曲線,訓練,建立基于以隱馬爾科夫模型的節奏模型,頻率強度序列視為可觀測序列。

75.步驟9:采用維比特算法進行音樂的模型識別,選擇具有最大的累積概率的路徑作為識別結果。

76.步驟10:綜合所有音頻片段的模型識別結果,量化整首演唱音樂的節奏契合程度。

77.步驟11:將步驟5中得到的旋律特征向量的最小距離,步驟10得到的節奏契合程度作為輸入值,采用基于專家評分的有監督學習bp神經網絡,訓練神經網絡,百分制評分即為網絡輸出。

78.步驟12:使用python的pyav和pillow庫對演唱視頻進行關鍵幀提取,得到靜態圖片,并記錄關鍵幀開始與結束時刻,使用opencv中的viola-jones檢測器從靜態圖片中檢測出人臉區域,得到人臉區域圖片。

79.步驟13:對每幀人臉區域圖片進行高斯濾波,并根據霍夫變換進行傾斜角度的計算,最后根據傾斜角度進行圖像的矯正。

80.步驟14:對圖像進行灰度化與歸一化。

81.步驟15:采用dlib庫中人臉68個關鍵點檢測shape_predictor_68_face_landmarks.dat的dat模型庫,進行面部68個特征點的信息獲取。

82.步驟16:通過開口程度、瞇眼程度、眉毛上揚程度等信息來識別演唱者演唱情緒。可分為:歡快、哀傷、抒情、激情、憤怒、從容、堅毅和安靜8種演唱情緒類型,得到面部情感特征向量。

83.步驟17:在專家所進行情感分類標注后的音頻中,按照7:2:1的比例劃分,7份訓練數據,2份驗證數據,1份測試數據。

84.步驟18:構建3層的bp神經網絡作為音頻情感分類器,并利用python的librosa庫提取音頻特征向量:音高、頻率、音強。

85.其中,輸入層為情感特征的三維向量,分別為:音高、頻率、音強。因此,輸入層節點數為3。

86.bp神經網絡分類器輸出的是音頻情感,有歡快、哀傷、抒情、激情、憤怒、從容、堅毅和安靜8種音樂情感類型,因此輸出層節點為3(log28=3)。其中,八種情感分別表示為:歡快的(0,0,0)、哀傷的(0,0,1)、抒情的(0,1,0)、激情的(0,1,1)、憤怒的(1,0,0)、從容的(1,0,1)、堅毅的(1,1,0)、安靜的(1,1,1)。

87.步驟181:根據kolmogorov定理,設計隱藏節點數為7層。最終構建的網絡結構是3

×7×

3,3個神經元為輸入層,7個神經元為隱藏層,3個神經元為輸出層。

88.步驟182:隱藏層與輸出層均選用sigmoid函數作為激活函數。并且設定最大循環次數為2000,誤差期望值為0.001。

89.步驟19:完成bp神經網絡模型的構建后,輸入訓練數據進行訓練。訓練完畢后,使用驗證數據進行驗證,可以達到預期要求。

90.步驟20:將被測音頻通過步驟16所記錄的時刻進行截取后,放入先前訓練好的bp神經網絡,得到該音頻情感特征向量。

91.步驟21:使用python計算音頻情感特征向量與面部情感特征向量的歐式距離,度量其向量相似性。

92.步驟22:將特征向量相似性信息放入專家評分網絡中,按照專家定制的標準,得到演唱情感評分,按照百分制輸出。

93.步驟23:在輸入的視頻信息中截取一幀的圖片內容作為演唱者服裝風格識別分析的輸入信息,將輸入的視頻信息中的聲音軌道內容導出為.wav格式,作為音樂曲風分析的

輸入信息。

94.步驟24:在服裝風格識別分析中通過圖像處理和機器學習技術,建立演唱者服裝圖像和實際服裝風格之間的映射關系。

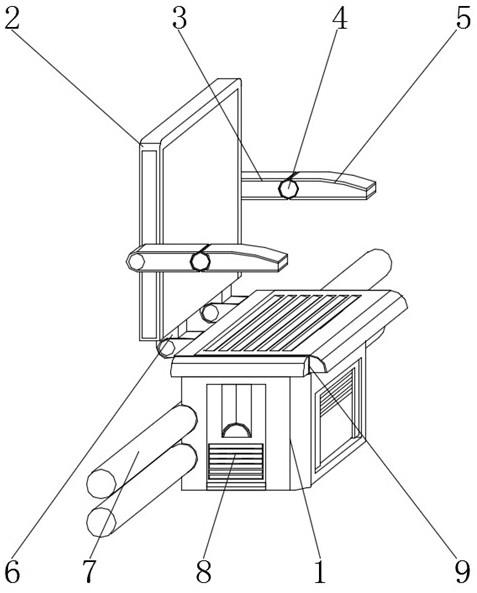

95.步驟25:在圖像處理過程中,使用卷積神經網絡,為了有效地降低了網絡的復雜度且、減少了參數的數量,網絡中主要采用以下步驟:卷積、池化、全連接與激活函數,完成神經網絡的構建。

96.步驟26:用機器學習進行服裝風格分析中,使用訓練較好的卷積神經網絡模型,將輸入的圖片進行像素點提取格式化,然后對每張圖片進行卷積、池化等一系列操作,進行關鍵特征點的獲取。

97.步驟27:通過圖像中演唱者衣著的面料、花、局部繡花、領結領花等不同分類信息來識別演唱者的服裝風格。可以分為經典、淑女、浪漫、民族、前衛、輕快、學院、休閑、中性、田園、朋克、街頭、簡約、運動、優雅、未來等16種衣著風格。

98.步驟28:在音樂曲風分析中,將音頻信息進行預處理、傅里葉變換得到頻域信息,并對頻域信息進行疊加,得到梅爾頻譜,使用深層卷積神經網絡來對這些樣本進行訓練分類,來得到演唱音樂與演唱者音樂風格之間的映射關系。

99.步驟29:在深層卷積神經網絡中輸入一個已經優化的數據集,利用傅里葉變化將音頻數據轉移到頻域,進行導出歌曲所有頻率基于時間的演變信息。

100.步驟30:創建頻譜的固定長度的片,將聲樂頻譜降低到256

×

256分辨率的切片,作為代表音樂風格的獨立樣本。

101.步驟31:建立一個分類器,把訓練集的歌曲切成方形光譜圖像之后,作為一個數據集,其中每個類型包含數萬個樣本。

102.步驟32:使用了tensorflow深度學習庫進行的包裝器tflearn,用深層卷積神經網絡,對這些樣本進行訓練分類。

103.步驟33:使用如上述所訓練好的深層卷積神經網絡,將.wav格式的音樂進行輸入,根據不同曲風的聲音頻率有一定的區別,可以分為民族、美聲、藍調、經典、迪斯科、嘻哈、爵士、金屬、流行、雷鬼、搖滾等11中音樂風格。

104.步驟34:將所輸出的衣著風格的特征向量與音樂風格的特征向量,放入專家評分網絡中,按照專家定制的標準,計算特征向量的相似度,得到演奏者演奏服裝與音樂風格的匹配度評分,按照百分制輸出。

105.步驟35:基于步驟11、22和34,將各個網絡所得到的百分制評分輸入專家評分網絡,該網絡是有監督學習網絡,采用傳統bp反向傳播網絡,基于專家對演唱者聲樂表演的總體表現打分,輸入為音頻評分,表情評分,服裝評分,輸出為一個總體表現百分制評分。

106.如圖3所示,視聽融合專家評分網絡包含了訓練和測評兩個過程。

107.在訓練過程中,先將由專家打分的表演者視頻樣本根據7:2:1將數據分成訓練集、驗證集和測試集。每個樣品包含了視頻和4個百分制的得分,其中得分由專家針對情感、著裝、音樂和總評分別給出。針對網絡訓練,(1)根據數據特性選擇重要參數,包括卷積核(尺寸、數目)、注意力機制、激活函數、損失函數、網絡層數、網絡優化器、學習率等;(2)按照時間軸同步,將圖像的特征向量和音頻的特征向量聯合輸入到評估神經網絡中,以網絡的輸出分數和專家給定專業評分數的差值作為損失函數,采用反向傳播算法讓損失函數最小

化;(3)多維專家評估網絡(包括音頻評分神經網絡、視聽融合情感評分神經網絡、視聽融合著裝評分神經網絡)和視聽融合專家評分網絡可以獨立同步進行訓練,訓練完成后可以組會一起使用;(4)通過觀測訓練集和驗證集的損失函數曲線,當兩者的曲線走勢出現轉折時,終止訓練過程,并以此時的迭代次數確定神經網絡參數,并用測試數據進行測試;(5)對訓練好的神經網絡對測試集進行測試,如果網絡輸出的評分和專家給定的分數差值在1分之內,則該網絡已通過測試,可以用于后續的其他表演者的測評過程;否則,重新對網絡進行設計調整,并重復網絡訓練過程。

108.視聽融合專家評分網絡模塊主要包含了信號預處理、多維專家評估網絡、專家評分擬合網絡三部分。信號預處理將圖像、音頻信號分離,得到圖像和音頻文件。多維專家評估網絡包含了情感、著裝、音頻三部分的評分網絡,通過專家針對此三方面的打分數據作為網絡的有監督學習,形成對表演者多維度的評價。專家評分擬合網絡主要通過神經網絡,自動擬合三方面評分分數對總評分的權重計算。

109.在測評過程中,把表演者視頻輸入到已訓練完成的視聽融合專家評分網絡中,就可以直接得到最終評分分數。

110.最后說明的是,以上實施例僅用以說明本發明的技術方案而非限制,盡管參照較佳實施例對本發明進行了詳細說明,本領域的普通技術人員應當理解,可以對本發明的技術方案進行修改或者等同替換,而不脫離本技術方案的宗旨和范圍,其均應涵蓋在本發明的權利要求范圍當中。

技術特征:

1.一種基于神經網絡和視聽融合的聲樂表演評分方法,其特征在于,利用不同的神經網絡分別得到三個維度的評分數據,包括音頻評分、情感評分與著裝評分,然后將三個維度的評分輸入到視聽融合專家評分網絡,最后得到總體評分;該方法具體包括以下步驟:s1:獲取表演者的音頻數據,預處理得到高音特征和節奏特征,然后分別與標準音頻數據對比得到最小距離向量和節奏契合度,并將其輸入音頻評分神經網絡中得到音頻評分;s2:對演唱視頻進行關鍵幀提取,預處理得到關鍵幀對應的音頻和人臉區域圖片,從中對應提取音高序列和面部特征,將其對應輸入到音頻情感神經網絡和人臉關鍵點檢測器中,得到音頻情感特征向量和面部表情特征向量,然后計算音頻情感特征向量與面部情感特征向量的歐式距離,即特征向量相似性;最后將特征向量相似性輸入視聽融合情感評分神經網絡中得到情感評分;s3:截取演唱視頻中一幀的圖片,從中提取服裝的關鍵特征,輸入服裝風格評估神經網絡得到演唱者服裝風格圖像特征向量;然后從對應視頻的音頻數據中得到梅爾頻譜圖,輸入音頻風格評估神經網絡得到演唱者音樂風格特征向量;最后將演唱者的服裝風格特征向量和音樂風格特征向量輸入視聽融合著裝評分神經網絡中得到著裝評分;s4:將音頻評分、情感評分和著裝評分輸入到視聽融合專家評分網絡,得到總體評分。2.根據權利要求1所述的聲樂表演評分方法,其特征在于,步驟s1具體包括以下步驟:s101:將由專家打分的表演者視頻樣本根據7:2:1將樣本數據劃分成訓練集、驗證集和測試集;s102:對音頻數據進行預處理,采用音強進行邊界檢測和去噪處理,利用帶通濾波器進行預濾波,利用高通濾波器對語音信號進行預加重,最后對音頻數據進行分幀加窗;s103:采用諧波總和法進行音高特征提取,對輸入音頻進行分幀加窗的處理,對每一幀的語音信號進行短時傅里葉變換得到頻譜,針對每個頻率,疊加倍頻諧波的能量,最后得到歌唱數據的音高;s104:對提取的音高序列進行平滑處理;s105:采用相似度匹配算法,度量提取的音高特征和標準音高特征的相似度,得到兩段旋律特征向量的最小距離;s106:對音樂標準庫提供的solo歌聲和伴奏音樂,按照一定的時移進行混音,合成適用于訓練節奏模型的搶拍、慢拍和合拍音頻;s107:求取頻率強度曲線,首先進行音頻預處理,對音頻分幀加窗,通過傅里葉變換得到信號頻譜,根據諧波總和法的思想,疊加各個頻率的能量總和,得到頻率能量曲線,通過刻度轉換,采用半音值表示音頻音高,得到頻率強度曲線;s108:使用標準帶伴奏歌聲提取頻率強度曲線,訓練,建立基于以隱馬爾科夫模型的節奏模型,頻率強度序列視為可觀測序列;s109:采用維比特算法進行音樂的模型識別,選擇具有最大的累積概率的路徑作為識別結果;s110:綜合所有音頻片段的模型識別結果,量化整首演唱音樂的節奏契合程度;s111:將s105中得到的旋律特征向量的最小距離,以及s110得到的節奏契合程度輸入到音頻評分神經網絡,訓練得到音頻評分。3.根據權利要求1所述的聲樂表演評分方法,其特征在于,步驟s2具體包括以下步驟:

s201:對視頻數據進行關鍵幀提取,得到靜態圖片,并記錄關鍵幀開始與結束時刻,并從靜態圖片中檢測出人臉區域,得到人臉區域圖片;s202:對每幀人臉區域圖片進行高斯濾波,并根據霍夫變換計算傾斜角度,最后根據傾斜角度進行圖像的矯正;s203:對圖像進行灰度化與歸一化;s204:采用人臉關鍵點檢測模型庫,獲取面部特征點;s205:識別演唱者演唱情緒得到面部情感特征向量;s206:在專家所進行情感分類標注后的音頻中,按照訓練數據:驗證數據:測試數據=7:2:1劃分;s207:構建音頻情感提取神經網絡作為音頻情感分類器,并提取音頻特征向量:音高、頻率、音強作為網絡輸入;s208:完成音頻情感提取神經網絡構建后,輸入訓練數據進行訓練;s209:將被測音頻通過s205所記錄的時刻進行截取后,放入先前訓練好的音頻情感提取神經網絡,得到該音頻情感特征向量;s210:計算音頻情感特征向量與面部情感特征向量的歐式距離,度量其向量相似性;s211:將特征向量相似性信息放入視聽融合情感評分神經網絡中,按照專家定制的標準,得到情感評分。4.根據權利要求1所述的聲樂表演評分方法,其特征在于,步驟s3具體包括以下步驟:s301:在輸入的視頻信息中截取一幀的圖片內容作為演唱者服裝風格識別分析的輸入信息,將輸入的視頻信息中的聲音軌道內容導出為.wav格式,作為音樂曲風分析的輸入信息;s302:在服裝風格識別分析中通過圖像處理和機器學習技術,建立演唱者服裝圖像和實際服裝風格之間的映射關系;s303:在圖像處理過程中,使用服裝風格評估神經網絡;s304:用機器學習進行服裝風格分析中,使用訓練好的服裝風格評估神經網絡,將輸入的圖片進行像素點提取格式化,然后對每張圖片進行卷積和池化,獲取關鍵特征點;s305:通過圖像中演唱者衣著的不同分類信息來識別演唱者的服裝風格;s306:在音樂曲風分析中,將音頻信息進行預處理、傅里葉變換得到頻域信息,并對頻域信息進行疊加,得到梅爾頻譜,使用音樂風格評估神經網絡來對樣本進行訓練分類,得到演唱音樂與表演者音樂風格之間的映射關系;s307:在音樂風格評估神經網絡中輸入一個已經優化的數據集,利用傅里葉變化將音頻數據轉移到頻域,進行導出歌曲所有頻率基于時間的演變信息;s308:創建頻譜的固定長度的片,將聲樂頻譜降低到256

×

256分辨率的切片,作為代表音樂風格的獨立樣本;s309:建立一個分類器,把訓練集的歌曲切成方形光譜圖像之后,作為一個數據集,其中每個類型包含數萬個樣本;s310:使用深層卷積神經網絡,對這些樣本進行訓練分類;s311:將.wav格式的音樂輸入s310訓練好的深層卷積神經網絡,根據不同曲風的聲音頻率的區別,得出音樂風格;

s312:將所輸出的演唱者服裝風格特征向量與音樂風格特征向量,放入視聽融合著裝評分神經網絡中,按照專家定制的標準,計算特征向量的相似度,得到演奏者演奏服裝與音樂風格的匹配度評分,即著裝評分。5.根據權利要求1所述的聲樂表演評分方法,其特征在于,步驟s4中,視聽融合專家評分網絡是采用專家評分的機制,專家根據三個維度打分,分別是音頻評分、情感評分和著裝評分,三個維度均采用百分制,根據三個維度的分數構建數據集,神經網絡通過有監督的學習專家的評分點,進一步的,專家根據音樂表演的總體表現進行打分,該總體分數依然是百分制,根據專家所打分數構建數據集,視聽融合專家評分網絡學習專家對三個維度打分的權重。6.根據權利要求1所述的聲樂表演評分方法,其特征在于,音頻評分神經網絡、視聽融合情感評分神經網絡、視聽融合著裝評分神經網絡和視聽融合專家評分網絡能獨立同步進行訓練,訓練完成后組會一起使用;各網絡在訓練過程中,先將由專家打分的表演者視頻樣本根據7:2:1將數據分成訓練集、驗證集和測試集;每個樣本包含視頻和4個百分制的得分,其中得分由專家針對情感、著裝、音樂和總評分別給出;針對各網絡的訓練,(1)根據數據特性選擇重要參數,包括卷積核、注意力機制、激活函數、損失函數、網絡層數、網絡優化器和學習率;(2)按照時間軸同步,將圖像的特征向量和音頻的特征向量聯合輸入到各評分神經網絡中,以網絡的輸出分數和專家給定專業評分數的差值作為損失函數,采用反向傳播算法讓損失函數最小化;(3)通過觀測訓練集和驗證集的損失函數曲線,當兩者的曲線走勢出現轉折時,終止訓練過程,并以此時的迭代次數確定神經網絡參數,并用測試數據進行測試;(4)對訓練好的神經網絡對測試集進行測試,如果網絡輸出的評分和專家給出的分數差值在1分之內,則該網絡已通過測試;否則,重新對網絡進行設計調整,并重復網絡訓練過程。7.一種基于神經網絡和視聽融合的聲樂表演評分系統,其特征在于,包括服務器、攝像頭、麥克風、dsp解碼器和通信網絡;所述服務器中用于執行權利要求1~6中任意一項所述聲樂表演評分方法。

技術總結

本發明涉及一種基于神經網絡和視聽融合的聲樂表演評分方法及系統,屬于聲樂測評領域。該方法利用不同的神經網絡分別得到三個維度的專家評分數據,包括音頻評分、情感評分與著裝評分,然后將三個維度的評分輸入到專家評分擬合神經網絡,最后得到綜合評分。本發明使評測結果更加真實有效、貼近專家評分,評分流程更加高效便捷。程更加高效便捷。程更加高效便捷。