一種基于部分可觀測信息的無人機(jī)集多智能體多域抗干擾方法

1.本發(fā)明屬于無線通信技術(shù)領(lǐng)域,特別是一種基于部分可觀測信息的無人機(jī)集多智能體多域抗干擾方法。

背景技術(shù):

2.近年來,隨著無線電技術(shù)的飛速發(fā)展,無人機(jī)通信系統(tǒng)中諸多優(yōu)勢的不斷凸顯,無人機(jī)被廣泛應(yīng)用于應(yīng)急網(wǎng)絡(luò),緩解通信系統(tǒng)中的終端需求。無人機(jī)集網(wǎng)絡(luò)抗干擾技術(shù)是保障無人機(jī)通信免于干擾威脅的重要技術(shù)。其中,跳頻抗干擾是最常見的抗干擾技術(shù)之一。由于傳統(tǒng)跳頻抗干擾技術(shù)無法應(yīng)對未知高動態(tài)復(fù)雜干擾環(huán)境等問題,基于強(qiáng)化學(xué)習(xí)的跳頻抗干擾技術(shù)已成為近年來無人機(jī)通信網(wǎng)絡(luò)跳頻抗干擾技術(shù)的研究熱點(diǎn)。

3.以往大多數(shù)研究采用q學(xué)習(xí)(q-learning,ql)算法,但只適用于低維離散的動作空間。當(dāng)動作空間較大時,將面臨維數(shù)災(zāi)難的問題。針對上述問題,shangxing wang等人提出了基于深度q網(wǎng)絡(luò)(deep q-network,dqn)在線學(xué)習(xí)的信道選擇算法,這有效的改善了無人機(jī)通信網(wǎng)絡(luò)在復(fù)雜環(huán)境下的抗干擾性能。fuqiang yao和luliang jia借助馬爾可夫博弈框架 (markov game framework),對無人機(jī)集通信系統(tǒng)建立多智能體馬爾科夫決策模型 (markov decision process,mdp)模型,降低了應(yīng)用于實(shí)際通信環(huán)境時的通信開銷。然而,上述抗干擾通信技術(shù)并未考慮到通信環(huán)境部分可觀測問題。

技術(shù)實(shí)現(xiàn)要素:

4.本發(fā)明旨在提供一種基于部分可觀測信息的無人機(jī)集多智能體多域抗干擾方法,利用深度循環(huán)q學(xué)習(xí)(deep recurrent q-network,drqn)算法,簇頭無人機(jī)在建立 dec-pomdp模型的基礎(chǔ)上,通過采用長短期記憶網(wǎng)絡(luò)保留歷史信息數(shù)據(jù)訓(xùn)練drqn,實(shí)現(xiàn)向真實(shí)環(huán)境模型的趨近。

5.實(shí)現(xiàn)本發(fā)明目的的技術(shù)解決方案為:基于部分可觀測信息的無人機(jī)集多智能體多域抗干擾方法,具體步驟為:

6.步驟1:初始化算法參數(shù);

7.步驟2:各簇頭無人機(jī)通過與環(huán)境交互獲得其簇內(nèi)成員無人機(jī)上一時隙所選擇的信道和發(fā)射功率;

8.步驟3:各簇頭無人機(jī)采用ε-greedy算法為其簇內(nèi)成員選擇當(dāng)前時隙的信道和發(fā)射功率;

9.步驟4:各簇頭無人機(jī)計算與其簇內(nèi)成員通信過程所需的能量開銷總和,并獲得對應(yīng)環(huán)境獎勵值;

10.步驟5:將各簇頭無人機(jī)當(dāng)前時隙的觀測值、動作、獎勵和下一時隙的觀測值存入各自的經(jīng)驗池中;

11.步驟6:當(dāng)經(jīng)驗池樣本數(shù)據(jù)足夠時,各簇頭無人機(jī)從各自的經(jīng)驗池中進(jìn)行隨機(jī)采

樣,得到若干批歷史信息數(shù)據(jù)組成時間序列,將時間序列輸入各簇頭無人機(jī)的價值網(wǎng)絡(luò),采用梯度下降法更新價值網(wǎng)絡(luò)參數(shù);

12.步驟7:每隔一定時隙數(shù),復(fù)制價值網(wǎng)絡(luò)的參數(shù)形成新的目標(biāo)網(wǎng)絡(luò);

13.步驟8:重復(fù)步驟2至步驟7,直至完成100次數(shù)據(jù)傳輸;

14.步驟9:重復(fù)步驟8,直至無人機(jī)集網(wǎng)絡(luò)的總獎勵值收斂,完成本地訓(xùn)練。

15.本發(fā)明與現(xiàn)有技術(shù)相比,其顯著優(yōu)點(diǎn)為:(1)提出一種可適用于部分可觀測環(huán)境的多智能體多域抗干擾框架,通過以實(shí)現(xiàn)無人機(jī)集網(wǎng)絡(luò)的長期通信傳輸能耗最小化為目標(biāo),將多域抗干擾決策過程建模為多智能體部分可觀測馬爾科夫過程,并利用簇頭無人機(jī)當(dāng)前時隙的觀測值、動作、獎勵和下一時隙的觀測值作為歷史經(jīng)驗,輔助每個無人機(jī)集智能體完成各自信道選擇和發(fā)射功率分配;(2)提出一種基于多智能體深度循環(huán)q網(wǎng)絡(luò)的多域抗干擾算法,通過采用長短期記憶網(wǎng)絡(luò)保留歷史信息數(shù)據(jù),再輸入到各智能體的深度循環(huán)q網(wǎng)絡(luò)進(jìn)行動作值函數(shù)擬合,并更新各深度循環(huán)q網(wǎng)絡(luò)參數(shù),最終獲得可適應(yīng)未知干擾場景下實(shí)現(xiàn)通信傳輸能耗最小化的無人機(jī)信道和發(fā)射功率最優(yōu)決策。

附圖說明

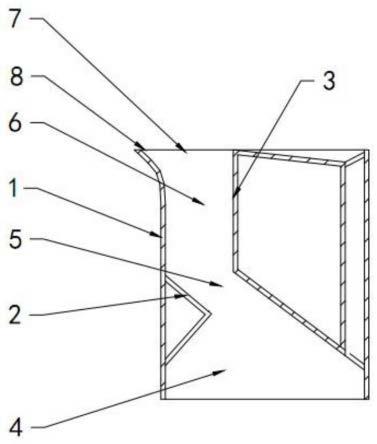

16.圖1為本發(fā)明基于部分可觀測信息的無人機(jī)集多智能體多域抗干擾方法的流程圖。

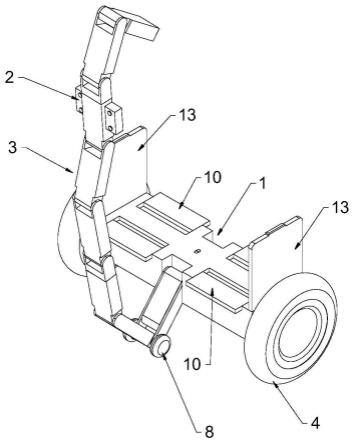

17.圖2為掃頻干擾模式下不同算法的學(xué)習(xí)收斂效果示意圖。

18.圖3為馬爾科夫干擾模式下不同算法的學(xué)習(xí)收斂效果示意圖。

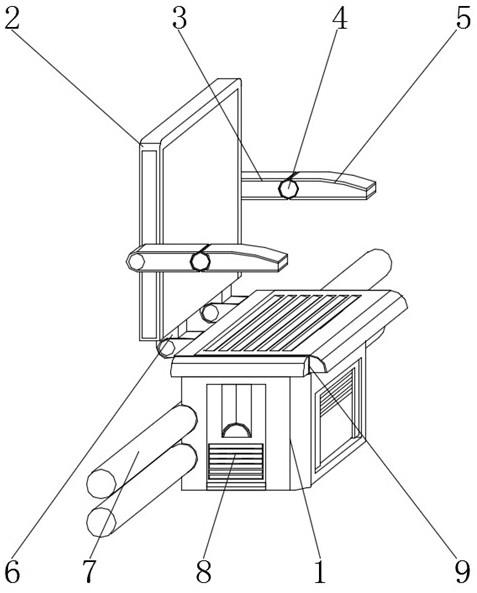

19.圖4為掃頻干擾模式下不同算法環(huán)境獎勵的收斂值與信道數(shù)目的關(guān)系圖。

20.圖5為馬爾科夫干擾模式下不同算法環(huán)境獎勵的收斂值與信道數(shù)目的關(guān)系圖。

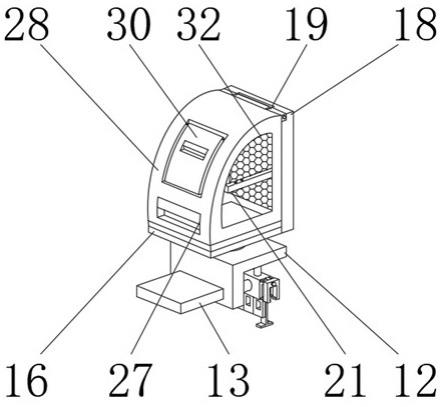

21.圖6為掃頻干擾模式下不同算法環(huán)境獎勵的收斂值與干擾機(jī)數(shù)目的關(guān)系圖。

22.圖7為馬爾科夫干擾模式下不同算法環(huán)境獎勵的收斂值與干擾機(jī)數(shù)目的關(guān)系圖。

具體實(shí)施方式

23.本發(fā)明基于部分可觀測信息的無人機(jī)集多智能體多域抗干擾方法,具體步驟為:

24.步驟1:初始化算法參數(shù);

25.步驟2:各簇頭無人機(jī)通過與環(huán)境交互獲得其簇內(nèi)成員無人機(jī)上一時隙所選擇的信道和發(fā)射功率;

26.步驟3:各簇頭無人機(jī)采用ε-greedy算法為其簇內(nèi)成員選擇當(dāng)前時隙的信道和發(fā)射功率;

27.步驟4:各簇頭無人機(jī)計算與其簇內(nèi)成員通信過程所需的能量開銷總和,并獲得對應(yīng)環(huán)境獎勵值;

28.步驟5:將各簇頭無人機(jī)當(dāng)前時隙的觀測值、動作、獎勵和下一時隙的觀測值存入各自的經(jīng)驗池中;

29.步驟6:當(dāng)經(jīng)驗池樣本數(shù)據(jù)足夠時,各簇頭無人機(jī)從各自的經(jīng)驗池中進(jìn)行隨機(jī)采樣,得到若干批歷史信息數(shù)據(jù)組成時間序列,將時間序列輸入各簇頭無人機(jī)的價值網(wǎng)絡(luò),采用梯度下降法更新價值網(wǎng)絡(luò)參數(shù);

30.步驟7:每隔一定時隙數(shù),復(fù)制價值網(wǎng)絡(luò)的參數(shù)形成新的目標(biāo)網(wǎng)絡(luò);

31.步驟8:重復(fù)步驟2至步驟7,直至完成100次數(shù)據(jù)傳輸;

32.步驟9:重復(fù)步驟8,直至無人機(jī)集網(wǎng)絡(luò)的總獎勵值收斂,完成本地訓(xùn)練。

33.進(jìn)一步地,步驟1中算法參數(shù)包括學(xué)習(xí)率δ、貪心因子ε、折扣因子γ、經(jīng)驗池大小μ、衰減因子θ、價值網(wǎng)絡(luò)參數(shù)w和目標(biāo)網(wǎng)絡(luò)參數(shù)w'。

34.進(jìn)一步地,步驟2中各簇頭無人機(jī)通過與環(huán)境交互獲得其簇內(nèi)成員無人機(jī)上一時隙所選擇的信道和發(fā)射功率,具體如下:

35.本發(fā)明中的通信環(huán)境盡可能仿照真實(shí)環(huán)境,而大部分真實(shí)環(huán)境下,由于噪聲與干擾的影響,智能體無法觀測到全部狀態(tài)信息。因此,將無人機(jī)抗干擾決策問題建模為分散式部分可觀測的馬爾科夫決策過程(decentralized partially observable markov decision process, dec-pomdp)。

36.系統(tǒng)模型建模為dec-pomdp《d,s,a,o,r》,其中d為多個智能體集合,s為聯(lián)合狀態(tài)集合,a為聯(lián)合動作集合,o為聯(lián)合觀測集合,r為獎勵函數(shù);定義d={1,

…

,n}為n 個智能體的集合;定義時隙t+1簇頭無人機(jī)n的當(dāng)前觀測為:聯(lián)合觀測集合其中是時隙t+1簇頭無人機(jī)n的簇成員i的信道,是時隙t+1 簇頭無人機(jī)n為其簇成員i選擇的發(fā)射功率;定義時隙t簇頭無人機(jī)n的動作為聯(lián)合觀測集合其中是時隙t簇頭無人機(jī)n的簇成員i跳頻到信道是時隙t簇頭無人機(jī)n為其簇成員i選擇的發(fā)射功率定義聯(lián)合狀態(tài)集合s為全部環(huán)境狀態(tài)信息,聯(lián)合觀測集合o為n個智能體能夠觀測到的部分信息,因此可以將聯(lián)合觀測集合o看作聯(lián)合狀態(tài)集合s的子集;定義是時隙t簇頭無人機(jī)n的獎勵值。

37.進(jìn)一步地,步驟3中各簇頭無人機(jī)采用ε-greedy算法為其簇內(nèi)成員選擇當(dāng)前時隙的信道和發(fā)射功率,具體如下:

38.步驟3-1:各簇頭無人機(jī)的觀測值作為其價值網(wǎng)絡(luò)的輸入,每一個動作對應(yīng)的q值作為其價值網(wǎng)絡(luò)的輸出,其中,時隙t簇頭無人機(jī)n在觀測下執(zhí)行動作的q值為時隙t+1開始的累計未來獎勵值的期望,如下:

[0039][0040]

其中,s

t

為時隙t環(huán)境狀態(tài)信息,為時隙t簇頭無人機(jī)n采取動作環(huán)境狀態(tài)s

t

由轉(zhuǎn)移到s

t+1

的概率。

[0041]

步驟3-2:根據(jù)ε-greedy算法來選擇動作,具體方式如下:

[0042][0043]

其中,p為0~1之間的隨機(jī)數(shù),ε(0<ε<1)為探索概率,為時隙t簇頭無人機(jī)n 神經(jīng)網(wǎng)絡(luò)的隱藏層狀態(tài),w為價值網(wǎng)絡(luò)參數(shù)。在此網(wǎng)絡(luò)中,輸出不僅與輸入有關(guān),還與時隙 t隱藏層狀態(tài)有關(guān),用于存儲簇頭無人機(jī)n過去的網(wǎng)絡(luò)狀態(tài),包含歷史信息。隱藏層狀態(tài)

在回合開始時為0,即不包含任何歷史信息。隨著回合進(jìn)行,將進(jìn)行迭代更新,時隙 t網(wǎng)絡(luò)產(chǎn)生的將作為時隙t+1的隱藏層狀態(tài),從而影響時隙t+1價值網(wǎng)絡(luò)的輸出,逐步迭代。

[0044]

該策略以ε的概率在動作空間中隨機(jī)選擇一個動作,避免陷入局部最優(yōu)。ε為探索概率,1-ε為利用(選擇當(dāng)前最優(yōu)策略)概率。ε的值越大,利用的概率就越小。算法執(zhí)行初始階段,由于狀態(tài)動作空間較大,探索概率應(yīng)該取較大的值,隨著迭代次數(shù)的增加,逐漸接近最優(yōu)策略,利用概率應(yīng)該隨之增加。

[0045]

進(jìn)一步地,步驟4中各簇頭無人機(jī)計算與其簇內(nèi)成員通信過程所需的能量開銷總和,并獲得對應(yīng)環(huán)境獎勵值,具體如下:

[0046]

記和分別為時隙t簇頭無人機(jī)n的簇成員i和干擾機(jī)j的發(fā)射功率,為時隙t簇頭無人機(jī)m的簇成員k的發(fā)射功率(當(dāng)m=n時,k≠i),gu和gj分別為無人機(jī)和干擾機(jī)天線增益,為時隙t簇頭無人機(jī)n與其簇成員i之間或簇頭無人機(jī)n與干擾機(jī)j之間的歐幾里得距離,ρ為無人機(jī)噪聲系數(shù),σ2環(huán)境噪聲均方值,為時隙t簇頭無人機(jī)n與其簇成員i之間或簇頭無人機(jī)n與干擾機(jī)j之間的快衰落,b為信道帶寬,t為單次通信傳輸所需時間,s為單次通信傳輸?shù)臄?shù)據(jù)大小,為加性高斯白噪聲信道中時隙t簇頭無人機(jī)n與其簇成員i無差錯傳輸?shù)淖畲笃骄畔⑺俾剩籸ician衰落信道增益用實(shí)部建模為均值為0方差為ξ2、虛部建模為均值為0方差為ξ2獨(dú)立同分布的高斯隨機(jī)過程,所以記信道快衰落為a為實(shí)部,b為虛部;設(shè)置時隙t簇頭無人機(jī)n的能量開銷為

[0047][0048][0049][0050][0051]

其中,當(dāng)簇頭無人機(jī)n的簇成員i與干擾機(jī)j在同一信道時,β=1,否則β=0;當(dāng)簇頭無人機(jī)n的簇成員i與簇頭無人機(jī)m的簇成員k在同一信道時,α=1,否則α=0。時隙t環(huán)境總獎勵值為

[0052][0053]

能量開銷的實(shí)際物理意義是簇頭無人機(jī)n與所有簇成員無人機(jī)進(jìn)行一次數(shù)據(jù)傳輸消耗的能量。

[0054]

進(jìn)一步地,步驟5中將各簇頭無人機(jī)當(dāng)前時隙的觀測值、動作、獎勵和下一時隙的

觀測值存入各自的經(jīng)驗池中,具體如下:

[0055]

當(dāng)簇頭無人機(jī)n在時隙t按照選擇簇成員無人機(jī)跳頻信道和發(fā)射功率后,環(huán)境狀態(tài)由 s

t

跳轉(zhuǎn)至s

t+1

,通過獎勵值計算公式計算在s

t

下選擇動作得到的獎勵和觀測將當(dāng)前時隙t產(chǎn)生的歷史經(jīng)驗數(shù)據(jù)保存至經(jīng)驗池中。

[0056]

進(jìn)一步地,步驟6中當(dāng)經(jīng)驗池樣本數(shù)據(jù)足夠時,各智能體從各自的經(jīng)驗池中進(jìn)行隨機(jī)采樣,得到若干批歷史信息數(shù)據(jù)組成時間序列,將時間序列輸入各智能體的價值網(wǎng)絡(luò),采用梯度下降法更新價值網(wǎng)絡(luò)參數(shù),具體如下:

[0057]

簇頭無人機(jī)n的神經(jīng)網(wǎng)絡(luò)輸入為時隙t的觀測值輸出為時隙t每個動作對應(yīng)的q值。為了增強(qiáng)算法穩(wěn)定性,本發(fā)明中采用雙網(wǎng)絡(luò)結(jié)構(gòu),記w為價值網(wǎng)絡(luò)參數(shù),w'為目標(biāo)網(wǎng)絡(luò)參數(shù),在步驟7中每間隔一定回合更新一次目標(biāo)網(wǎng)絡(luò)參數(shù)w'。

[0058]

步驟6-1:在各智能體訓(xùn)練價值網(wǎng)絡(luò)時,先從經(jīng)驗池中隨機(jī)選取一批歷史經(jīng)驗數(shù)據(jù),組成若干個時間序列,每個時間序列都是一個完整的通信回合,再在每個序列中隨機(jī)選擇一個時隙,選擇連續(xù)的若干步作為訓(xùn)練樣本。在樣本的時隙t,通過價值網(wǎng)絡(luò)計算時隙t的簇頭無人機(jī)n的動作q值函數(shù)作為估計的q值,目標(biāo)網(wǎng)絡(luò)計算時隙t+1簇頭無人機(jī)n的動作q值函數(shù)其中,為時隙t簇頭無人機(jī)n的觀測值、動作與隱藏層狀態(tài)。用如下公式計算動作q值函數(shù)的真實(shí)值:

[0059][0060]

步驟6-2:將真實(shí)的q值與估計的q值代入如下公式進(jìn)行計算,即可更新價值網(wǎng)絡(luò)參數(shù)w,逐步減小即

[0061][0062]

通過梯度下降法使得通過價值網(wǎng)絡(luò)計算出的q值更接近真實(shí)q值。在各智能體每次訓(xùn)練神經(jīng)網(wǎng)絡(luò)前,需要將隱藏層狀態(tài)置零,后續(xù)若干步的隱藏層狀態(tài)由網(wǎng)絡(luò)迭代產(chǎn)生。

[0063]

進(jìn)一步地,步驟7中每隔一定時隙數(shù),復(fù)制價值網(wǎng)絡(luò)的參數(shù)形成新的目標(biāo)網(wǎng)絡(luò),即w

←

w'。

[0064]

下面結(jié)合附圖及具體實(shí)施例對本發(fā)明做進(jìn)一步詳細(xì)說明。

[0065]

實(shí)施例

[0066]

本實(shí)施例設(shè)置簇頭無人機(jī)和干擾機(jī)完成100次移動以及信道、發(fā)射功率的選擇為一個回合,即完成一次通信任務(wù),回合中簇頭無人機(jī)及干擾機(jī)每做出一次移動、信道選擇和發(fā)射功率稱作一個時隙。

[0067]

結(jié)合圖1,本實(shí)施例基于部分可觀測信息的無人機(jī)集多智能體多域抗干擾方法,具體步驟如下:

[0068]

步驟1:初始化算法參數(shù)。

[0069]

算法參數(shù)包括學(xué)習(xí)率δ、貪心因子ε、折扣因子γ、經(jīng)驗池大小μ、衰減因子θ、價值網(wǎng)絡(luò)參數(shù)w和目標(biāo)網(wǎng)絡(luò)參數(shù)w'。

[0070]

步驟2:各簇頭無人機(jī)通過與環(huán)境交互獲得其簇內(nèi)成員無人機(jī)上一時隙所選擇的信道和發(fā)射功率。具體步驟如下:

[0071]

本發(fā)明中的通信環(huán)境盡可能仿照真實(shí)環(huán)境,而大部分真實(shí)環(huán)境下,由于噪聲與干擾的影響,智能體無法觀測到全部狀態(tài)信息。因此,將無人機(jī)抗干擾決策問題建模為分散式部分可觀測的馬爾科夫決策過程(decentralized partially observable markov decision process, dec-pomdp)。

[0072]

系統(tǒng)模型建模為dec-pomdp《d,s,a,o,r》,其中d為多個智能體集合,s為聯(lián)合狀態(tài)集合,a為聯(lián)合動作集合,o為聯(lián)合觀測集合,r為獎勵函數(shù);定義d={1,

…

,n}為n 個智能體的集合;定義時隙t+1簇頭無人機(jī)n的當(dāng)前觀測為:聯(lián)合觀測集合其中是時隙t+1簇頭無人機(jī)n的簇成員i的信道,是時隙t+1 簇頭無人機(jī)n為其簇成員i選擇的發(fā)射功率;定義時隙t簇頭無人機(jī)n的動作為聯(lián)合觀測集合其中是時隙t簇頭無人機(jī)n的簇成員i跳頻到信道是時隙t簇頭無人機(jī)n為其簇成員i選擇的發(fā)射功率定義聯(lián)合狀態(tài)集合s為全部環(huán)境狀態(tài)信息,聯(lián)合觀測集合o為n個智能體能夠觀測到的部分信息,因此可以將聯(lián)合觀測集合o看作聯(lián)合狀態(tài)集合s的子集;定義是時隙t簇頭無人機(jī)n的獎勵值。

[0073]

步驟3:各簇頭無人機(jī)采用ε-greedy算法為其簇內(nèi)成員選擇當(dāng)前時隙的信道和發(fā)射功率。具體步驟如下:

[0074]

步驟3-1:各簇頭無人機(jī)的觀測值作為其價值網(wǎng)絡(luò)的輸入,每一個動作對應(yīng)的q值作為其價值網(wǎng)絡(luò)的輸出,其中,時隙t簇頭無人機(jī)n在觀測下執(zhí)行動作的q值為時隙t+1開始的累計未來獎勵值的期望,如下:

[0075][0076]

其中,s

t

為時隙t環(huán)境狀態(tài)信息,為時隙t簇頭無人機(jī)n采取動作環(huán)境狀態(tài)s

t

由轉(zhuǎn)移到s

t+1

的概率。

[0077]

步驟3-2:根據(jù)ε-greedy算法來選擇動作,具體方式如下:

[0078][0079]

其中,p為0~1之間的隨機(jī)數(shù),ε(0<ε<1)為探索概率,為時隙t簇頭無人機(jī)n 神經(jīng)網(wǎng)絡(luò)的隱藏層狀態(tài),w為價值網(wǎng)絡(luò)參數(shù)。在此網(wǎng)絡(luò)中,輸出不僅與輸入有關(guān),還與時隙 t隱藏層狀態(tài)有關(guān),用于存儲簇頭無人機(jī)n過去的網(wǎng)絡(luò)狀態(tài),包含歷史信息。隱藏層狀態(tài)在回合開始時為0,即不包含任何歷史信息。隨著回合進(jìn)行,將進(jìn)行迭代更新,時隙 t網(wǎng)絡(luò)產(chǎn)生的將作為時隙t+1的隱藏層狀態(tài),從而影響時隙t+1價值網(wǎng)絡(luò)的輸出,逐步迭代。

[0080]

該策略以ε的概率在動作空間中隨機(jī)選擇一個動作,避免陷入局部最優(yōu)。ε為探索概率,1-ε為利用(選擇當(dāng)前最優(yōu)策略)概率。ε的值越大,利用的概率就越小。算法執(zhí)行初始階段,由于狀態(tài)動作空間較大,探索概率應(yīng)該取較大的值,隨著迭代次數(shù)的增加,逐漸接近最優(yōu)策略,利用概率應(yīng)該隨之增加。概率ε更新方式如下:

[0081]

ε=max{0.01,θ

x

}

[0082]

其中x為當(dāng)前進(jìn)行的回合數(shù)。

[0083]

步驟4:各簇頭無人機(jī)計算與其簇內(nèi)成員通信過程所需的能量開銷總和,并獲得對應(yīng)環(huán)境獎勵值。具體步驟如下:

[0084]

記和分別為時隙t簇頭無人機(jī)n的簇成員i和干擾機(jī)j的發(fā)射功率,為時隙t簇頭無人機(jī)m的簇成員k的發(fā)射功率(當(dāng)m=n時,k≠i),gu和gj分別為無人機(jī)和干擾機(jī)天線增益,為時隙t簇頭無人機(jī)n與其簇成員i之間或簇頭無人機(jī)n與干擾機(jī)j之間的歐幾里得距離,ρ為無人機(jī)噪聲系數(shù),σ2環(huán)境噪聲均方值,為時隙t簇頭無人機(jī)n與其簇成員i之間或簇頭無人機(jī)n與干擾機(jī)j之間的快衰落,b為信道帶寬,t為單次通信傳輸所需時間,s為單次通信傳輸?shù)臄?shù)據(jù)大小,為加性高斯白噪聲信道中時隙t簇頭無人機(jī)n與其簇成員i無差錯傳輸?shù)淖畲笃骄畔⑺俾剩籸ician衰落信道增益用實(shí)部建模為均值為0方差為ξ2、虛部建模為均值為0方差為ξ2獨(dú)立同分布的高斯隨機(jī)過程,所以記信道快衰落為a為實(shí)部,b為虛部;設(shè)置時隙t簇頭無人機(jī)n的能量開銷為

[0085][0086][0087][0088][0089]

其中,當(dāng)簇頭無人機(jī)n的簇成員i與干擾機(jī)j在同一信道時,β=1,否則β=0;當(dāng)簇頭無人機(jī)n的簇成員i與簇頭無人機(jī)m的簇成員k在同一信道時,α=1,否則α=0。時隙t環(huán)境總獎勵值為

[0090][0091]

能量開銷的實(shí)際物理意義是簇頭無人機(jī)n與所有簇成員無人機(jī)進(jìn)行一次數(shù)據(jù)傳輸消耗的能量。

[0092]

步驟5:將各簇頭無人機(jī)當(dāng)前時隙的觀測值、動作、獎勵和下一時隙的觀測值存入各自的經(jīng)驗池中。具體步驟如下:

[0093]

當(dāng)簇頭無人機(jī)n在時隙t按照選擇簇成員無人機(jī)跳頻信道和發(fā)射功率后,環(huán)境狀態(tài)由s

t

跳轉(zhuǎn)至s

t+1

,通過獎勵值計算公式計算在s

t

下選擇動作得到的獎勵和觀測將當(dāng)前時隙t產(chǎn)生的歷史經(jīng)驗數(shù)據(jù)保存至經(jīng)驗池中。

[0094]

步驟6:當(dāng)經(jīng)驗池樣本數(shù)據(jù)足夠時,各智能體從各自的經(jīng)驗池中進(jìn)行隨機(jī)采樣,得

到若干批歷史信息數(shù)據(jù)組成時間序列,將時間序列輸入各智能體的價值網(wǎng)絡(luò),采用梯度下降法更新價值網(wǎng)絡(luò)參數(shù)。具體步驟如下:

[0095]

簇頭無人機(jī)n的神經(jīng)網(wǎng)絡(luò)由3個神經(jīng)單元組成,第一個神經(jīng)單元為長短期記憶單元(longshort-term memory,lstm)。lstm結(jié)構(gòu)是一種特殊的循環(huán)神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),可以利用歷史信息對序列數(shù)據(jù)進(jìn)行預(yù)測和處理。lstm由遺忘門、輸入門、輸出門組成,遺忘門中的控制參數(shù)決定需要被丟棄的歷史信息,輸入門決定被加入的新信息,輸出門決定從本lstm單元輸出到下一個單元的數(shù)據(jù)。

[0096]

遺忘門:

[0097][0098]

輸入門:

[0099][0100][0101][0102]

輸出門:

[0103][0104]

其中,w

i,f,c,o

和b

i,f,c,o

門的輸入權(quán)重和偏置,為時隙t lstm單元的輸入。

[0105]

lstm結(jié)構(gòu)使用三個門來對輸入的數(shù)據(jù)序列決定保留程度,可以實(shí)現(xiàn)通過歷史信息對未來進(jìn)行預(yù)測。本發(fā)明的抗干擾場景中,各智能體只有獎勵信息的交換,所以無法確定其他智能體的動作信息。lstm結(jié)構(gòu)利用歷史信息的經(jīng)驗來幫助各智能體預(yù)估其他智能體的動作,可以獲得更好的無人機(jī)集網(wǎng)絡(luò)通信抗干擾策略。

[0106]

簇頭無人機(jī)n的神經(jīng)網(wǎng)絡(luò)輸入為時隙t的觀測值輸出為時隙t每個動作對應(yīng)的q值。為了增強(qiáng)算法穩(wěn)定性,本發(fā)明中采用雙網(wǎng)絡(luò)結(jié)構(gòu),記w為價值網(wǎng)絡(luò)參數(shù),w'為目標(biāo)網(wǎng)絡(luò)參數(shù),在步驟7中每間隔一定回合更新一次目標(biāo)網(wǎng)絡(luò)參數(shù)w'。

[0107]

步驟6-1:在各智能體訓(xùn)練價值網(wǎng)絡(luò)時,先從經(jīng)驗池中隨機(jī)選取一批歷史經(jīng)驗數(shù)據(jù),組成若干個時間序列,每個時間序列都是一個完整的通信回合,再在每個序列中隨機(jī)選擇一個時隙,選擇連續(xù)的若干步作為訓(xùn)練樣本。在樣本的時隙t,通過價值網(wǎng)絡(luò)計算時隙t的簇頭無人機(jī)n的動作q值函數(shù)作為估計的q值,目標(biāo)網(wǎng)絡(luò)計算時隙t+1簇頭無人機(jī)n的動作q值函數(shù)其中,為時隙t簇頭無人機(jī)n的觀測值、動作與隱藏層狀態(tài)。用如下公式計算動作q值函數(shù)的真實(shí)值:

[0108][0109]

步驟6-2:將真實(shí)的q值與估計的q值代入如下公式進(jìn)行計算,即可更新價值網(wǎng)絡(luò)參數(shù)w,逐步減小即

[0110][0111]

通過梯度下降法使得通過價值網(wǎng)絡(luò)計算出的q值更接近真實(shí)q值。在各智能體每次訓(xùn)練神經(jīng)網(wǎng)絡(luò)前,需要將隱藏層狀態(tài)置零,后續(xù)若干步的隱藏層狀態(tài)由網(wǎng)絡(luò)迭代產(chǎn)生。

[0112]

梯度下降過程采用自適應(yīng)矩估計(adaptive moment estimation,adam)方式。價值網(wǎng)絡(luò)參數(shù)更新過程中,每次迭代只采樣一批歷史經(jīng)驗數(shù)據(jù)進(jìn)行訓(xùn)練,數(shù)據(jù)集不同,則損失函數(shù)不同,采用adam方式能降低收斂到局部最優(yōu)的概率。adam根據(jù)損失函數(shù)對每個參數(shù)的梯度的一階矩估計和二階矩估計動態(tài)調(diào)整針對于每個參數(shù)的學(xué)習(xí)速率。adam基于梯度下降方法,但每次迭代參數(shù)的學(xué)習(xí)步長都有一個確定的范圍,不會因為較大的梯度導(dǎo)致較大的學(xué)習(xí)步長,參數(shù)的值比較穩(wěn)定。adam算法實(shí)現(xiàn)步驟具體如下:

[0113]

假設(shè)時隙t時,目標(biāo)函數(shù)對于參數(shù)的一階導(dǎo)數(shù)是g

t

,首先計算指數(shù)移動均值:

[0114]mt

=λ1m

t-1

+(1-λ1)g

t-1

[0115]

再計算兩個偏差校正項:

[0116][0117][0118]

最后得到的梯度更新方法為:

[0119][0120]

最終返回誤差函數(shù)相關(guān)的結(jié)果參數(shù)算法中m

t

為指數(shù)移動均值,ω

t

為平方梯度,而參數(shù)λ1、λ2為控制這些移動均值的指數(shù)衰減率,η為學(xué)習(xí)步長,τ為常數(shù),一般為10-8

。

[0121]

步驟7:每隔一定時隙數(shù),復(fù)制價值網(wǎng)絡(luò)的參數(shù)形成新的目標(biāo)網(wǎng)絡(luò);

[0122]

步驟8:重復(fù)步驟2至步驟7,直至完成100次數(shù)據(jù)傳輸;

[0123]

步驟9:重復(fù)步驟8,直至無人機(jī)集網(wǎng)絡(luò)的總獎勵值收斂,完成本地訓(xùn)練。

[0124]

本發(fā)明采用python對所述方法進(jìn)行實(shí)施。設(shè)置信道總數(shù)c=4,無人機(jī)數(shù)量n=9,干擾機(jī)數(shù)量j=1,時隙t簇頭無人機(jī)n為其簇成員i選擇的發(fā)射功率和干擾機(jī)j選擇的發(fā)射功率分別為(簇成員無人機(jī)i的發(fā)射功率可為27、30、33、36dbm,干擾機(jī)j的發(fā)射功率通常取值33dbm),設(shè)計無人機(jī)集完成一次通信任務(wù)需要簇頭無人機(jī)n與簇成員無人機(jī)i完成 q次通信,對兩種不同干擾模式下的抗干擾系統(tǒng)進(jìn)行仿真。取學(xué)習(xí)率δ=0.002,折扣因子γ=0.99,衰減因子θ=0.998,經(jīng)驗池大小μ=200,環(huán)境噪聲均方值σ2=-114dbm;rician 衰落信道增益用實(shí)部建模為均值為ξ2、虛部建模為均值為0方差為ξ2獨(dú)立同分布的高斯隨機(jī)過程,所以記信道快衰落為a為實(shí)部,b為虛部。

[0125]

在掃頻及馬爾科夫干擾模式下的學(xué)習(xí)收斂效果分別如圖2~圖3所示。掃頻設(shè)置為同時干擾1個頻道,以1mhz為掃頻步長。馬爾科夫干擾模式下設(shè)置干擾狀態(tài)共計4個,每個干擾模式在仿真開始時隨機(jī)生成,任意時隙干擾模式的轉(zhuǎn)換遵循如下狀態(tài)轉(zhuǎn)移矩陣:

[0126]

[0127]

圖2與圖3分別為掃頻干擾與馬爾科夫干擾兩種干擾模式下,信道與功率隨機(jī)選擇方案、基于dqn以及基于drqn的信道與功率選擇方案中獎勵值的收斂情況。從圖中可以看出,基于drqn方案相比dqn方案具有更高的收斂獎勵值,且收斂結(jié)果更穩(wěn)定,這是由于drqn 中存在長短期記憶網(wǎng)絡(luò),各智能體可以根據(jù)歷史經(jīng)驗獲得其他智能體的動作變化規(guī)律以及環(huán)境變化規(guī)律等隱藏信息,網(wǎng)絡(luò)輸出不只由自身觀測情況所決定;而dqn的輸出完全由自身的觀測情況決定,一旦環(huán)境或其他智能體決策規(guī)律發(fā)生改變,將會造成整個網(wǎng)絡(luò)的波動。對比圖2與圖3,三種信道與功率選擇的方案獎勵值收斂情況大致相同,在馬爾可夫干擾條件下,基于drqn方案相比基于dqn方案性能提升34.6%,相比基于隨機(jī)方案提升54.5%;在掃頻干擾條件下,基于drqn方案相比基于dqn方案性能提升38.4%,相比基于隨機(jī)方案提升56%。

[0128]

圖4與圖5分別為掃頻干擾與馬爾科夫干擾兩種干擾模式下,三種信道與功率選擇方案的平均獎勵收斂值與信道數(shù)目的關(guān)系。當(dāng)信道數(shù)目增多時,三種方案的平均獎勵收斂值均有所提高,這是由于信道數(shù)目增多后,同頻干擾發(fā)生的情況減少,降低了無人機(jī)通信的能量開銷。基于drqn的方案相比其他方案平均獎勵收斂值變化較小,說明其對這一環(huán)境條件并不敏感。

[0129]

圖6與圖7分別為掃頻干擾與馬爾科夫干擾兩種干擾模式下,三種信道與功率選擇方案的獎勵收斂值與干擾機(jī)數(shù)目的關(guān)系。從圖中可以看出,在兩種干擾模式下,隨著干擾機(jī)數(shù)目的增多,環(huán)境不斷惡化,三種方案下的平均獎勵收斂值都有下降趨勢,但是基于drqn方案的平均獎勵收斂值更穩(wěn)定,下降幅度不超過10%,因此drqn算法具有較好的穩(wěn)健性。

技術(shù)特征:

1.基于部分可觀測信息的無人機(jī)集多智能體多域抗干擾方法,其特征體現(xiàn)在下列具體的步驟中:步驟1:初始化算法參數(shù);步驟2:各簇頭無人機(jī)通過與環(huán)境交互獲得其簇內(nèi)成員無人機(jī)上一時隙所選擇的信道和發(fā)射功率;步驟3:各簇頭無人機(jī)采用ε-greedy算法為其簇內(nèi)成員選擇當(dāng)前時隙的信道和發(fā)射功率;步驟4:各簇頭無人機(jī)計算與其簇內(nèi)成員通信過程所需的能量開銷總和,并獲得對應(yīng)環(huán)境獎勵值;步驟5:將各簇頭無人機(jī)當(dāng)前時隙的觀測值、動作、獎勵和下一時隙的觀測值存入各自的經(jīng)驗池中;步驟6:當(dāng)經(jīng)驗池樣本數(shù)據(jù)足夠時,各簇頭無人機(jī)從各自的經(jīng)驗池中進(jìn)行隨機(jī)采樣,得到若干批歷史信息數(shù)據(jù)組成時間序列,將時間序列輸入各簇頭無人機(jī)的價值網(wǎng)絡(luò),采用梯度下降法更新價值網(wǎng)絡(luò)參數(shù);步驟7:每隔一定時隙數(shù),復(fù)制價值網(wǎng)絡(luò)的參數(shù)形成新的目標(biāo)網(wǎng)絡(luò);步驟8:重復(fù)步驟2至步驟7,直至完成100次數(shù)據(jù)傳輸;步驟9:重復(fù)步驟8,直至無人機(jī)集網(wǎng)絡(luò)的總獎勵值收斂,完成本地訓(xùn)練。2.根據(jù)權(quán)利要求1所述的基于部分可觀測信息的無人機(jī)集多智能體多域抗干擾方法,其特征在于,步驟1中算法參數(shù)包括學(xué)習(xí)率δ、貪心因子ε、折扣因子γ、經(jīng)驗池大小μ、衰減因子θ、價值網(wǎng)絡(luò)參數(shù)w和目標(biāo)網(wǎng)絡(luò)參數(shù)w'。3.根據(jù)權(quán)利要求1所述的基于部分可觀測信息的無人機(jī)集多智能體多域抗干擾方法,其特征在于,步驟2中各簇頭無人機(jī)通過與環(huán)境交互獲得其簇內(nèi)成員無人機(jī)上一時隙所選擇的信道和發(fā)射功率,具體如下:本發(fā)明中的通信環(huán)境盡可能仿照真實(shí)環(huán)境,而大部分真實(shí)環(huán)境下,由于噪聲與干擾的影響,智能體無法觀測到全部狀態(tài)信息。因此,將無人機(jī)抗干擾決策問題建模為分散式部分可觀測的馬爾科夫決策過程(decentralized partially observable markov decision process,dec-pomdp)。系統(tǒng)模型建模為dec-pomdp<d,s,a,o,r>,其中d為多個智能體集合,s為聯(lián)合狀態(tài)集合,a為聯(lián)合動作集合,o為聯(lián)合觀測集合,r為獎勵函數(shù);定義d={1,

…

,n}為n個智能體的集合;定義時隙t+1簇頭無人機(jī)n的當(dāng)前觀測為:聯(lián)合觀測集合其中是時隙t+1簇頭無人機(jī)n的簇成員i的信道,是時隙t+1簇頭無人機(jī)n為其簇成員i選擇的發(fā)射功率;定義時隙t簇頭無人機(jī)n的動作為聯(lián)合觀測集合其中是時隙t簇頭無人機(jī)n的簇成員i跳頻到信道是時隙t簇頭無人機(jī)n為其簇成員i選擇的發(fā)射功率定義聯(lián)合狀態(tài)集合s為全部環(huán)境狀態(tài)信息,聯(lián)合觀測集合o為n個智能體能夠觀測到的部分信息,因此可以將聯(lián)合觀測集合o看作聯(lián)合狀態(tài)集合s的子集;定義是時隙t簇頭無人機(jī)n的獎勵值。4.根據(jù)權(quán)利要求1所述的基于部分可觀測信息的無人機(jī)集多智能體多域抗干擾方

法,其特征在于,步驟3中各簇頭無人機(jī)采用ε-greedy算法為其簇內(nèi)成員選擇當(dāng)前時隙的信道和發(fā)射功率,具體如下:步驟3-1:各簇頭無人機(jī)的觀測值作為其價值網(wǎng)絡(luò)的輸入,每一個動作對應(yīng)的q值作為其價值網(wǎng)絡(luò)的輸出,其中,時隙t簇頭無人機(jī)n在觀測下執(zhí)行動作的q值為時隙t+1開始的累計未來獎勵值的期望,如下:其中,s

t

為時隙t環(huán)境狀態(tài)信息,為時隙t簇頭無人機(jī)n采取動作環(huán)境狀態(tài)s

t

由轉(zhuǎn)移到s

t+1

的概率。步驟3-2:根據(jù)ε-greedy算法來選擇動作,具體方式如下:其中,p為0~1之間的隨機(jī)數(shù),ε(0<ε<1)為探索概率,為時隙t簇頭無人機(jī)n神經(jīng)網(wǎng)絡(luò)的隱藏層狀態(tài),w為價值網(wǎng)絡(luò)參數(shù)。在此網(wǎng)絡(luò)中,輸出不僅與輸入有關(guān),還與時隙t隱藏層狀態(tài)有關(guān),用于存儲簇頭無人機(jī)n過去的網(wǎng)絡(luò)狀態(tài),包含歷史信息。隱藏層狀態(tài)在回合開始時為0,即不包含任何歷史信息。隨著回合進(jìn)行,將進(jìn)行迭代更新,時隙t網(wǎng)絡(luò)產(chǎn)生的將作為時隙t+1的隱藏層狀態(tài),從而影響時隙t+1價值網(wǎng)絡(luò)的輸出,逐步迭代。該策略以ε的概率在動作空間中隨機(jī)選擇一個動作,避免陷入局部最優(yōu)。ε為探索概率,1-ε為利用(選擇當(dāng)前最優(yōu)策略)概率。ε的值越大,利用的概率就越小。算法執(zhí)行初始階段,由于狀態(tài)動作空間較大,探索概率應(yīng)該取較大的值,隨著迭代次數(shù)的增加,逐漸接近最優(yōu)策略,利用概率應(yīng)該隨之增加。5.根據(jù)權(quán)利要求1所述的基于部分可觀測信息的無人機(jī)集多智能體多域抗干擾方法,其特征在于,步驟4中各簇頭無人機(jī)計算與其簇內(nèi)成員通信過程所需的能量開銷總和,并獲得對應(yīng)環(huán)境獎勵值,具體如下:記和分別為時隙t簇頭無人機(jī)n的簇成員i和干擾機(jī)j的發(fā)射功率,為時隙t簇頭無人機(jī)m的簇成員k的發(fā)射功率(當(dāng)m=n時,k≠i),g

u

和g

j

分別為無人機(jī)和干擾機(jī)天線增益,為時隙t簇頭無人機(jī)n與其簇成員i之間或簇頭無人機(jī)n與干擾機(jī)j之間的歐幾里得距離,ρ為無人機(jī)噪聲系數(shù),σ2環(huán)境噪聲均方值,為時隙t簇頭無人機(jī)n與其簇成員i之間或簇頭無人機(jī)n與干擾機(jī)j之間的快衰落,b為信道帶寬,t為單次通信傳輸所需時間,s為單次通信傳輸?shù)臄?shù)據(jù)大小,為加性高斯白噪聲信道中時隙t簇頭無人機(jī)n與其簇成員i無差錯傳輸?shù)淖畲笃骄畔⑺俾剩籸ician衰落信道增益用實(shí)部建模為均值為0方差為ξ2、虛部建模為均值為0方差為ξ2獨(dú)立同分布的高斯隨機(jī)過程,所以記信道快衰落為a為實(shí)部,b為虛部;設(shè)置時隙t簇頭無人機(jī)n的能量開銷為

其中,當(dāng)簇頭無人機(jī)n的簇成員i與干擾機(jī)j在同一信道時,β=1,否則β=0;當(dāng)簇頭無人機(jī)n的簇成員i與簇頭無人機(jī)m的簇成員k在同一信道時,α=1,否則α=0。時隙t環(huán)境總獎勵值為能量開銷的實(shí)際物理意義是簇頭無人機(jī)n與所有簇成員無人機(jī)進(jìn)行一次數(shù)據(jù)傳輸消耗的能量。6.根據(jù)權(quán)利要求1所述的基于部分可觀測信息的無人機(jī)集多智能體多域抗干擾方法,其特征在于,步驟5中將各簇頭無人機(jī)當(dāng)前時隙的觀測值、動作、獎勵和下一時隙的觀測值存入各自的經(jīng)驗池中,具體如下:當(dāng)簇頭無人機(jī)n在時隙t按照選擇簇成員無人機(jī)跳頻信道和發(fā)射功率后,環(huán)境狀態(tài)由s

t

跳轉(zhuǎn)至s

t+1

,通過獎勵值計算公式計算在s

t

下選擇動作得到的獎勵和觀測將當(dāng)前時隙t產(chǎn)生的歷史經(jīng)驗數(shù)據(jù)保存至經(jīng)驗池中。7.根據(jù)權(quán)利要求1所述的基于部分可觀測信息的無人機(jī)集多智能體多域抗干擾方法,其特征在于,步驟6中當(dāng)經(jīng)驗池樣本數(shù)據(jù)足夠時,各智能體從各自的經(jīng)驗池中進(jìn)行隨機(jī)采樣,得到若干批歷史信息數(shù)據(jù)組成時間序列,將時間序列輸入各智能體的價值網(wǎng)絡(luò),采用梯度下降法更新價值網(wǎng)絡(luò)參數(shù),具體如下:簇頭無人機(jī)n的神經(jīng)網(wǎng)絡(luò)輸入為時隙t的觀測值輸出為時隙t每個動作對應(yīng)的q值。為了增強(qiáng)算法穩(wěn)定性,本發(fā)明中采用雙網(wǎng)絡(luò)結(jié)構(gòu),記w為價值網(wǎng)絡(luò)參數(shù),w'為目標(biāo)網(wǎng)絡(luò)參數(shù),在步驟7中每間隔一定回合更新一次目標(biāo)網(wǎng)絡(luò)參數(shù)w'。步驟6-1:在各智能體訓(xùn)練價值網(wǎng)絡(luò)時,先從經(jīng)驗池中隨機(jī)選取一批歷史經(jīng)驗數(shù)據(jù),組成若干個時間序列,每個時間序列都是一個完整的通信回合,再在每個序列中隨機(jī)選擇一個時隙,選擇連續(xù)的若干步作為訓(xùn)練樣本。在樣本的時隙t,通過價值網(wǎng)絡(luò)計算時隙t的簇頭無人機(jī)n的動作q值函數(shù)作為估計的q值,目標(biāo)網(wǎng)絡(luò)計算時隙t+1簇頭無人機(jī)n的動作q值函數(shù)其中,為時隙t簇頭無人機(jī)n的觀測值、動作與隱藏層狀態(tài)。用如下公式計算動作q值函數(shù)的真實(shí)值:

步驟6-2:將真實(shí)的q值與估計的q值代入如下公式進(jìn)行計算,即可更新價值網(wǎng)絡(luò)參數(shù)w,逐步減小即通過梯度下降法使得通過價值網(wǎng)絡(luò)計算出的q值更接近真實(shí)q值。在各智能體每次訓(xùn)練神經(jīng)網(wǎng)絡(luò)前,需要將隱藏層狀態(tài)置零,后續(xù)若干步的隱藏層狀態(tài)由網(wǎng)絡(luò)迭代產(chǎn)生。8.根據(jù)權(quán)利要求1所述的基于部分可觀測信息的無人機(jī)集多智能體多域抗干擾方法,其特征在于,步驟7中每隔一定時隙數(shù),復(fù)制價值網(wǎng)絡(luò)的參數(shù)形成新的目標(biāo)網(wǎng)絡(luò),即w

←

w'。

技術(shù)總結(jié)

本發(fā)明公開了一種基于部分可觀測信息的無人機(jī)集多智能體多域抗干擾方法,該方法利用各智能體的部分觀測環(huán)境信息,通過長短期記憶網(wǎng)絡(luò)保留歷史經(jīng)驗數(shù)據(jù),輸入各智能體的深度循環(huán)Q網(wǎng)絡(luò)進(jìn)行動作值函數(shù)擬合,采用ε-greedy算法選擇最大輸出Q值對應(yīng)的信道和功率,再經(jīng)過不斷獨(dú)立訓(xùn)練各智能體的深度循環(huán)Q網(wǎng)絡(luò),更新Q值分布,最終學(xué)習(xí)到可適應(yīng)未知干擾場景下實(shí)現(xiàn)通信傳輸能耗最小化的無人機(jī)信道和發(fā)射功率最優(yōu)決策。本發(fā)明針對無人機(jī)集網(wǎng)絡(luò)分別處于掃頻干擾和馬爾科夫干擾兩種場景下,利用部分可觀測信息的歷史經(jīng)驗數(shù)據(jù),從頻譜域和功率域?qū)崿F(xiàn)有效多智能體抗干擾通信;相較于基于多智能體深度Q學(xué)習(xí)的對比方案,所提方案能夠在環(huán)境信息部分可觀測的情況下更高效地降低無人機(jī)集網(wǎng)絡(luò)的長期通信傳輸能耗。無人機(jī)集網(wǎng)絡(luò)的長期通信傳輸能耗。無人機(jī)集網(wǎng)絡(luò)的長期通信傳輸能耗。