面向智奪旗博弈的深度強化學習方法和系統

1.本發明涉及智奪旗博弈策略端到端求解方法和系統,具體涉及多智能體深度強化學習路徑規劃與圖注意力網絡量化博弈競合關系。

背景技術:

2.博弈是參與者在合作或競爭行為下的策略優化過程。將博弈論引入多智能體系統時,憑借傳感器模塊、智能穿戴設備等基本感知單元的廣泛使用,通過互聯網協同,實現了多智能體系統中的數據高效收集和任務協同規劃,使得完成復雜戰場環境下的智攻防任務成為可能。在此背景下,通過構建并求解博弈模型,提升強對抗、高動態戰場環境下智能體精準攻擊與防御的成功率。

3.攻防博弈問題可被建模為奪旗博弈模型,其中攻擊方實現對防守方目標的奪取,而防守方則試圖摧毀攻擊方以阻止襲擊。當博弈是低維時,現有文獻(例如,huang h,ding j,zhang w,et al.automation-assisted capture-the-flag:a differential game approach.ieee trans control syst technol,2014,23:1014-1028)往往嘗試構建微分博弈模型,以解析的形式求解1對1奪旗博弈的最優策略。然而將奪旗博弈推廣到復雜戰場環境中多對多博弈的情況時,由于智能體的最優策略往往取決于其他智能體的動作選擇,因而造成偏微分方程維數爆炸等問題,導致目前無法解析求解智奪旗博弈的最優策略。

4.卷積神經網絡可以提取輸入圖像的特征,然而僅從智能體每一步狀態的角度分析,無法定量判斷下一時刻智能體的決策偏向于合作或競爭,從而影響最終多智能體奪旗博弈策略的制定。

5.深度強化學習算法可以解決戰場環境圖像輸入下存在大量障礙物空間中的路徑規劃問題,然而針對多智能體系統,特別是存在競合關系的多智能體,不同合作智能體與競爭智能體擁有不同的獎勵函數,從而無法使用同一深度強化學習網絡進行策略搜索。

技術實現要素:

6.以下給出一個或多個方面的簡要概述以提供對這些方面的基本理解。此概述不是所有構想到的方面的詳盡綜覽,并且既非旨在指認出所有方面的關鍵性或決定性要素亦非試圖界定任何或所有方面的范圍。其唯一的目的是要以簡化形式給出一個或多個方面的一些概念以為稍后給出的更加詳細的描述之序。

7.本發明的目的在于解決上述問題,提供了一種面向智奪旗博弈的深度強化學習方法和系統,解決了強對抗、高動態戰場環境下克服不完美觀測信息,實現智高效攻防奪旗的問題。

8.本發明的技術方案為:本發明揭示了一種面向智奪旗博弈的深度強化學習方法,方法包括:

9.步驟1:將復雜戰場環境抽象為包括多個智能體在內的二維迷宮仿真環境;

10.步驟2:基于卷積神經網絡分通道提取輸入圖像的視覺特征;

11.步驟3:使用強化學習雙重決斗深度q網絡分別為分隊的智能體初始化對應的網絡;

12.步驟4:根據智奪旗任務目標構造獎勵函數,根據由戰場環境抽象出的奪旗規則,設置需要達到的目標;

13.步驟5:在雙重決斗深度q網絡結構中加入圖注意力網絡;

14.步驟6:設置最大迭代輪次;

15.步驟7:根據智能體在該時刻的觀測信息和與隊友間的通訊信息,計算每一步各智能體間的注意力值,智能體根據注意力值選擇偏向進攻/防守的動作;

16.步驟8:根據選取的獎勵函數執行動作,獲取經驗回放四元組;

17.步驟9:獲取新的環境部分觀測,更新經驗回放四元組,計算雙重決斗深度q網絡目標值;

18.步驟10:反復執行步驟7-9,更新雙重決斗深度q網絡,直至迭代次數達到最大迭代次數,實現迷宮環境下的智奪旗博弈。

19.根據本發明的面向智奪旗博弈的深度強化學習方法的一實施例,步驟1進一步包括:

20.定義n個智能體,其中包含一組局部觀測一組動作和一組狀態s和狀態轉移函數對于每個智能體i,通過基本感知單元得到的局部觀測

21.根據本發明的面向智奪旗博弈的深度強化學習方法的一實施例,步驟2進一步包括:

22.在卷積神經網絡后增加殘差網絡模塊,將前后連接的卷積神經網絡和殘差網絡模塊的特征連接在一起,用于減少過擬合。

23.根據本發明的面向智奪旗博弈的深度強化學習方法的一實施例,步驟4進一步包括:

24.需要達到的目標為:我方智能體在不被敵方智能體擊殺的條件下,奪取敵方的旗幟。

25.本發明還揭示了一種面向智奪旗博弈的深度強化學習系統,系統包括:

26.仿真模塊,配置為將復雜戰場環境抽象為包括多個智能體在內的二維迷宮仿真環境;

27.特征提取模塊,配置為基于卷積神經網絡分通道提取輸入圖像的視覺特征;

28.初始化模塊,配置為使用強化學習雙重決斗深度q網絡分別為分隊的智能體初始化對應的網絡;

29.獎勵函數構造模塊,配置為根據智奪旗任務目標構造獎勵函數,根據由戰場環境抽象出的奪旗規則,設置需要達到的目標;

30.圖注意力網絡模塊,配置為在雙重決斗深度q網絡結構中加入圖注意力網絡;

31.最大迭代輪次設置模塊,配置為設置最大迭代輪次;

32.注意力值計算模塊,配置為根據智能體在該時刻的觀測信息和與隊友間的通訊信息,計算每一步各智能體間的注意力值,智能體根據注意力值選擇偏向進攻/防守的動作;

33.經驗回放四元組獲取模塊,配置為根據選取的獎勵函數執行動作,獲取經驗回放四元組;

34.網絡目標值計算模塊,配置為獲取新的環境部分觀測,更新經驗回放四元組,計算雙重決斗深度q網絡目標值;

35.反復執行注意力值計算模塊、經驗回放四元組獲取模塊和網絡目標值計算模塊,更新雙重決斗深度q網絡,直至迭代次數達到最大迭代次數,實現迷宮環境下的智奪旗博弈。

36.根據本發明的面向智奪旗博弈的深度強化學習系統的一實施例,仿真模塊進一步配置為:

37.定義n個智能體,其中包含一組局部觀測一組動作和一組狀態s和狀態轉移函數對于每個智能體i,通過基本感知單元得到的局部觀測

38.根據本發明的面向智奪旗博弈的深度強化學習系統的一實施例,特征提取模塊進一步配置為:

39.在卷積神經網絡后增加殘差網絡模塊,將前后連接的卷積神經網絡和殘差網絡模塊的特征連接在一起,用于減少過擬合。

40.根據本發明的面向智奪旗博弈的深度強化學習系統的一實施例,獎勵函數構造模塊進一步配置為:

41.需要達到的目標為:我方智能體在不被敵方智能體擊殺的條件下,奪取敵方的旗幟。

42.本發明對比現有技術有如下的有益效果:第一,本發明采用雙重決斗深度q網絡算法分別訓練多智能體,解決了復雜迷宮環境中路徑規劃存在網絡偏差的問題,確保智能體無論是否轉移狀態,都能夠獲得顯著的獎勵,從而實現了更準確的狀態估計并提升了訓練效率。第二,本發明采用圖注意力網絡關注奪旗博弈過程中最相關的智能體,實時量化智能體間相互關系,輔助雙重決斗深度q網絡算法進行決策,高效優化了多智能體奪旗策略。第三,本發明針對外部競爭、內部合作的多智能體端到端地訓練路徑規劃與自主導航策略,實現二維迷宮環境中不完美信息條件下多智能體的奪旗博弈。

附圖說明

43.在結合以下附圖閱讀本公開的實施例的詳細描述之后,能夠更好地理解本發明的上述特征和優點。在附圖中,各組件不一定是按比例繪制,并且具有類似的相關特性或特征的組件可能具有相同或相近的附圖標記。

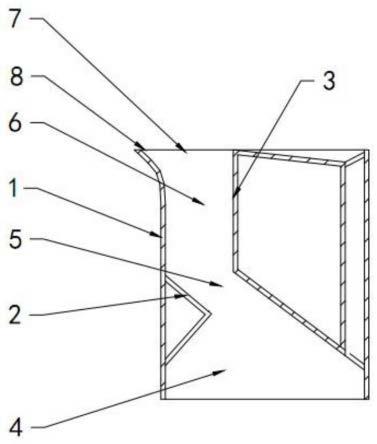

44.圖1為智能體部分可觀的奪旗博弈迷宮環境示意圖。

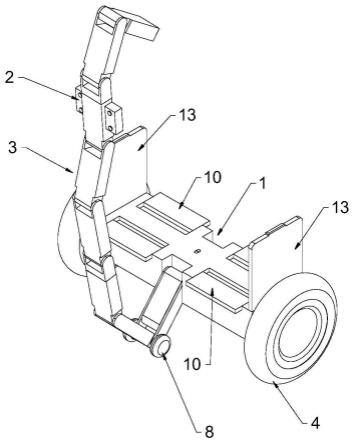

45.圖2為本發明的面向智奪旗博弈的深度強化學習方法的一實施例所涉及的整體網絡框架。

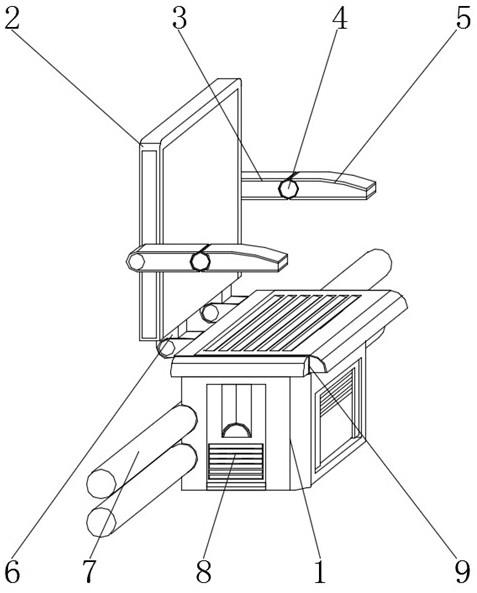

46.圖3為奪旗博弈過程中注意力值變化曲線圖。

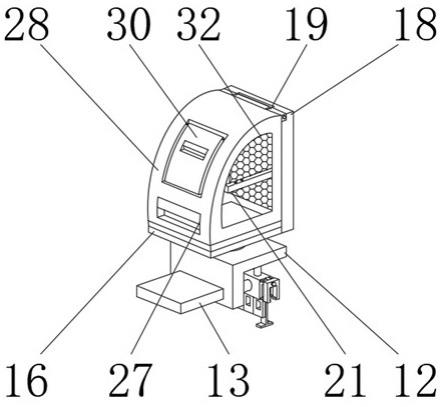

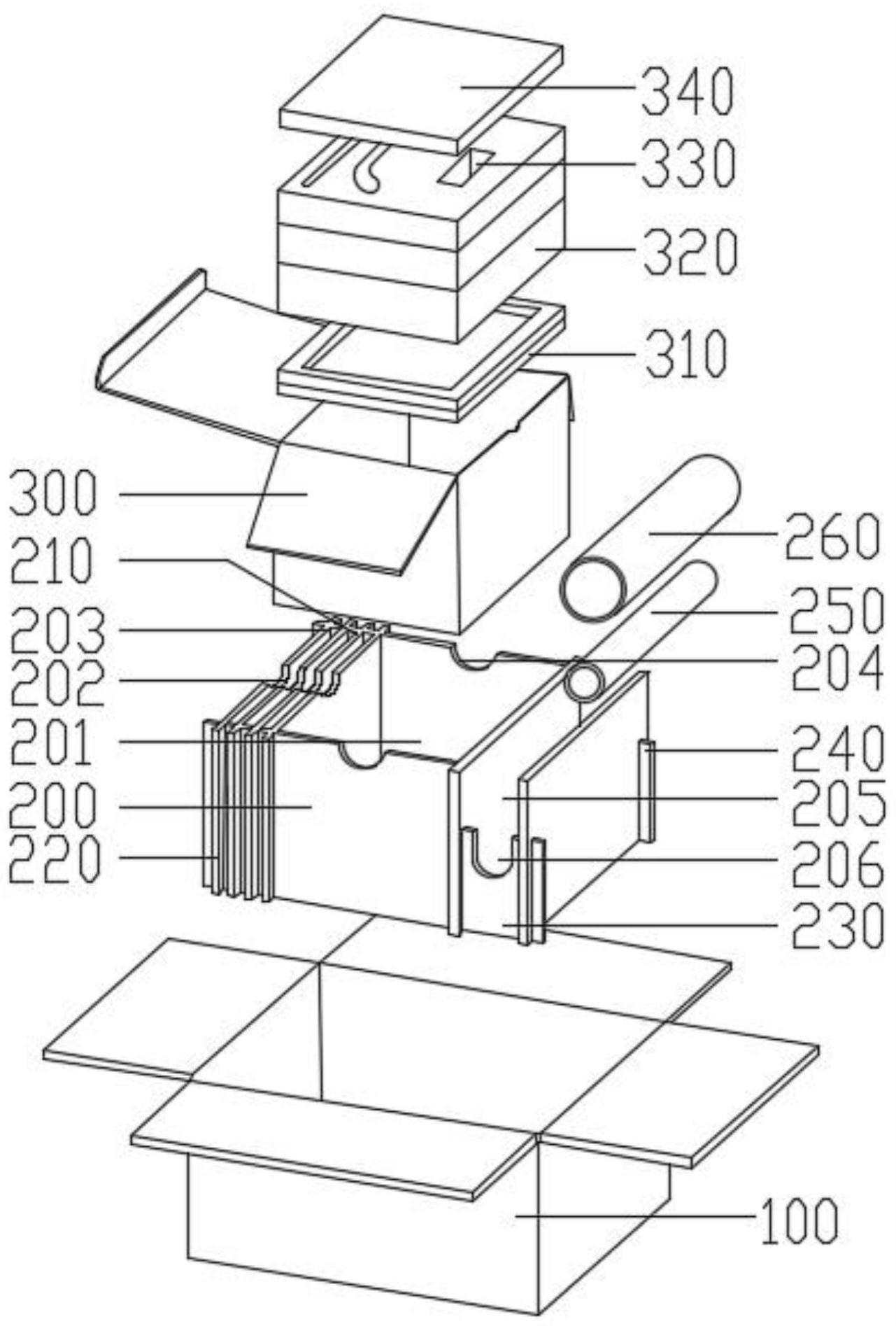

47.圖4示出了本發明的面向智奪旗博弈的深度強化學習系統的一實施例的原理圖。

具體實施方式

48.以下結合附圖和具體實施例對本發明作詳細描述。注意,以下結合附圖和具體實施例描述的諸方面僅是示例性的,而不應被理解為對本發明的保護范圍進行任何限制。

49.如圖1所示,本實施例的奪旗博弈框架中存在智能體的觀測信息不完美。智能體每一步可獲得的完美信息為己方智能體與旗幟的位置;不完美信息包含迷宮地圖中智能體視野范圍外的非己方信息。以a隊智能體1為例,其觀測范圍受限,如圖1中圈內范圍所示。當敵方旗幟在觀測范圍內時,智能體以其為目標進行探索;當敵方旗幟不在觀測范圍內時,智能體則進行隨機探索。智能體成功奪旗后,若觀測范圍內均為敵方領地,則進行隨機探索,直至探索到己方領地邊界線;若觀測范圍內有己方領地,其目標為在觀測范圍內己方領地邊界線上的點集,如圖1中陰影區域所示。此時,智能體在躲避敵方追擊的過程中不斷優化目標,選擇既能安全到達又距離較近的目標點,以促使智能體攜旗快速返回得分。

50.如圖2所示,本實施例提供了一種面向智奪旗博弈的深度強化學習方法,其具體步驟如下。

51.步驟1:將復雜戰場環境抽象為二維迷宮仿真環境,定義n個智能體,其中包含一組局部觀測一組動作和一組狀態s和狀態轉移函數對于每個智能體i,通過基本感知單元得到的局部觀測

52.步驟1中,迷宮地圖中心對稱,a、b兩隊分別駐扎在左右兩半區域。假設a、b兩隊智能體的駐地(初始出發位置)分別為地圖的左下角和右上角。同隊智能體可通過互聯網保持通信,異隊智能體的可觀范圍是在迷宮環境約束下,以智能體為圓心,半徑為5歐氏距離的范圍。動作集合指同隊所有智能體動作的集合。以a隊為例,包含智能體1的動作集{上1,下1,左1,右1,停1}與智能體2的動作集{上2,下2,左2,右2,停2}的5*5=25組動作組合。目標是到敵方區域奪取旗幟。具體而言,當智能體位于己方地圖時,該階段目標為保護己方旗幟,同時擊殺入侵的敵方智能體(兩方智能體位于同一坐標位置即實現擊殺。當智能體被擊殺后,在固定的駐地復活);當智能體位于敵方地圖時,該階段目標為奪取敵方旗幟,同時躲避敵方智能體的擊殺。智能體的移動速度相同,且在每一步都從動作集合中選取動作,當智能體移動到1200步時,奪旗博弈結束。在二維迷宮地圖環境限制下,智能體奪取旗幟后,僅當其成功返回己方領地時,才視為成功奪旗(積一分),最終得分高的隊伍獲勝。如果最終得分為零,則博弈以平局結束。

53.步驟2:特征提取步驟,提取輸入圖像的視覺特征。假定迷宮地圖的全景為fov,由于智能體僅可觀測一定距離視場內的環境信息,因此將智能體的觀測信息分解為3個通道,分別代表迷宮地圖,智能體以及旗幟。

54.其中,在卷積神經網絡后增加殘差網絡模塊,將前后連接的卷積神經網絡和殘差網絡模塊的特征連接在一起,用于減少過擬合并提高性能。具體而言,實現了一個具有3個堆疊resnet-101特征提取器,將卷積層conv5階段的第一個卷積塊的步幅由2修改為1,用于提高特征圖的分辨率,最終得到每一步的圖像特征圖。

55.步驟3:使用強化學習雙重決斗深度q網絡分別為分隊的智能體初始化各自的網絡,比如分別為兩隊的智能體初始化兩個網絡。遵循策略絡,比如分別為兩隊的智能體初始化兩個網絡。遵循策略得到智能體

動作集中選取動作的動作概率,并且通過與迷宮環境的交互,轉移到下一個狀態并獲得獎勵以判斷奪旗策略的好壞。初始狀態由初始狀態分布ρ:s

→

[0,1]來決定。每個智能體i都試圖最大化累積的折扣獎勵其中t是期望時間范圍,γ∈[0,1]是折扣參數。

[0056]

其中,從頭開始使用nvidia quadro rtx 8000gpu訓練強化學習雙重決斗深度q網絡至收斂,將評價網絡的權重初始化為θ,θ

′

,設置記憶d以存儲經驗回放,重放緩沖區最大規模為nr,訓練批次規模為nb′

,以及目標網絡更替頻率為n

rf

;設置目標距離閥值d

arrive

、碰撞距離閥值d

collision

、回合數為m。

[0057]

決斗深度q網絡通過將優勢函數設置為單個動作的優勢函數與所有動作的平均優勢函數之差來估計狀態值和每個動作的優勢,從而計算出最終的q值:

[0058][0059]

其中,θ為權重,α,β分別是雙重深度q網絡中主、輔深度q網絡的參數,s

t

、a

t

分別表示智能體在t時刻的狀態與動作。

[0060]

步驟4:根據智奪旗任務目標構造獎勵函數,根據由戰場環境抽象出的奪旗規則,需要達到以下目標:我方智能體在不被敵方智能體擊殺的條件下,奪取敵方的旗幟。

[0061]

其中,具體的獎勵函數設計公式如下:

[0062]

若鼓勵進攻動作時,獎勵r

offensive

包含智能體被敵方智能體擊殺的獎勵:r1=-30;智能體奪取敵方旗幟的獎勵:r2=300;當己方奪旗后,智能體獲得的邊界獎勵:當己方奪旗后,智能體獲得的距離獎勵:

[0063]

若鼓勵防守動作時,獎勵r

defensive

包含智能體擊殺敵方智能體的獎勵:r5=30;己方旗幟被奪的獎勵:r6=-300;當己方旗幟被奪后,智能體獲得的邊界獎勵:當己方旗幟被奪后,智能體獲得的距離獎勵:

[0064]

此外,一般的探索地圖獎勵r

else

包含智能體獲取敵方引導物的獎勵:r9=10,智能體觸碰迷宮障礙物的獎勵:r

10

=-500,智能體每步移動的獎勵:r

11

=-5。

[0065]

其中,d

enemy

表示智能體與敵方智能體的距離;d

boundary

表示智能體與a、b隊地圖邊界的距離。

[0066]

步驟5:在雙重決斗深度q網絡結構中加入圖注意力網絡。

[0067]

其中,圖注意力網絡能夠處理所有智能體的局部觀測值,從而定量確定智能體間的競合關系,有助于及時關注構成威脅的敵方智能體,從而避免被擊殺,具體計算過程如下:

[0068]

首先使用共享參數化矩陣w∈rf,其中f表示特征向量集的特征維度,目標智能體i的特征向量為hi,鄰域智能體{j∈ni}的特征向量hj。計算迷宮地圖中智能體間的注意力權重過程為:

[0069][0070]

其中,e

ij

為迷宮地圖中智能體oj對于智能體oi的貢獻程度,為注意力系數計算網絡。接著,使用softmax函數對每個智能體的所有鄰域智能體進行標準化,從而獲得標準化注意力系數a

ij

,使得不同智能體之間的注意力系數易于比較,計算過程為:

[0071][0072]

其中,ni表示目標智能體i的所有鄰域智能體(包括i本身)。計算a

ij

對應的智能體特征的線性組合,作為每個智能體的最終輸出,即

[0073][0074]

其中,h

′i包迷宮地圖中其他所有智能體的特征信息,因此無論智能體類別是否相同,不同智能體抽象向量的輸出表示不同,因此可以用于預測不同智能體的位置。

[0075]

步驟6:設置最大迭代輪次。

[0076]

其中,最大迭代輪次為1200。

[0077]

步驟7:根據智能體在該時刻的觀測信息和與隊友間的通訊信息,計算每一步各智能體間的注意力值。根據注意力值,智能體選擇偏向進攻/防守的動作a

t

。

[0078]

其中,計算每一步各智能體間的注意力值的計算過程如下:

[0079]

圖注意力層訓練一個參數化矩陣,進行智能體向量的特征變換后,得到共享參數化矩陣w∈rf和注意力系數計算網絡設在t時刻智能體i對周圍環境的觀測向量為提取特征后傳遞到圖注意力網絡,獲得智能體j對智能體i的標準化注意力系數a

ij

,從而增強了從智能體局部觀測中提取的特征。此外,使用多層感知,降維卷機神經網絡中提取的特征維數,有效減少了圖注意力網絡可共享的特征維度。具體而言,在每一個步,獲取t時刻智能體與目標的距離d

t

、環境的部分觀測o

t

和所有智能體的注意力權重a

ij

,然后,根據a

ij

選擇下一步動作偏向進攻/防守。智能體以ε概率選擇偏向動作a

t

,否則,,否則,并使用新的深度信息更新d

t

。

[0080]

步驟8:根據選取的獎勵函數執行動作,獲取經驗回放四元組。

[0081]

其中,在d

t

≤d

arrive

以及d

t

>d

collision

的條件下,如果智能體處于進攻狀態,獎勵為:r(o

t

,a

t

)=c(d

t-1-d

t

)+r

offensive

+r9+r

11

;如果智能體處于進攻狀態,那么此時的獎勵:r(o

t

,a

t

)=c(d

t-1-d

t

)+r

defensive

+r9+r

11

。在d

t

>d

arrive

以及d

t

>d

collision

的條件下,獎勵為:r(o

t

,a

t

)=r9+r

11

。其他條件下,獎勵為:r(o

t

,a

t

)=r

10

+r

11

。

[0082]

在此之后,智能體設置記憶d以存儲經驗回放,獲取經驗回放四元組,存放n個時刻

的經驗回放四元組(o

t

,a

t

,r

t

,o

t+1

)的本地緩沖區bu和經驗池mu,在智能體獲得獎勵后,按照時間順序將經驗回放四元組(o

t

,a

t

,r

t

,o

t+1

)存入緩沖區bi。

[0083]

步驟9:獲取新的環境部分觀測o

t+1

,更新經驗回放四元組,計算雙重決斗深度q網絡目標值。

[0084]

其中,智能體更新經驗回放四元組和計算雙重決斗深度q網絡目標值的過程如下:

[0085]

首先,智能體獲取新的環境部分觀測o

t+1

,設置重放緩沖區最大規模為nr,訓練批次規模為nb′

,以及目標網絡更替頻率為n

rf

。在記憶d中存儲轉移組(o

t

,a

t

,r

t

,o

t+1

),當|d|≥nr時,替換舊的元組。然后,在記憶d中隨機選擇一批nb′

的轉移組(ok,ak,rk,o

k+1

)。在此基礎上,使用時序差分計算雙重決斗深度q網絡目標值yk,在記憶d中隨機選擇一批訓練批次規模為nb′

的轉移組(ok,ak,rk,o

k+1

),

[0086]

對每個轉移組:

[0087][0088]

yk=rk+γq(o

k+1

,a

max

(o

k+1

|θ)|θ

′

)

[0089]

其中,γ為折現因子,取值為0.9,yk以(y

k-q(o,a|θ))2損失進行梯度下降更新。

[0090]

步驟10:反復執行步驟7-9,更新雙重決斗深度q網絡,直至迭代次數達到最大迭代次數。

[0091]

步驟10完成后,即可實現迷宮環境下的智奪旗博弈,智能體在每一步根據局部觀測范圍,結合對迷宮地圖的探索,采取偏向合作/競爭的動作,最終在避免被敵方襲擊的同時,快速、精準地奪取旗幟。

[0092]

如圖3所示,本實施例在一次奪旗博弈過程中的注意力值的變化,以a隊智能體1為例,由于圖注意力網絡求解得到標準注意力值,因此多智能體的注意力值在每一步均滿足a

12

+a

13

+a

14

=1。奪旗開始時,兩隊智能體從駐地出發,由于智能體可觀范圍的限制,在大約150步左右智能體1的觀測范圍內出現敵方智能體。因此在相遇前,a

12

=1,a

13

=a

14

=0。對于同隊合作的智能體1與智能體2而言,當a

12

=1時,智能體1僅與智能體2合作規劃路徑;當a

12

≠1時,智能體1既與智能體2合作規劃路徑,又與異隊智能體競爭避免被擊殺。類似地,對于異隊競爭的智能體1與智能體3而言,當a

13

=1時,智能體1僅與智能體3競爭;當a

13

≠1時,智能體1既與智能體3競爭,又與同隊智能體合作。因此,圖注意力網絡不僅能夠量化不完美信息下迷宮地圖中智能體合作與競爭的態勢,還能夠輔助智能體優化奪旗博弈策略,從而提升奪旗的成功率。

[0093]

圖4示出了本發明的面向智奪旗博弈的深度強化學習系統的一實施例的原理。請參見圖4,本實施例的系統包括:仿真模塊、特征提取模塊、初始化模塊、獎勵函數構造模塊、圖注意力網絡模塊、最大迭代輪次設置模塊、注意力值計算模塊、經驗回放四元組獲取模塊、網絡目標值計算模塊。

[0094]

仿真模塊,配置為將復雜戰場環境抽象為包括多個智能體在內的二維迷宮仿真環境。仿真模塊進一步配置為:定義n個智能體,其中包含一組局部觀測一組動作和一組狀態s和狀態轉移函數和一組狀態s和狀態轉移函數對于每個智能體i,通過基本感知單元得到的局部觀測

[0095]

仿真模塊的具體實現內容與上述方法實施例的步驟1相同,在此不再贅述。

[0096]

特征提取模塊,配置為基于卷積神經網絡分通道提取輸入圖像的視覺特征。特征提取模塊進一步配置為:在卷積神經網絡后增加殘差網絡模塊,將前后連接的卷積神經網絡和殘差網絡模塊的特征連接在一起,用于減少過擬合。

[0097]

特征提取模塊的具體實現內容與上述方法實施例的步驟2相同,在此不再贅述。

[0098]

初始化模塊,配置為使用強化學習雙重決斗深度q網絡分別為分隊的智能體初始化對應的網絡。

[0099]

初始化模塊的具體實現內容與上述方法實施例的步驟3相同,在此不再贅述。

[0100]

獎勵函數構造模塊,配置為根據智奪旗任務目標構造獎勵函數,根據由戰場環境抽象出的奪旗規則,設置需要達到的目標。獎勵函數構造模塊進一步配置為:需要達到的目標為:我方智能體在不被敵方智能體擊殺的條件下,奪取敵方的旗幟。

[0101]

獎勵函數構造模塊的具體實現內容與上述方法實施例的步驟4相同,在此不再贅述。

[0102]

圖注意力網絡模塊,配置為在雙重決斗深度q網絡結構中加入圖注意力網絡。圖注意力網絡模塊的具體實現內容與上述方法實施例的步驟5相同,在此不再贅述。

[0103]

最大迭代輪次設置模塊,配置為設置最大迭代輪次。最大迭代輪次設置模塊的具體實現內容與上述方法實施例的步驟6相同,在此不再贅述。

[0104]

注意力值計算模塊,配置為根據智能體在該時刻的觀測信息和與隊友間的通訊信息,計算每一步各智能體間的注意力值,智能體根據注意力值選擇偏向進攻/防守的動作。

[0105]

注意力值計算模塊的具體實現內容與上述方法實施例的步驟7相同,在此不再贅述。

[0106]

經驗回放四元組獲取模塊,配置為根據選取的獎勵函數執行動作,獲取經驗回放四元組。

[0107]

注意力值計算模塊的具體實現內容與上述方法實施例的步驟8相同,在此不再贅述。

[0108]

網絡目標值計算模塊,配置為獲取新的環境部分觀測,更新經驗回放四元組,計算雙重決斗深度q網絡目標值。

[0109]

網絡目標值計算模塊的具體實現內容與上述方法實施例的步驟9相同,在此不再贅述。

[0110]

反復執行注意力值計算模塊、經驗回放四元組獲取模塊和網絡目標值計算模塊,更新雙重決斗深度q網絡,直至迭代次數達到最大迭代次數,實現迷宮環境下的智奪旗博弈。智能體在每一步根據局部觀測范圍,結合對迷宮地圖的探索,采取偏向合作/競爭的動作,最終在避免被敵方襲擊的同時,快速、精準地奪取旗幟。

[0111]

盡管為使解釋簡單化將上述方法圖示并描述為一系列動作,但是應理解并領會,這些方法不受動作的次序所限,因為根據一個或多個實施例,一些動作可按不同次序發生和/或與來自本文中圖示和描述或本文中未圖示和描述但本領域技術人員可以理解的其他動作并發地發生。

[0112]

本領域技術人員將進一步領會,結合本文中所公開的實施例來描述的各種解說性邏輯板塊、模塊、電路、和算法步驟可實現為電子硬件、計算機軟件、或這兩者的組合。為清楚地解說硬件與軟件的這一可互換性,各種解說性組件、框、模塊、電路、和步驟在上面是以

其功能性的形式作一般化描述的。此類功能性是被實現為硬件還是軟件取決于具體應用和施加于整體系統的設計約束。技術人員對于每種特定應用可用不同的方式來實現所描述的功能性,但這樣的實現決策不應被解讀成導致脫離了本發明的范圍。

[0113]

結合本文所公開的實施例描述的各種解說性邏輯板塊、模塊、和電路可用通用處理器、數字信號處理器(dsp)、專用集成電路(asic)、現場可編程門陣列(fpga)或其它可編程邏輯器件、分立的門或晶體管邏輯、分立的硬件組件、或其設計成執行本文所描述功能的任何組合來實現或執行。通用處理器可以是微處理器,但在替換方案中,該處理器可以是任何常規的處理器、控制器、微控制器、或狀態機。處理器還可以被實現為計算設備的組合,例如dsp與微處理器的組合、多個微處理器、與dsp核心協作的一個或多個微處理器、或任何其他此類配置。

[0114]

結合本文中公開的實施例描述的方法或算法的步驟可直接在硬件中、在由處理器執行的軟件模塊中、或在這兩者的組合中體現。軟件模塊可駐留在ram存儲器、閃存、rom存儲器、eprom存儲器、eeprom存儲器、寄存器、硬盤、可移動盤、cd-rom、或本領域中所知的任何其他形式的存儲介質中。示例性存儲介質耦合到處理器以使得該處理器能從/向該存儲介質讀取和寫入信息。在替換方案中,存儲介質可以被整合到處理器。處理器和存儲介質可駐留在asic中。asic可駐留在用戶終端中。在替換方案中,處理器和存儲介質可作為分立組件駐留在用戶終端中。

[0115]

在一個或多個示例性實施例中,所描述的功能可在硬件、軟件、固件或其任何組合中實現。如果在軟件中實現為計算機程序產品,則各功能可以作為一條或更多條指令或代碼存儲在計算機可讀介質上或藉其進行傳送。計算機可讀介質包括計算機存儲介質和通信介質兩者,其包括促成計算機程序從一地向另一地轉移的任何介質。存儲介質可以是能被計算機訪問的任何可用介質。作為示例而非限定,這樣的計算機可讀介質可包括ram、rom、eeprom、cd-rom或其它光盤存儲、磁盤存儲或其它磁存儲設備、或能被用來攜帶或存儲指令或數據結構形式的合意程序代碼且能被計算機訪問的任何其它介質。任何連接也被正當地稱為計算機可讀介質。例如,如果軟件是使用同軸電纜、光纖電纜、雙絞線、數字訂戶線(dsl)、或諸如紅外、無線電、以及微波之類的無線技術從web網站、服務器、或其它遠程源傳送而來,則該同軸電纜、光纖電纜、雙絞線、dsl、或諸如紅外、無線電、以及微波之類的無線技術就被包括在介質的定義之中。如本文中所使用的盤(disk)和碟(disc)包括壓縮碟(cd)、激光碟、光碟、數字多用碟(dvd)、軟盤和藍光碟,其中盤(disk)往往以磁的方式再現數據,而碟(disc)用激光以光學方式再現數據。上述的組合也應被包括在計算機可讀介質的范圍內。

[0116]

提供對本公開的先前描述是為使得本領域任何技術人員皆能夠制作或使用本公開。對本公開的各種修改對本領域技術人員來說都將是顯而易見的,且本文中所定義的普適原理可被應用到其他變體而不會脫離本公開的精神或范圍。由此,本公開并非旨在被限定于本文中所描述的示例和設計,而是應被授予與本文中所公開的原理和新穎性特征相一致的最廣范圍。

技術特征:

1.一種面向智奪旗博弈的深度強化學習方法,其特征在于,方法包括:步驟1:將復雜戰場環境抽象為包括多個智能體在內的二維迷宮仿真環境;步驟2:基于卷積神經網絡分通道提取輸入圖像的視覺特征;步驟3:使用強化學習雙重決斗深度q網絡分別為分隊的智能體初始化對應的網絡;步驟4:根據智奪旗任務目標構造獎勵函數,根據由戰場環境抽象出的奪旗規則,設置需要達到的目標;步驟5:在雙重決斗深度q網絡結構中加入圖注意力網絡;步驟6:設置最大迭代輪次;步驟7:根據智能體在該時刻的觀測信息和與隊友間的通訊信息,計算每一步各智能體間的注意力值,智能體根據注意力值選擇偏向進攻/防守的動作;步驟8:根據選取的獎勵函數執行動作,獲取經驗回放四元組;步驟9:獲取新的環境部分觀測,更新經驗回放四元組,計算雙重決斗深度q網絡目標值;步驟10:反復執行步驟7-9,更新雙重決斗深度q網絡,直至迭代次數達到最大迭代次數,實現迷宮環境下的智奪旗博弈。2.根據權利要求1所述的面向智奪旗博弈的深度強化學習方法,其特征在于,步驟1進一步包括:定義n個智能體,其中包含一組局部觀測一組動作和一組狀態s和狀態轉移函數對于每個智能體i,通過基本感知單元得到的局部觀測3.根據權利要求1所述的面向智奪旗博弈的深度強化學習方法,其特征在于,步驟2進一步包括:在卷積神經網絡后增加殘差網絡模塊,將前后連接的卷積神經網絡和殘差網絡模塊的特征連接在一起,用于減少過擬合。4.根據權利要求1所述的面向智奪旗博弈的深度強化學習方法,其特征在于,步驟4進一步包括:需要達到的目標為:我方智能體在不被敵方智能體擊殺的條件下,奪取敵方的旗幟。5.一種面向智奪旗博弈的深度強化學習系統,其特征在于,系統包括:仿真模塊,配置為將復雜戰場環境抽象為包括多個智能體在內的二維迷宮仿真環境;特征提取模塊,配置為基于卷積神經網絡分通道提取輸入圖像的視覺特征;初始化模塊,配置為使用強化學習雙重決斗深度q網絡分別為分隊的智能體初始化對應的網絡;獎勵函數構造模塊,配置為根據智奪旗任務目標構造獎勵函數,根據由戰場環境抽象出的奪旗規則,設置需要達到的目標;圖注意力網絡模塊,配置為在雙重決斗深度q網絡結構中加入圖注意力網絡;最大迭代輪次設置模塊,配置為設置最大迭代輪次;注意力值計算模塊,配置為根據智能體在該時刻的觀測信息和與隊友間的通訊信息,計算每一步各智能體間的注意力值,智能體根據注意力值選擇偏向進攻/防守的動作;

經驗回放四元組獲取模塊,配置為根據選取的獎勵函數執行動作,獲取經驗回放四元組;網絡目標值計算模塊,配置為獲取新的環境部分觀測,更新經驗回放四元組,計算雙重決斗深度q網絡目標值;反復執行注意力值計算模塊、經驗回放四元組獲取模塊和網絡目標值計算模塊,更新雙重決斗深度q網絡,直至迭代次數達到最大迭代次數,實現迷宮環境下的智奪旗博弈。6.根據權利要求5所述的面向智奪旗博弈的深度強化學習系統,其特征在于,仿真模塊進一步配置為:定義n個智能體,其中包含一組局部觀測一組動作和一組狀態s和狀態轉移函數對于每個智能體i,通過基本感知單元得到的局部觀測7.根據權利要求5所述的面向智奪旗博弈的深度強化學習系統,其特征在于,特征提取模塊進一步配置為:在卷積神經網絡后增加殘差網絡模塊,將前后連接的卷積神經網絡和殘差網絡模塊的特征連接在一起,用于減少過擬合。8.根據權利要求5所述的面向智奪旗博弈的深度強化學習系統,其特征在于,獎勵函數構造模塊進一步配置為:需要達到的目標為:我方智能體在不被敵方智能體擊殺的條件下,奪取敵方的旗幟。

技術總結

本發明公開了一種面向智奪旗博弈的深度強化學習方法和系統,解決不完美信息條件下外部競爭、內部合作的智路徑規劃與奪旗的問題。具體而言,首先基于卷積神經網絡的分通道提取圖片特征;然后,基于圖注意力網絡根據自身觀測信息與接收到的隊友觀測信息,定量確定不完美信息條件下各智能體間的競合關系,使得智能體在決策時,充分考慮其他智能體的狀態;最后,根據對于場上不同智能體的注意力值,輔助多智能體雙重決斗深度Q網絡實現多智能體在二維迷宮環境中的路徑規劃與自主導航,優化智奪旗策略,以實現快速、精準地二對二奪旗。精準地二對二奪旗。精準地二對二奪旗。