基于語義驅動的前背景區分視頻描述生成系統

1.本發明屬于跨媒體生成技術領域,具體涉及基于語義驅動的前背景區分視頻描述生成系統。

背景技術:

2.在各種多模態信息處理任務中,視頻描述自動生成(video captioning)是一項非常重要的任務,其在視頻分析領域是一項基礎性的研究任務。該任務為給定一段視頻,計算機自動分析視頻內容,生成描述視頻主要內容的語句。該任務是在圖像描述自動生成任務(image captioning)基礎上發展而來,但視頻與圖像存在顯著性差異,視頻可被看作為多幅圖像的集合,其特征多樣性與內容場景復雜性都遠遠超出圖像,因此視頻描述自動生成技術難度及挑戰性也遠高于圖像描述生成技術。該項任務涉及到人工智能的兩個研究領域,即計算機視覺(compute vision,cv)和自然語言處理(natural language processing,nlp),其在兩個領域搭起橋梁將兩者緊密聯系起來。從計算機角度出發,理解一段視頻并不能和人類分析視頻一樣簡單。目前,圖像分析對于圖像表示一般采取將其處理成一維向量,依照這種方式視頻便為一組序列向量的集合。如何改進圖像描述生成技術,將其轉換為視頻描述生成技術,這都是早期研究方向。此外,對于視頻中的多種模態信息,如何將其合理應用以加強語句描述生成的質量,這些都區別于圖像描述生成技術。

3.描述生成技術(captioning)一般采用編碼-解碼(encoder-decoder)框架,編碼器常采用卷積神經網絡cnn(convolution neural network)提取視頻幀特征,解碼器采用循環神經網絡rnn(recurrent neural network)生成序列語句。cnn能將圖像信息進行提煉,得到其高層語義表示,在圖像分類、目標檢測等領域具有很好效果;rnn則由于其良好的序列生成能力而在自然語言處理領域中得到廣泛應用,在描述生成方向也被廣泛采用。cnn結合rnn,分別對應于計算機視覺與自然語言處理,是語句描述生成模型的基本框架。

4.早期研究工作通常借鑒圖像描述生成技術,將圖像特征輸入改為視頻特征輸入,然后生成描述性語句。這類方法需要將序列特征轉換為單一的、與圖像表示一致的特征,較為簡單的處理是采用池化層對序列進行均值處理,也有進行關鍵幀檢測,只將關鍵幀輸入至生成模型中。此類方法都會在一定程度上造成信息損失,破壞視頻內容豐富度。之后,基于時序注意力機制在每個時刻對幀序列特征進行采樣加權,并賦予不同權重,在生成文本描述時單詞的關注信息不同。這些方法都主要集中于視覺特征處理上,即集中于編碼階段。隨著自然語言處理的發展,生成模型也在不斷進步,基于cnn、transformer的解碼器也逐漸應用于視頻描述生成任務。

5.盡管現有工作在視頻自動描述任務上取得很大進步,但對于視頻本身的特性并未挖掘完全,對于視頻處理依舊十分粗糙,通常整體考慮一個視頻而忽略其中場景切換對視頻信息編碼的影響。為解決上述問題,非常有必要對視頻不同場景進行區分,對視頻不同場景信息進行分別編碼,更加全面考慮視頻時序信息,生成更為精確的語義描述。本發明就是由此激發,采用前背景區分網絡對視頻內部信息進行區分,隨后分別進行視頻編碼,充分利

用視頻時序信息,針對視頻生成更好的描述性語句。

技術實現要素:

6.本發明所解決的問題是針對視頻描述任務,現有模型在處理視頻有關時序信息的利用。為解決所述問題,本發明提供基于語義驅動的前背景區分視頻描述生成系統。

7.本發明提供的基于語義驅動的前背景區分視頻描述生成系統,包括:視頻特征提取網絡、前背景區分網絡、特征編碼網絡以及描述生成網絡;所述視頻特征提取網絡獲取視頻的多種特征向量表示,并輸入至前背景區分網絡中;所述前背景區分網絡根據語義錨點(描述句子中比較重要的組件,主語,謂語,賓語)對特征區分為前景與背景,其中前景表示視頻中的高光片段,背景為其余片段,再輸入至特征編碼網絡中;所述特征編碼網絡對前景和背景進行對齊,隨后對前背景分別進行編碼,再輸入至描述生成網絡;所述描述生成網絡采用一個前背景門機制控制模塊和一個單層gru模型作為解碼器,根據視頻特征輸出對應的視頻描述。本發明對視頻序列特征進行區分,在生成描述語句時充分利用視頻幀的前景和背景信息,使得生成更為精確。這對于視頻分析和多模態信息研究具有重要意義,能夠提高模型對視頻視覺信息的理解能力,具有廣泛應用價值。

8.本發明中,所述視頻特征提取網絡,包含inceptionresnetv2與i3d深度卷積網絡。對于視頻進行幀采樣,采樣按照等間隔進行,一個視頻最終對應于26幀,每一幀通過inceptionresnetv2網絡映射為1,536維向量;并通過i3d網絡,獲取視頻的i3d特征。最終,對于一個視頻,其特征包含inceptionresnetv2特征26*1,536、及i3d特征26*1,024。

9.本發明中,所述前背景區分網絡,根據語義信息對視頻幀進行前景和背景劃分,語義信息生成方式如下:

[0010][0011]

其中,表示grus的第t時間步的隱藏層狀態;w

t-1

∈{subject,verb,object}代表在t-1步預測的獨熱向量(該向量有多維,其中只有一維值為1其余都為0);we表示一個可學習的詞嵌入矩陣參數;vg是利用iceptionresnetv2提取的特征va和利用i3d深度卷積網絡提取的特征vm拼接得到。att函數如下所示:

[0012][0013]

最后,grus的最后一層隱層輸出被當作語義錨點ρs。

[0014]

為選取前景,首先需要計算v

*

和ρs之間的相關φ

*

,計算方式如下:

[0015][0016]

其中,w

*

,w

*h

,b

*

均為可學習的參數,*代表對于不同特征va,vm的不同操作;tanh表示雙曲正切函數;隨后利用topk函數計算前景向量z

*

,由于該操作不可導而利用gumbel-softmax策略分別計算前向傳播和后向傳播:

[0017][0018]

其中,g是gumbelnoise,與gumbel(0,1)獨立同分布;τ為調節softmax強度的溫度

參數;f(

·

)為log函數;forward表示前向傳播,backward表示反向傳播。s

*

是由φ

*

經過softmax函數計算得到,函數topk表達式如下:

[0019][0020]

其中,k為x中第n大的數,通常n可取8。隨后,利用前景向量z

*

分別獲取前景和背景特征:

[0021][0022][0023]

其中,和分別代表前景和背景;1表示值全為1的向量;diag(x)表示對角線由x填充的矩陣。

[0024]

本發明中,所述特征編碼網絡,即通過前背景區分網絡區分出的前景和背景最終輸出經過編碼的前背景特征表示,其流程如下:首先,利用如下公式對齊va與vm:

[0025][0026][0027]

ffn(x)=ln(relu(xw1)w2+x),

???

#(10)

[0028]

mha(q,v)=ln([h1;

…

;hh]wo+q),

???

#(11)

[0029][0030]

其中,和表示可學習得參數;q,[

·

;

·

]表示拼接操作;ln表示層歸一化操作。

[0031][0032]

其中,d表示輸入特征向量的維度。然后,將和拼接起來獲得對齊后的前景特征隨后,應用如下公式進一步編碼公式如下:

[0033][0034]

在同樣計算方式下,可通過公式(8)-(14)得到背景表示

[0035]

本發明中,所述描述生成網絡,采用循環神經網絡作為生成器進行語句生成;采用一個前背景門機制控制模塊和一個單層gru模型作為解碼器;前背景門機制控制模塊用于分別關注前景和背景信息,由gru進行句子解碼,最終采用gru

de

的輸出預測下一時刻單詞;

[0036]

前背景門機制控制模塊在t時刻的輸入包含三部分,即前一時刻的gru

de

隱藏狀態h

t-1

、經過分別編碼的前背景特征和其輸出為定義如下所示:

[0037][0038]

[0039][0040]

其中,是gru

de

在第t-1步的隱藏層輸出;wr是可學習的參數矩陣;σ代表sigmoid函數。隨后,根據前背景門機制控制模塊的輸出對前景和背景特征進行加權融合,得到最終的輸出

[0041][0042]

其中,

⊙

代表哈達瑪積;f(

·

)是線性變換操作;wf是一個可學習的參數矩陣。

[0043]

對于單層gru

de

解碼器,其輸入包括四部分,即t時間步前背景門控機制控制模塊輸出、t-1時刻gru

de

的隱藏層輸出與語義錨點的注意力輸出,t-1時刻所對應的詞向量、及gru

de

的t-1時刻隱層輸出,定義如下:

[0044][0045]

其中,we表示詞向量矩陣;w

t-1

表示t-1時間步預測出的單詞的獨熱向量。最后利用ρ

de

表示gru

de

最后一步的隱藏層輸出,包含完整描述信息,在優化時拉近ρ

de

和ρs的距離。最后,利用一個雙層mlp網絡和tanh激活函數(雙曲正切函數)進行第t步的單詞概率預測。

[0046]

本發明提供基于語義驅動的前背景區分視頻描述生成系統,其工作流程為:

[0047]

(一)所述視頻特征提取網絡,對視頻進行幀采樣,利用inceptionresnetv2網絡提取視頻的幀級序列特征向量,同時獲取視頻的i3d特征序列表示;

[0048]

(二)所述前背景區分網絡,對視頻特征序列進行區分。其中本發明所提出方法主要利用語義錨點進行區分,首先利用原始視頻特征生成語義錨點,隨后利用視頻特征與語義錨點的相似度來進行前景和背景區分;

[0049]

(三)所述特征編碼網絡,利用視頻特征之間相互計算相似度的方法進行信息交互和融合,將經過編碼的視頻前背景特征輸入描述生成網絡;

[0050]

(四)所述描述生成模型,包括一個前背景門機制控制模塊和一個單層gru作為解碼器,前背景門機制控制模塊用于分別關注前景和背景信息,進行信息融合后送入gru進行句子描述解碼生成。

[0051]

較之已有相關視頻描述生成方法,本發明提出的方法具有兩大優勢,即將視頻前背景進行區分,將區分后的前背景信息分別編碼,充分利用視頻前背景信息生成更加精確豐富的描述。第一,針對視頻前背景區分體現在,本發明所提出的模型采用基于語義錨點的前背景區分網絡對視頻進行區分,在區分過程中按和語義錨點的相似度進行,已有方法則基本完全忽視視頻中的場景區分,視整個視頻為單獨唯一場景。第二,針對視頻前背景信息分別編碼的利用體現在,本發明所提出方法采用自注意力機制對不同場景特征分別進行信息編碼,在編碼過程中充分考慮特征與特征之間的聯系,并采用特征之間的相似度作為信息融合的權重值。第三,更為準確的單詞預測體現在,本發明所提出方法在預測單詞時采用門機制分別關注前景和背景信息,生成視覺綜合信息預測下一時刻單詞,豐富語句生成。

[0052]

綜上所述,本發明針對于視頻描述生成任務中視頻場景信息、及單詞預測提出相應算法模型,即基于語義驅動的前背景區分視頻描述生成方法,使得視頻中的多模態信息得以利用,描述性語句生成更為精確。本發明所提出方法可應用于針對大規模視頻的描述生成,生成對應視頻內容的精確描述性語句,提高可用性和用戶體驗。

附圖說明

[0053]

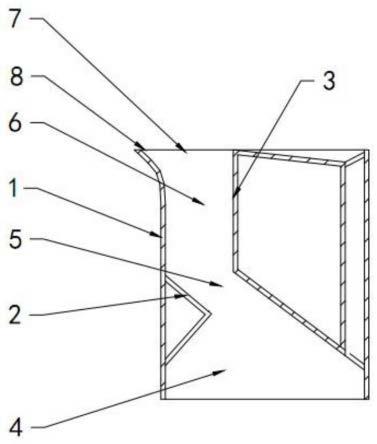

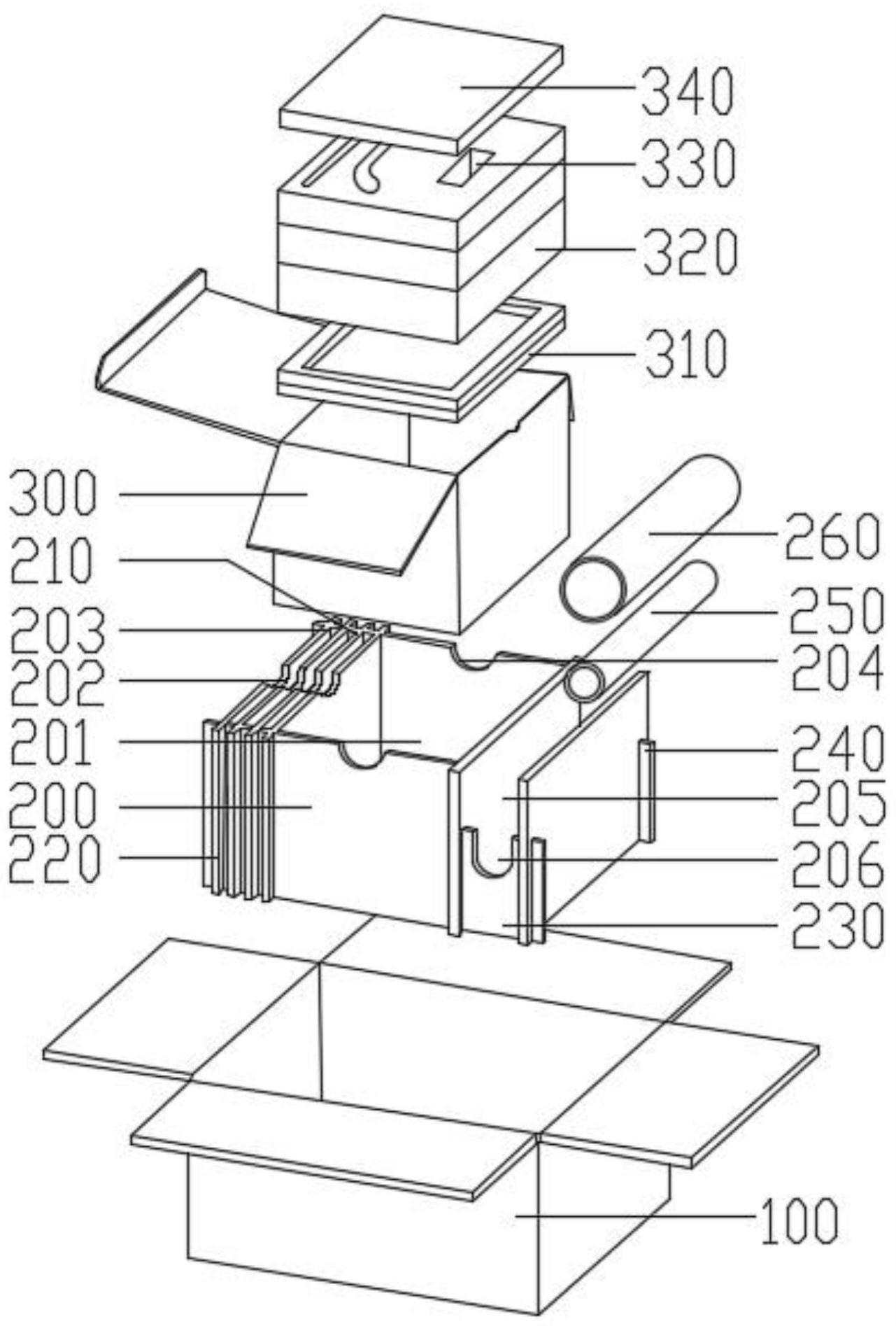

圖1為本發明系統圖示。

[0054]

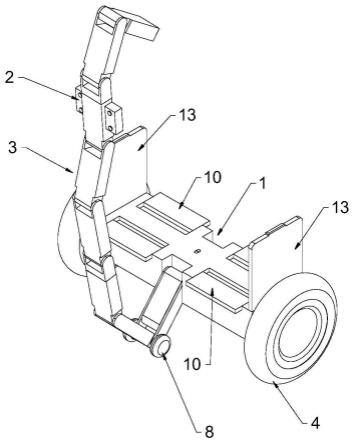

圖2為本發明中的模型框架示意圖。

具體實施方式

[0055]

由背景技術可知,現有視頻描述生成方法針對視頻內部不同場景利用不合理的情況。本發明針對所述問題進行研究,引入前背景區分網絡,對視頻內部的視覺信息進行區分,在區分過程中充分考慮到視頻特征和語義錨點的相似度,并采用一層gru作為解碼器進行最終描述語句生成,在生成過程中采用一個前背景門機制融合視頻特征,使得視頻描述生成更為精確。本發明所提出模型適用于所有基于編碼-解碼模式的視頻描述生成技術,能顯著提高生成語句的精度。

[0056]

下文中,結合附圖對本發明的具體細節作以闡述。

[0057]

如圖1所示,本發明所提出基于語義驅動的前背景區分視頻描述生成系統,包括視頻特征提取網絡、前背景區分網絡、視頻編碼網絡、及語句描述生成網絡。其工作流程為:

[0058]

流程一:所述視覺特征提取網絡,針對所獲取視頻進行幀采樣,并利用深度卷積網絡獲取幀的視覺特征向量表示26*1,536。所述深度卷積網絡可選用圖像分類任務中的深度卷積模型,本發明采用inceptionresnetv2網絡。為增強視頻的視覺標識,提取視頻的i3d特征26*1,024。此外,為實現更好的表示能力,對特征進行維度轉換,均轉換為1,300維度,即inceptionresnetv2特征26*1300與i3d特征26*1300。

[0059]

在流程一中,對于視頻特征提取進行兩個層次的提取,一是單獨幀的特征提取,另一是以幀為中心前后多幀一同編碼的特征。由于前述兩種特征包含細粒度物體特征,本發明并未采用額外的預訓練模型提取物體特征。

[0060]

流程二:所述前背景網絡對于獲取的視覺特征進行區分。其具體流程如下所示:

[0061]

(一)根據原始視頻特征生成語義錨點,為句子描述的主語,謂語和賓語,語義錨點為循環神經網絡的最后一層隱藏層輸出;

[0062][0063]

(二)利用語義錨點與視頻特征的相似度進行前景和背景區分。計算特征和語義錨點的相似度分數,隨后進行歸一化處理,選取分數前k大者作為前景信息,其余作為背景信息。對于inceptionresnetv2特征與i3d特征,都進行相似處理。對于區分向量的具體計算,如下所示:

[0064][0065][0066][0067]

(三)、根據所述區分向量對視頻特征進行區分,具體過程如下:

[0068]

[0069][0070]

在流程二中,對于視頻信息進行兩個層次處理,一是對inceptionresnetv2特征進行區分,另一是對于i3d特征序列區分。特征區分過程采用前背景區分網絡,使得區分后的特征更適合視頻語句描述生成。

[0071]

流程三:所述特征編碼網絡,對于視頻前景背景特征分別進行編碼,同時分別對前景背景信息采用自注意力機制,將相似度作為權值進行加權,得到前景特征表示26*1,300、背景特征26*1,300。其具體計算方式如下:

[0072][0073][0074][0075][0076][0077][0078]

在流程三中,利用特征編碼網絡將區分后的特征序列轉換進行編碼,以便于之后解碼器更好地利用前背景信息對視頻進行分析,預測下一時刻的單詞概率分布。

[0079]

流程四:所述語句描述生成模型,采用一個前背景門機制控制模塊和一個單層gru作為解碼器。前背景編碼器輸入包含前一時刻的gru

de

隱藏狀態經過分別編碼的前背景特征和其輸出為gru

de

輸入包含t時間步前背景門控機制控制模塊輸出,t-1時刻gru

de

的隱藏層輸出與語義錨點的注意力輸出、t-1時刻所對應的詞向量、及gru

de

t-1時刻的隱層輸出。采用gru

de

隱藏層輸出和mlp網絡預測下一時刻單詞概率分布p(s

t

),其具體操作如下:

[0080][0081][0082][0083][0084][0085][0086]

在流程四中,相較于之前視頻描述生成方法,改進在于,采用分別關注前背景的語言模型,包含t時刻關注的前景中的信息,包含t-1時刻關注背景中的信息,兩者加權融合的結果為更適合單詞預測的視頻特征表示,有助于聯系更多細節信息加強當前時刻的單詞預測。

[0087]

具體流程可視化如圖2所示,按照步驟一至四依次進行,即可得到視頻描述語句。

此外,在生成語句描述時,采用beamsearch方法來篩選最優語句,有效避免單詞采樣偏差。在本發明提出的方法中,將beamsize的值設為3,以平衡精度與時間代價的關系。

[0088]

本發明實例選用數據集msvd和msr-vtt,msvd包含1,970個視頻,msvd包含10,000個視頻。兩者均采用標準的數據集劃分,在msvd測試集上bleu-4、cider、meteor、及rouge值分別為57.3、100.3、36.8、及73.8。在msr-vtt上,bleu-4、cider、meteor、及rouge值分別為42.3、50.4、28.0、及60.9。

[0089]

本發明不但適用于所述模型框架,也適用所有基于編碼-解碼的視頻描述生成方法,同時適用于不采用循環神經網絡作為解碼器的視頻描述生成方法,具體實踐為將本發明的特征區分過程加入編碼階段,將本發明的語句描述生成融入解碼階段。

[0090]

本發明雖然已以較佳實施例公開如上,但其并不是用來限定本發明,任何本領域技術人員在不脫離本發明的精神和范圍內,都可以利用上述揭示的技術內容對本發明技術方案做出可能的變動和修改,因此,凡是未脫離本發明技術方案的內容,依據本發明的技術實質對以上實施例所作的任何簡單修改、等同變化及修飾,均屬于本發明技術方案的保護范圍。